Когда-то суперкомпьютеры ассоциировались в представлениях ИТ-специалистов исключительно с очень «большими компьютерами» и с такими компаниями, как Burroughs, CDC, Cray, IBM, SGI. Этот период суперкомпьютинга можно назвать развитием «вглубь». Однако лет пять назад вместе с появлением недорогих, но высокопроизводительных кластеров произошел сдвиг парадигмы (скорее всего, временный или, может быть, частичный), в результате которого суперкомпьютинг начал развиваться «вширь», становясь все более массовым. Доступность кластеров привела к тому, что в сознании любителей громких цифр высокопроизводительные вычислительные системы (High Performance Computing, HPC) оказались отождествлены с кластерами. Увлечение развитием вширь вполне оправдано— для целого ряда задач относительно дешевые кластерные решения являются оптимальными, но никто не отменял и развития вглубь. Это направление позволяет использовать мощные вычислительные машины не только как инструмент численного моделирования, и сейчас именно его наиболее активно поддерживает финансирующее перспективные оборонные исследования подведомственное Пентагону агентство DARPA в рамках своей программы по развитию вычислительных систем высокой продуктивности (High Productivity Computing Systems, HPCS).

Когда-то суперкомпьютеры ассоциировались в представлениях ИТ-специалистов исключительно с очень «большими компьютерами» и с такими компаниями, как Burroughs, CDC, Cray, IBM, SGI. Этот период суперкомпьютинга можно назвать развитием «вглубь». Однако лет пять назад вместе с появлением недорогих, но высокопроизводительных кластеров произошел сдвиг парадигмы (скорее всего, временный или, может быть, частичный), в результате которого суперкомпьютинг начал развиваться «вширь», становясь все более массовым. Доступность кластеров привела к тому, что в сознании любителей громких цифр высокопроизводительные вычислительные системы (High Performance Computing, HPC) оказались отождествлены с кластерами. Увлечение развитием вширь вполне оправдано— для целого ряда задач относительно дешевые кластерные решения являются оптимальными, но никто не отменял и развития вглубь. Это направление позволяет использовать мощные вычислительные машины не только как инструмент численного моделирования, и сейчас именно его наиболее активно поддерживает финансирующее перспективные оборонные исследования подведомственное Пентагону агентство DARPA в рамках своей программы по развитию вычислительных систем высокой продуктивности (High Productivity Computing Systems, HPCS).

Развитие продуктивных систем HPCS не исключает развития кластерных систем HPC. Можно с уверенностью говорить, что HPC— одна из составляющих HPCS; более того, по мере развития технологий коммутации вполне возможна конвергенция различных компьютерных архитектур. В предвидении этого практически все американские правительственные ведомства, определяющие национальную политику в области науки и технологий (DARPA, Национальный научный фонд США, космическое агентство NASA и ряд других организаций), выдвигают на следующее пятилетие в качестве одного из приоритетных направлений развития информационных технологий высокопроизводительные вычислительные системы. Собственные отраслевые программы по развитию HPC осуществляют также Министерство энергетики США и другие ведомства. Все эти отдельные программы косвенным образом скоординированы между собой тем, что реализуются ограниченным числом крупных производителей аппаратного и программного обеспечения, а исследования сосредоточены в ведущих университетах и национальных лабораториях.

Особое положение и особое внимание к HPC продиктовано тем, что независимо от предметной области современная наука и инженерия подошли к рубежу, за которым стоит множество проблем, практически неразрешимых в рамках существующих технологий моделирования и расчетных методов. Нынешнюю ситуацию в науке можно в некоторой мере признать критической: на многих направлениях исследований традиционные аналитические методы либо исчерпали себя, либо не позволяют двигаться вперед требуемыми темпами. Предполагается, что использование HPC позволит продолжить исследования в самых разных областях, в том числе связанных с расшифровкой генома человека, анализом феноменов поведения, возникающих в больших сообществах, созданием физической модели звездных образований, прогнозированием климатических изменений в экосистеме Земли, решением проблемы синтеза новых материалов на атомарном уровне, оптимизацией управления сложными инфраструктурами, прогнозированием техногенных катастроф и минимизацией вызываемых ими разрушений, моделированием физических процессов в земном ядре.

В марте 2007 года Национальный научный фонд США опубликовал документ «Кибернетическое инфраструктурное видение открытий XXI века» (Cyberinfrastructure Vision for 21st Century Discovery), в котором с достаточной полнотой представлены основные области исследований, где найдут применение суперкомпьютеры. Этот пятилетний план предполагает создание научных и инженерных дисциплин, которые будут опираться на «петамасштабную» (petascale) среду HPC.

В Японии тем временем реализуется собственная программа «Кейсоку», направленная на создание петамасштабных систем (1-1000 PFLOPS), рассчитанная до 2011 года. О деталях этой программы пока известно мало, однако достоверно то, что создается национальный институт HPC, который будет координировать совместные усилия компаний NEC, Fujitsu и Hitachi с академическими исследованиями, ведущимися в Токийском университете, Токийском технологическом институте, университете Цукуба и других исследовательских центрах. Размер финансирования программы составляет около 1 млрд. долл.

Эволюция HPC

За несколько последних лет представление о том, что такое суперкомпьютеры, претерпело значительную метаморфозу. Из принадлежности избранных ядерных центров и лабораторий они превратились в привычный и довольно распространенный инструмент, используемый в самых разных исследованиях и высокотехнологичных разработках. Изменился и качественный состав, теперь в категорию суперкомпьютеров попадают не только по-настоящему уникальные вычислительные системы коллективного пользования, но и многочисленные высокопроизводительные кластеры, применяемые для ограниченного круга приложений. Подобную демократизацию следует признать достоинством, однако стоит учитывать, что вхождение в престижный список Top500 перестало быть интегральной оценкой и теперь говорит только о том, что тот или иной суперкомпьютер входит в число пятисот аналогичных приборов, имеющих наивысшие показатели на тесте Linpack, не более того. По этому показателю мэйнфрейм, на котором можно решать сложнейшие аналитические задачи, уступит совсем незамысловатому университетскому кластеру. Из-за специализации на решении узкого класса задач нынешнюю гонку за место в Top500 вполне можно сравнить с соревнованием в своеобразном виде спорта, где единственным критерием успеха является скорость выполнения вычислений с использованием ограниченной группы библиотек, поддерживающих распараллеливание. Таковы действующие правила Top500, и здесь, как в любом спорте высших достижений, преимущества имеют особым образом подготовленные профессионалы. Если изучить состав рейтинга Top500 в период после 2000 года, то обнаружится, что более 70% представляют кластеры типа Beowulf, работающие под управлением ОС Linux: сегодня это наиболее простой и, следовательно, самый массовый метод построения суперкомпьютеров.

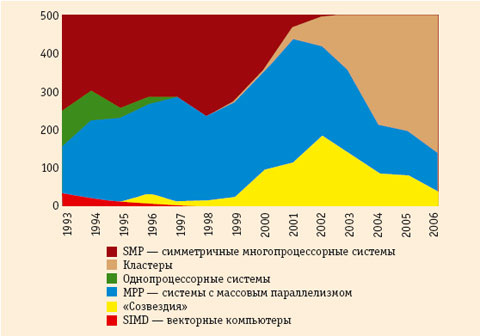

Из данных, приведенных на рис. 1, с очевидностью следует, что за 13 лет своего существования список Top500 радикально изменился по своему составу. Целый ряд архитектур, прежде всего мощные Unix-серверы с симметричной многопроцессорной архитектурой, покинули его. Их место заняли кластеры, заметно уменьшилась доля, приходящаяся на векторные компьютеры и так называемые «созвездия», то есть кластеры, собранные из SMP-серверов.

Происхождение HPC-кластеров

Не слишком долгую историю кластеров Beowulf можно разделить на два этапа. Первый, любительский, начался с середины 90-х годов, второй, профессиональный,— в 2002 году, когда стали производить серверы-лезвия.

В начале 90-х в нескольких американских университетах в порядке эксперимента приступили к сборке кластеров из готовых рабочих станций. Такие сооружения еще назвали cluster-NOW (Network Of Workstations), то есть «сеть из рабочих станций». На них смотрели как на курьез, но затем произошло неожиданное. Студенческое увлечение, получившее удачное название Beowulf Class Cluster Computers (Беовульф— маленький герой скандинавских саг, побеждавший своих противников, как Давид Голиафа), за полтора десятилетия совершенно неожиданно превратилось в доминирующее направление в High Performance Computing.

Комплектующими для первых кластеров Beowulf послужили готовые имевшиеся на рынке товары (Commodity Off The Shelf, COTS), а работы по их созданию спонсировали несколько американских организаций, которые поддерживали университетские исследования, связанные с космосом. Естественно, идея сборки отдельных станций в единую конструкцию не возникла на ровном месте; ее продуктивность была подготовлена наличием объективных предпосылок. К тому времени уже существовало необходимое для этого свободно распространяемое программное обеспечение, в том числе операционная система Linux, библиотеки MPI и PVM, поддерживающие параллельные вычисления, соответствующие языки программирования, прежде всего High Performance Fortran (HPF). И, конечно же, все это объединялось в рамках семиуровневой модели OSI. Оставалось немногое— соединить сетью несколько рабочих станций или персональных компьютеров и загрузить их этими программами.

Еще несколько слов о перечисленных предпосылках. О происхождении Linux хорошо известно; менее известно другое, например, то, что появлению языка HPF, как и Linux, мы тоже обязаны одному человеку, имя которого известно меньше, хотя он и получил серьезное признание в академической среде. Кен Кеннеди, профессор университета Райса, сумел адаптировать Fortran 90 для машин с архитектурами SIMD и MIMD, за эти и другие достижения в области параллельного программирования он был удостоен высших академических наград.

Совсем не личной заслугой является стандарт MPI (Message Passing Interface), распространяющийся на обмен сообщениями между программами. На протяжении нескольких лет этот стандарт разрабатывался участниками MPI Forum, впервые собравшимися в ноябре 1992 года. В настоящее время в MPI Forum входят 40 различных коммерческих и некоммерческих организаций. Версия MPI 1.0 была выпущена в 1994 году, а с 1995 года началась работа над MPI-2. Данный стандарт— не монополист в области кластерных решений, есть еще пакет PVM (Parallel Virtual Machine), который тоже позволяет рассматривать наборы компьютеров под управлением Unix или Windows как один большой параллельный компьютер, этот пакет распространяется свободно.

Протокол MPI выпущен в нескольких версиях. Общим для них является то, что они существуют автономно от используемого языка программирования. В зависимости от конкретной реализации MPI обеспечивает поддержку подмножества из языков программирования Cи, С++, Python, Java. Стандарт развивается, в этом году была принята версия MPI 2-1, но, несмотря на многолетнюю историю, необходимо его дальнейшее совершенствование по целому ряду направлений. Важнейшими из них являются производительность труда программистов, переносимость и поддержка. В основном работы по развитию MPI ведутся академическими сообществами. На средства, выделяемые DARPA, они развивают Open MPI, но есть коммерческие версии, например, HP MPI. А совсем недавно корпорация Microsoft включила поддержку MS-MPI в свой Windows Compute Cluster Server.

И, наконец, для завершения картины— о сетевой технологии, посредством которой отдельно взятые рабочие станции можно объединить на аппаратном уровне. На тот момент уже распространился стандарт Ethernet, соответствующее оборудование было общедоступно.

Итак, по совокупности всех перечисленных факторов открылась практическая возможность собирать кластеры в лабораторных условиях. На конференции Supercomputing 96 был продемонстрирован кластер с производительностью выше 1 GFLOPS стоимостью менее 100 тыс. долл. Он произвел настолько серьезное впечатление, что с него началась эпоха Beowulf в суперкомпьютинге.

HPC-кластеры, годы индустриализации

Как ни удивительно, но при переходе к следующему этапу в развитии кластеров программное обеспечение коренным образом не изменилось— все те же MPI и Linux плюс языки программирования, а вот оборудование претерпело радикальные изменения. Об эксплуатационных характеристиках полулюбительских сборок из ПК говорить не приходится, их время жизни было равно времени работы университетского коллектива. К индустриализации Beowulf подтолкнуло появление тонких серверов в форм-факторе 1U, а коренные изменения начались с появлением серверов-лезвий. В 1999 году был выпущен Cobalt RaQ, первый сервер в формате «коробки для пиццы», ставший настоящей сенсацией. Вскоре Sun Microsystems купила ее «автора», Cobalt Networks, за 2 млрд. долл., но, к величайшему сожалению, компания не сумела разыграть доставшуюся ей козырную карту. Тонкие серверы нашли свое место в телекоммуникационных системах, а в суперкомпьютерах им на смену очень быстро пришли серверы-лезвия, наиболее полно соответствующие идее объединения максимального количества независимых компьютеров в пределах одного конструктива— стандартной 42-дюймовой стойки. Первый сервер в новом форм-факторе выпустила компания RocketLogix, созданная Крисом Хиппом вместе с двумя его коллегами. Хипп одним из первых пришел к выводу о том, что гонка частот и связанное с ней растущее энергопотребление ведут в тупик. Для серверов требовалось альтернативное решение, и Хипп предложил форм-фактор, который позже стали именовать «лезвием».

В начале 2000 года компанией RocketLogix было выпущено шасси высотой 3U, в котором упаковывалось 24 сервера на процессорах Transmeta TM5600, оно имело в восемь раз более высокую плотность и в шесть раз меньшее энергопотребление, чем аналогичная сборка из серверов 1U. За следующий год RocketLogix, насчитывавшая всего 15 человек, совершила настоящую «революцию лезвий». После выпуска в свет управляющего программного инструментария RLX Control Tower, подкрепившего успех, компания RocketLogix, к тому времени переименованная в RLX Technologies, была признана самым успешным «стартапом» года. ИТ-отрасль подхватила идею. Уже в 2002 году была создана ассоциация Server Blade Trade Association, и тогда же на рынок со своими лезвиями вышли компании HP, Compaq, Dell и IBM, с небольшим опозданием к ним присоединилась Sun. А затем произошло неизбежное: HP купила RLX, и теперь именно эта компания лидирует в списке Top500 по количеству кластеров.

Параллельно с серверной базой суперкомпьютеров развивались и коммуникации. Если посмотреть на то, как менялись технологии коммуникаций, то нетрудно представить ход процесса «кластеризации» списка Top500, как происходило вытеснение из него универсальных серверов. Примерно с 2002 года в лидерах была компания Myricom с ее решением Myrinet. В 2003 году на него пришлось почти 40% установок, в 2005 году лидер сменился, и 50% сборщиков кластеров отдали предпочтение Gigabit Ethernet. В 2007 году уверенно в лидеры выдвигается Infiniband, по данным на первую половину текущего года на этот вид межсоединения пока приходится немногим более четверти от общего числа, но динамика явно свидетельствует в его пользу.

Green Destiny

Прообразом современных высокопроизводительных кластеров стал компьютер, созданный сотрудником Лос-Аламосской национальной лаборатории Ву Чун Фенгом. Этот компьютер не отличался особой производительностью— его достоинство в компактности, низком энергопотреблении, надежности. «Доктор Ву», который вел свою разработку совместно с Хиппом, сумел собрать прототип всех современных HPC-кластеров. Green Destiny (так называется знаменитый китайский меч с почти трехтысячелетней историей) иногда образно называли «ноутбуком среди суперкомпьютеров». Ву и Хипп приступили к своей работе в конце 2001 года, а первые результаты получили уже в начале 2002 года, то есть на первую достаточно серьезную попытку использования лезвий RLX ServerBlade для создания HPC-кластера ушло всего три месяца. Оказывается, имея готовые лезвия и другие необходимые комплектующие, не такой уж большой труд собрать из них высокопроизводительную систему.

В деталях кластер Green Destiny описан в статье The Bladed Beowulf: A Cost-Effective Alternative to Traditional Beowulfs, где Ву объясняет, что дешевизна Cluster-NOW относительна, затраты на закупку рабочих станций и коммуникационного оборудования действительно на порядок ниже в сравнении с классическими компьютерами. На самом деле следует учитывать общую стоимость владения, которая включает в себя не только прямые расходы на администрирование и поддержку, но и косвенные затраты, вызванные ненадежностью оборудования. На примере 128-узлового кластера Cluster-NOW доктор Ву показывает, что его эксплуатация требует постоянного участия технического персонала, а на профилактику уходит 25% общего времени его работы. Поэтому говорить о подобных конструкциях как об инструменте для реальных научных исследований нельзя. Но свою службу они, безусловно, сослужили, они позволили мобилизовать сообщество специалистов вокруг стандартного набора программных технологий. В качестве выхода из положения и был предложен Bladed Beowulf, который спроектировали в компании RLX, а собрали и сконфигурировали в Лос-Аламосской национальной лаборатории. Каждое из лезвий RLX ServerBlade было укомплектовано процессором Transmeta TM5600/633 МГц, оперативной памятью на 256 Мбайт, 10-гигабайтным диском и тремя контроллерами Fast Ethernet. В одно шасси RLX System 324 высотой 3U удалось упаковать 24 таких лезвия, эта конструкция могла работать самостоятельно или в составе более крупного кластера, а потому называлась MetaBlade. Десять собранных в одну стойку шасси, собственно, и называли Green Destiny.

Созданный высокопроизводительный компьютер занимал минимум места, не требовал специальных условий эксплуатации и при этом был весьма надежным. С момента своего запуска и до первой неисправности он проработал непрерывно девять месяцев. На нем с успехом решаются задачи, связанные с астрофизикой, и гравитационные задачи. Green Destiny не поражал своими показателями, однако он был воспринят как сенсация; на его торжественное открытие приехали многие ученые и специалисты, среди них были Линус Торвальдс и Гордон Белл.

Таким образом, в 2002 году развитие суперкомпьютинга разделилось на два направления— на элитное классическое, в основном представленное системами IBM и Cray, его можно назвать «суперкомпьютингом вглубь», и демократическое кластерное, для него больше подходит наименование «суперкомпьютинг вширь». Это два альтернативных направления, но у большинства специалистов создалась иллюзия конца «суперкомпьютинга вглубь» и того, что будущее принадлежит исключительно «суперкомпьютингу вширь».

Кластеры — это наше все?

Одновременно со стартом Green Destiny в журнале Communications of the ACM в феврале 2002 года вышла статья «Next in High-Performance Computing?», не столько предполагавшая, сколько постулировавшая будущее. Для такой постановки проблемы нужен достаточный авторитет, а его авторам, двум ведущим экспертам корпорации Microsoft, было не занимать. Один из них, Джим Грей, лауреат Тьюринговской премии, имел опыт разработки компьютерных систем в DEC, IBM и Tandem. Другой, Гордон Белл, вошел в компьютерную историю, прежде всего, как разработчик легендарных мини-ЭВМ VAX. Они задали себе несколько вопросов о будущем высокопроизводительных вычислений и сами же попытались дать на них ответ. В своей статье они буквально с первых слов утверждали, что будущее исключительно за кластерами, причем не теми кластерами, которые строятся в стиле, выработанном Сеймуром Креем, где узлами служат векторные процессоры, а исключительно кластерами типа Beowulf. Они писали: «Экономика и социология Beowulf способны уничтожить все остальные архитектурные подходы, и, скорее всего, аналогичным образом они повлияют на традиционные вычислительные центры». Под экономикой авторы статьи подразумевали кардинальное снижение стоимости, а под социологией— формирование открытых сообществ, поддерживающих развитие и использование кластеров*.

По существу статья Белла и Грея представляет собой панегирик Beowulf. Приведя аргументы в пользу таких кластеров, они напомнили 1983 год и историю провалившейся стратегической компьютерной инициативы DARPA Strategic Computing Initiative (SCI). Тогда усилия свыше 40 компаний, сосредоточенные на двух десятках проектов создания суперкомпьютеров, не смогли обеспечить требуемые масштабируемость и параллелизм, и в результате к 1992 году программа была свернута. Желая заставить машину «мыслить», в DARPA затратили около миллиарда долларов на работы в области суперкомпьютинга и искусственного интеллекта, правда, с большим акцентом на последний. Нельзя сказать, что все средства были потрачены впустую, но сосредоточенность на искусственном интеллекте сыграла злую шутку, она отняла деньги у тех, кто занимался практическими вещами, и не принесла своих собственных результатов. Проект SCI стал крупнейшей неудачей в истории DARPA. Провал инициативы Белл и Грей отчасти объяснили отказом от интеллектуальной составляющей, смещением интересов из науки в инженерию, резким поворотом от векторных машин к микропроцессорным кластерам и проиллюстрировали это обстоятельство изменениями в списке Top500 в период с 1993-го по 2001 год.

А далее, всячески восхваляя Beowulf, Белл и Грей признали, что его успех был обеспечен наличием в открытом доступе необходимого программного обеспечения, параллельных технологий программирования и приложений, востребованных научным сообществом.

Создание в перспективе крупных вычислительных центров авторы не предполагали, считая, что должна сложиться многоуровневая инфраструктура из кластеров разной мощности, уровня лаборатории или подразделения, выше их — корпоративные кластеры и т.д. Сохраниться могут лишь такие «экзотические» центры, как IBM BlueGene или японский Earth Observation Research Center Simulator, а также крупные центры обработки данных. Сегодня это пророчество, особенно его вторая часть, представляется сомнительным.

Гимн во славу кластеров в статье Белла и Грея прерывается только единожды, когда авторы признают (называя это темной стороной Beowulf), что кластеры плохо работают с большой общей памятью. Поэтому Белл и Грей соглашаются с тем, что классическая архитектура не совсем умерла, что миру не грозит кластерная монокультура, что стоит вкладывать средства и в развитие новых программных парадигм и систем управления большими базами данных.

Не кластерами едиными

Через год после выхода статьи Белла и Грея с весьма осторожной ответной публикацией «High Performance Computing Clusters, Constellations, MPPs, and Future Directions» выступили четверо крупнейших специалистов по высокопроизводительным вычислениям— Джек Донгарра, Томас Стерлинг, Хорст Симон и Эрик Штохмайер. Их отношение к проблеме вообще и к кластерам особенно интересно тем, что именно они формируют Top500. Это действительно очень известные в мире HPC имена, но и они очень осторожно, хотя вполне аргументированно подвергли критике двух великих за безоговорочное воспевание идеи всеобщей кластеризации. По причине взвешенного отношения к простому решению сложной проблемы эту статью стоит прочесть тем, кто сегодня, если так можно сказать, вульгаризирует проблему суперкомпьютинга, сводя все к количеству терафлопов, достигаемых на кластерах.

Для определения предмета Донгарра и его коллеги предлагают несколько способов классификации HPC-систем. По одной, они делят их на системы с массовым параллелизмом (Massive Parallel Processing, MPP), кластеры и «созвездия» (constellation), то есть кластеры, состоящие из серверов с симметричной многопроцессорной архитектурой (Symmetric MultiProcessing, SMP). Другая классификация основывается на четырех характеристиках— кластеризация, распространение пространства имен, параллелизм и латентность управления. Эти классификации не стали массовыми, но свою роль сыграли, с их помощью удалось показать, что «не кластерами едиными».

Донгарра и его коллеги считают, что кластеры— очень правильная и перспективная архитектура, что им предстоит долгая и успешная жизнь, поскольку существует целый ряд задач, для которых экономические преимущества, даваемые кластерами, оказываются важнее, чем доставляемые ими неудобства. Более того, они уверены в том, что у кластеров все впереди. По их мнению, в ближайшие годы, на период с 2009-го по 2012 год выпадет пик увлечения кластерами и с их помощью будет преодолен петафлопный рубеж. Но в целом процесс эволюции высокопроизводительных вычислительных систем никак не может быть упрощен и сведен к одной-единственной архитектуре. В этом их расхождение во взглядах с Беллом и Греем, а также некоторыми наши соотечественниками, которые исключительно на кластерах планируют создать всю отечественную суперкомпьютерную инфраструктуру.

Донгарра и его соавторы совершенно справедливо утверждают, что кластеры являются тактическим средством преодоления того, что называют «стеной памяти» (memory wall), или «бутылочным горлом фон-Неймана» (von Neumann bottleneck). Действительно, для принятой сегодня архитектуры компьютеров характерна фундаментальная слабость — присущее ей ограничение на обмен между процессором и памятью. Если есть N процессоров и каждый их них работает на собственную память, то ширина горла в N раз больше, скорость выше, но задержки на межпроцессорном обмене возрастают, следовательно, класс решаемых задач ограничен.

Идея кластеризации очевидна: если есть какая-то система, то увеличить ее мощность можно за счет ее удвоения, утроения и т.д. Но с системной точки зрения есть предел: можно тянуть состав двумя локомотивами, но не десятью, невозможно построить большой самолет, снабдив его потребным числом автомобильных двигателей и т.д. Для того чтобы построить очень большой кластер, необходимо, чтобы каждый модуль «знал все» обо всех остальных модулях, то есть они должны обладать общим пространством имен всех компонентов. Существует естественный предел кластеризации, преодоление которого требует качественно новых решений. Иначе говоря, для каждой системы есть собственный предел суммирования модулей, где-то максимальное число может быть 2, где-то 8, а где-то и 1000, но когда число модулей превышает это ограничение, возникает необходимость в совершенно иной многоуровневой инфраструктурной организации.

От высокопроизводительного к высокопродуктивному компьютингу

В 2003 году, успев к тому времени оправиться от потрясений, вызванных провалом SCI, и видя ограниченность простого кластерного подхода, в DARPA выдвинули новую стратегическую инициативу— High Productivity Computing Systems (HPCS). На этот раз конечной целью является не просто скорость вычислений, а комплексная производительность, создание экономически обоснованных систем для обеспечения национальной безопасности США, развития промышленности и науки. Основным компонентом будущей системы является ее пользователь, а под «продуктивностью» понимается не только время решения задачи, но время разработки программного обеспечения, затраты на аппаратное обеспечение, и, что немаловажно, косвенные расходы на администрирование и эксплуатацию.

После первого этапа в числе участников остались три компании— IBM, Cray и Sun Microsytems. На третий этап вышли IBM и Cray, но это не значит, что Sun выпала из лидеров в гонке, у нее есть шанс первой перешагнуть петабайтный барьер. На суперкомпьютерной конференции в Дрездене в июне 2007 года был представлен проект Constellation, построенный на сверхтонких лезвиях и коммутаторе компании Mellanox c 3456 портами. В ноябре началось развертывание системы в Техасском университете. Этот суперкомпьютер наряду с разработками IBM и Cray открывает совершенно новый этап в развитии HPC, уроки которого непременно следует принимать во внимание всем тем, кто печется об обеспечении информационной безопасности нашей страны.

* Именно на социологию Beowulf следовало бы обратить внимание тех отечественных администраторов от науки, которые пытаются создать собственную национальную программу кластеризации, противоречащую самой идее, предполагающей, что аппаратные кластеры работают со свободно распространяемым и открытым программным обеспечением, а представители сообществ находятся в постоянном контакте между собой. Кластеры для науки в сочетании с их социологией и экономикой дают кумулятивный эффект, благодаря которому лаборатории и отдельные пользователи могут предоставлять взаимные услуги, и это сотрудничество дает импульс к дальнейшему развитию.