Для возникновения гармоничных экосистем необходимы формирующие их внешние ограничения. Но поскольку на ранних периодах существования систем таких ограничений может и не быть, вероятно появление монстров, не выдерживающих, впрочем, испытания временем. Таковыми были самолеты с дюжиной поршневых моторов, гоночные автомобили с объемом цилиндров 20 литров или танки, снабженные немыслимым количеством башен, которые своим современникам представлялись вполне разумными решениями.

Для возникновения гармоничных экосистем необходимы формирующие их внешние ограничения. Но поскольку на ранних периодах существования систем таких ограничений может и не быть, вероятно появление монстров, не выдерживающих, впрочем, испытания временем. Таковыми были самолеты с дюжиной поршневых моторов, гоночные автомобили с объемом цилиндров 20 литров или танки, снабженные немыслимым количеством башен, которые своим современникам представлялись вполне разумными решениями.

Компьютерные системы не исключение. Время монстров в ИТ оказалось возможным потому, что постоянный прогресс полупроводниковых технологий десятилетиями избавлял от ограничений, но всему рано или поздно приходит конец. Недавно обнаружившаяся проблема сложности поставила предел экстенсивному росту производительности процессоров, побудив к переходу на многоядерные процессоры, а вместе с ним— к разработке новых подходов к программированию.

Еще одним «благотворным» ограничителем оказалась энергетическая проблема. О ней чаще всего вспоминают в связи с необходимостью строительства крупных центров обработки данных (ЦОД), которым не хватает выделяемых им лимитов электроэнергии. Энергетическая проблема оказалась наиболее актуальной для развитых стран; в России ее почувствовали разве что только в крупных городах, да и то не во всех. Здесь она еще не так остра, как на Западе, но вспомним 1993 год, когда принимался стандарт на автомобильный выхлоп Euro 1. Мог ли кто-нибудь из наших соотечественников в те годы отнести экологические требования к своему автомобилю? Точно так же дело обстоит и со схожими проблемами в ИТ, они с неизбежностью встанут и в нашей стране причем скорее всего, приобретут актуальность уже через несколько лет.

И еще об одном заблуждении, связанном с «озеленением» компьютеров. Утверждают, что процессоры «съедают» не слишком много энергии, а потому, даже в разы сократив их «аппетиты», все равно на общем фоне не добиться значительной экономии. Ошибка этого рассуждения в том, что процессор— лишь вершина пирамиды, и совсем небольшое сокращение потребления энергии на вершине приводит к существенному сокращению в основании. К энергетическим проблемам информационных технологий необходим системный подход.

Проблематика Green IT естественным образом делится на три составляющих:

-

энергетические проблемы ЦОД и персональных компьютерных систем;

-

организация «зеленого предприятия», включая оптимизацию цепочек поставок, совершенствование производственного цикла, использование телеконференций и мобильных устройств с тем, чтобы снизить потребность в перемещении сотрудников;

-

минимизация физического загрязнения окружающей среды.

Ошибки новых экономистов

На какой-то момент прогресс в информационных технологиях поколебал сложившиеся за столетия представления о сути производства и потребления. Под влиянием быстро распространившихся ПК в начале 90-х годов приобрели необычайную популярность такие неведомые прежде термины, как «новая экономика», «экономика знаний» и им подобные, относящиеся к нематериальной— как в тот момент представлялось— сфере. Казалось, наступила новая жизнь, где собственно производство вторично, а первичен электронный бизнес, благодаря которому человечество вступило в новую информационную эпоху. Но эйфория увлечения нематериальным продолжалась недолго. Подвел кризис 2000 года, разоривший многих из тех, кто сделал ставку на «е-бизнес». Конечно, подлинные причины кризиса глубже, чем биржевые спекуляции и тому подобные факторы; игра, конечно же, была лишь стимулом, но «бум доткомов» обернулся глубоким провалом для всей ИТ-отрасли из-за ошибочности самих идей дематериализации в экономике. Вслед за этим обнаружились самые что ни на есть материальные— и в том числе энергетические— проблемы.

Надо сказать, перспективно мыслящие люди понимали иллюзорность новой экономики задолго до 2000 года. Об этом писали и говорили многие. Очень показательной стала статья Питера Хубера, опубликованная в мае 1999 года в журнале Forbes [1]. В ней автор очень обоснованно поставил многое с головы на ноги; его основная мысль была выражена в названии «Копайте больше угля, идут ПК». С этой публикации и началось массовое зеленое движение в компьютерной отрасли (справедливости ради отметим, что первые экологические шаги были сделаны еще в 1992 году, когда была принята программа Energy Star).

Наблюдения показали, что на протяжении десятилетий суммарная мощность, потребляемая компьютерами, увеличивалась почти в полном согласии с логикой закона Мура, с поправкой на то, что из-за снижения удельного потребления и под влиянием рыночных факторов период удвоения в данном случае больше, он составляет четыре-пять лет. Как следствие, в развитых странах внедрение ИТ привело к росту отраслей, связанных с производством и распределением электрической энергии. Отмеченное повышение спроса оказалось полной неожиданностью даже для специалистов-энергетиков. За десять лет до того, в середине 80-х годов экспертам казалось, что появление более экономичных технологий компенсирует потребности возникающих новых производств; они утверждали, что дальнейшего роста потребления энергии не будет, что начинается полоса энергетической стабильности. Казалось, человечество вот-вот достигнет предела потребления энергии, но появились персональные компьютеры и Internet, и положение стало меняться.

Нетрудно подсчитать, что средний ПК требует выработки в год примерно 1000 киловатт-часов энергии; если умножить число находящихся в пользовании персональных компьютеров на 1000, то получается вполне серьезная цифра. Но этого мало: каждый пользователь, входя в Сеть, вовлекает в работу большой объем оборудования, что тоже приводит к дополнительному увеличению энергозатрат, ведь Сеть столь же материальна, как компьютер. Подсчитано, что даже простейшее действие, такое, как заказ книги в Internet-магазине, требует сжигания 50-100 граммов угля, так что о нематериальности новой экономики говорить не приходится. Но наибольший прирост потребления связан с предоставлением сетевых сервисов; не случайно сегодня самым крупным энергопотребляющим объектом в США оказался ЦОД, принадлежащий Google. Грубая оценка нынешнего положения дел сводится к тому, что на один евро, вложенный в компьютеры, приходится вкладывать тот же самый евро в энергетику.

Еще одна ошибка проповедников новой экономики заключается в игнорировании того факта, что само производство компьютеров тоже является чрезвычайно материало- и энергоемким. В весовых показателях выход полезных продуктов в полупроводниковой отрасли сравним только с ядерным производством, а удельные затраты энергии и воды на порядки выше, чем в машиностроении. Нет ничего удивительного в том, что многие компании отрасли, особенно полупроводниковые, не имеют собственного производства, используя для этой цели ресурсы третьих стран.

Дополнительным фактором загрязнения окружающей среды служит неоправданно короткий срок морального старения оборудования, что приводит к интенсификации потребления ресурсов и созданию огромного количества отходов. Сейчас уже можно говорить о новом типе загрязнения— e-waste (Waste Electrical and Electronic Equipment, WEEE), опасном высоким содержанием токсинов и канцерогенов в продуктах загрязнения. В частности, очень опасны ЭЛТ-мониторы. В Европе принят регламентирующий акт WEEE 2002/96/EC; аналогичные нормативы существуют в США; есть несколько международных организаций, призванных контролировать утилизацию вышедших из употребления компьютеров.

Среди «зеленых» начинаний есть и весьма экзотические, например, «зеленое программное обеспечение», то есть программы, способствующие оптимальному использованию сберегающих режимов работы процессоров и увеличению жизненного цикла оборудования. Однако неоправданной можно считать и слишком частую смену поколений операционных систем. Некоторые «зеленые авторы» даже назвали появление Windows Vista экологической катастрофой. Новая операционная система побуждает менять физически работоспособное оборудование, которое еще могло бы годами работать под управлением какой-нибудь Pussy Linux. Конечно, по удобству эту размещаемую в памяти операционную систему нельзя сравнивать с Vista— но ведь работает, а экологичность мышления предполагает самоограничение. Рано или поздно происходит перестройка сознания; к примеру, в Калифорнии иметь Toyota Pirus престижнее, чем Hammer— на парковке высокотехнологичной компании появиться на такой машине попросту неприлично. Самоограничение должно распространяться на пользование принтерами и ксероксами, по возможности следует переходить на безбумажные технологии.

Энергетические проблемы ЦОД

Вычислительные центры с их непременными атрибутами— белые халаты, стеклянные стены, хлюпающие под ногами фальшполы— были порождением эпохи мэйнфреймов. Но вся эта благодать ушла в прошлое с появлением мини-ЭВМ и особенно с массовым распространением ПК. В новых условиях компьютеры можно было встретить уже где угодно. Но вскоре вместе с локальными сетями получила распространение клиент-серверная архитектура, и очень быстро сформировался новый класс компьютеров— серверы, их мощность стала расти, и появились основания говорить о ренессансе ВЦ.А далее с началом массового распространения Internet-сервисов представления о масштабах ВЦ изменились еще больше, приведя к возникновению того, что теперь мы называем центрами обработки данных (data center). Некоторые из них насчитывают сегодня десятки тысяч серверов.

Как результат, в развитых странах за последнее десятилетие радикально изменилась структура серверного парка. В 1998 году подавляющее большинство серверов выпускалось в корпусном исполнении, а на долю едва появившихся стоечных серверов приходилось всего несколько процентов. Сегодня стоечных серверов стало почти 50%, на долю серверов-лезвий, еще не существовавших тогда, приходится 20%, и только оставшиеся 30% все же удерживают за собой корпусные конструкции. Предполагается, что подобная динамика сохранится, и к 2010 году, по оценкам IDC, доля лезвий возрастет до 30% за счет корпусных, а доля стоечных серверов сохранится (рис. 1).

С появлением тонких серверов (1-2U) и лезвий существенным образом увеличивается среднее наполнение стоек. Десять лет назад в стойку монтировали всего 7 серверов, пять лет тому назад— 10 серверов, сегодня— 14, а к 2010 году среднее число серверов в стойке увеличится до 20.

Но и нынешние 20 серверов на стойку— далеко не предел, во многих случаях плотность размещения серверов может быть существенно выше средней, в таком случае при сохранении нынешних процессорных технологий тепловая мощность одной стойки может приблизиться к 20-25 киловаттам. За тот же период значительно изменились цены: стремительно дорожали энергоносители и столь же быстро дешевели серверы. В 2007 году в США затраты на приобретение новых серверов и на энергию, включая затраты на кондиционирование, сравнялись, и прогнозируемое изменение пропорции не в пользу серверов (рис. 2). Чтобы развивать ИТ-инфраструктуру, необходимо менять это соотношение в пользу серверов. Выход из создавшегося положения заключается не только в переходе на новые процессоры и консолидации серверов, о чем много и упорно говорится, но и в оптимизации систем кондиционирования и энергоснабжения.

Но пока ситуация еще не катастрофична. В 2007 году ЦОДы потребляли только 1,5% от вырабатываемой в США электроэнергии, к 2011 году эта величина возрастет до 2,5%. Если темпы роста потребления энергии со стороны ИТ сохранятся (напомним, сейчас потребление удваивается каждые пять лет), то к чему это приведет? Чтобы избежать кризиса, необходимо совершенствовать не только серверы, но и обеспечивающие технологии. Из потребляемой ЦОД энергии примерно 37% уходит на кондиционирование. В том, что дело обстоит именно так, нет ничего удивительного: к отводу тепла в ИТ всегда относились как к чему-то второстепенному, в большинстве случаев обходясь без серьезных тепловых расчетов. Со времени появления Unix-серверов и до момента, когда была осознана необходимость создания крупных ЦОД, инженерная культура и опыт, накопленные во времена мэйнфреймов, оставались невостребованными. Однако ситуация быстро меняется, и обеспечение климатических условий ЦОД из «любительского» занятия превращается во вполне серьезное, профессиональное дело. Основные рекомендации, которые можно обнаружить в авторитетных источниках [2], сводятся к выбору соответствующих конструкций фальш-потолков и фальш-полов, оптимизации воздушных потоков, применению специальных устройств— экономайзеров, позволяющих использовать внешний холод, приближению охлаждающих систем к источникам тепла.

Виртуализация

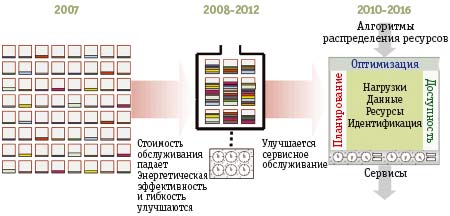

Аналитики Gartner делят грядущую эволюцию на три фазы (рис. 3). Сегодняшнее подавляющее большинство компьютеров явно недогружено. Через пять лет компьютеров станет существенно меньше, но они будут нагружены существенно эффективнее, а еще позже сформируется «компьютерное облако», универсальная среда, обеспечивающая все необходимые сервисы. Тем, кто отдал много лет компьютерам, опыт подсказывает, что такое возможно.

Светлое будущее компьютерных систем выдержано в зеленых тонах. Предстоит решить целый комплекс проблем, где собственно компьютерная часть не является доминирующей. Генерация и передача энергии имеют КПД примерно 0,7. Попадающая на вход ЦОД энергия делится примерно поровну между «основными» потребителями и системами кондиционирования, причем больше половины из того, что расходуют потребители, съедают системы бесперебойного питания и другое энергетическое оборудование. Стоящие в конце «пищевой цепочки» серверы потребляют примерно 6% от исходного энергетического потенциала топлива, а на процессоры приходится около одного процента. В общем, как говорится, паровозы отдыхают.

Питание и кондиционирование

На уменьшение тепловых выбросов и повышение эффективности кондиционирования влияет конструкция стоек: существующие стойки далеко не оптимальны с точки зрения отвода тепла. Они изготавливаются по стандарту на 19-дюймовые стойки (EIA-310-D— Cabinets, Racks, Panels, and Associated Equipment), который был принят альянсом Electronic Industries Alliance (EIA) в 1992 году, когда об экологических параметрах конструкции еще не задумывались; к тому же он предназначался для телекоммуникационного оборудования, отличающегося меньшим выделением тепла. Использовать стойки для размещения серверов стали позже, а в начале 90-х никому бы и в голову не пришло, что стойка может потреблять 25 киловатт. Необходимость в дальнейшем усовершенствовании конструктивов для упаковки серверов непосредственным образом связана с созданием мобильных ЦОД, ограниченность объема которых ужесточает требования. В конце 2007 года Google опубликовала принадлежащий ей патент на мобильный ЦОД, чем поставила в затруднительное положение других. Компания Rackable Systems предложила свой ЦОД-контейнер ICE Cube. В его основе модульная конструкция Concentro, отсюда и название интегрированной среды Integrated Concentro Environment (ICE), позволяющей вместить в стандартный 40-футовый контейнер до 11200 ядер процессоров архитектуры x86-64 или систему хранения емкостью до 7 Тбайт. Серверы и системы хранения, выпускаемые Rackable Systems, не отличаются особым функциональным своеобразием; конек компании— совершенное конструктивное исполнение. Контейнер комплектуется серверами и системами хранения семейства Eco-Logical в оригинальных стойках половинной глубины. Такие стойки можно ставить «спиной» друг к другу, «собирая» тепло в проеме между ними.

Еще один серьезный источник экономии скрывается в рационализации системы энергоснабжения. Схема, принятая в большинстве ЦОД, выглядит так, как показано на рис. 4a. От высоковольтной сети энергия поступает на трансформаторы, имеющие КПД до 98%. Существенно меньший коэффициент имеют мощные источники бесперебойного питания, в пределах от 74% до 94%. Далее в цепочке следуют распределительные устройства и самые неэффективные с энергетической точки зрения (56-71%) собственные блоки питания серверов.

Если отказаться от промежуточного преобразования в переменный ток, то цепочка значительно сокращается за счет исключения ИБП, распределительных щитов и блоков питания с заменой их преобразователем напряжения постоянного тока (рис. 4б).

Существует несколько подходов к построению участка тракта от силового трансформатора до потребителя (рис. 5).

Появление схемы питания серверов постоянным током вызвало вполне предсказуемую реакцию со стороны производителей ИБП. Понять их можно, этот сегмент рынка очень успешно развивается, а его объем уже превысил 7 млрд долл. Распространение альтернативной схемы может разрушить сложившуюся стабильность, поэтому развернулась серьезная полемика. Скорее всего, она не достигнет масштабов «войны токов», которую вели в конце XIX века приверженец постоянного тока Томас Эдисон и адепты переменного тока Никола Тесла и Джордж Вестингауз, но, тем не менее, в этой игре ставки велики. В материалах, публикуемых нынешними отраслевыми лидерами, например APC, показывается, что не всегда постоянный ток эффективнее переменного; последний имеет преимущество на переменных нагрузках, ну и, конечно же, на стороне переменного тока колоссальный опыт инженеров-электриков. Другие компании, та же Rackable Systems доказывают обратное.

Чтобы получить объективное представление о достоинствах и недостатках обеих схем, в 2007 году были организованы независимые исследования. Общественная организация Green Grid Technical Forum (www.thegreengrid.org ) выполнила количественное сравнение всех известных схем питания— Qualitative Analysis of Power Distribution Configurations for Data Centers. Еще более серьезное аналитическое исследование, DC Power for Improved Data Center Efficiency, было выполнено в Ливерморской национальной лаборатории (hightech.lbl.gov/documents/DATA_CENTERS/DCDemoFinalReportJan17-07.pdf).

В обоих трудах авторы приходят к общему выводу о том, что пока нельзя однозначно говорить о практических преимуществах того или иного способа питания. Питание постоянным током примерно на 20% сокращает потери, но создание 48-вольтовых сетей потребует больших затрат меди, а напряжение свыше 500 вольт вызывает сложности с изоляцией. Наиболее эффективным может оказаться постоянный ток с напряжением 380-500 вольт, однако и здесь не все просто, пока на рынке нет полного набора соответствующего оборудования. Существенно и то обстоятельство, что у инженеров нет ни опыта, ни даже школы работы с постоянным током.

Персональные компьютеры и общие экологические проблемы

На информационно-коммуникационные технологии приходится всего 2% от общего глобального выброса CO2. Если же исходить из данных о распределении потребления энергии между различными категориями оборудования, то 31% из них приходится на коммуникации, 23%— на серверы, 6%— на принтеры и 39% (!)— на персональные компьютеры и мониторы (рис. 6).

Между тем, основные экологические проблемы создаются не ЦОДами, а персональными компьютерами, и проблемы эти гораздо серьезнее, чем нам кажется. Во-первых, используемые в ПК маломощные источники питания по самой своей природе малоэффективны. Обычно их КПД не превышает 75%. Только в 2007 году была предложена сертификация по Energy Star 4.0, повышающая этот показатель до 80%. К тому же принятое сейчас программное выключение ПК оставляет компьютер в сети, и он продолжает потреблять свои 2-3 ватта; если умножить на сотни миллионов, то получится изрядная цифра. Если же учесть эксплуатационные проблемы, такие как неудобство и высокая стоимость, то почему же мы до сих пор пользуемся ПК, почему давным-давно не отдали предпочтение тонким клиентам? Ответ очевиден. Феномен ПК поддерживается инфраструктурными проблемами— создавать каналы связи, маршрутизаторы, адаптеры существенно дольше и дороже, чем ПК.

Все наиболее известные из технологий тонких клиентов— в том числе Virtual Network Computing (VNC), Remote Desktop Protocol (RDP), NX, Independent Computing Architecture (ICA), X Window System (X11), Adaptive Internet Protocol (AIP)— едины в стремлении минимизировать сетевой трафик. Масштабное исследование требований тонких клиентов к пропускной способности каналов выполнили Альберт Лэй и Джейсон Ньен из Колумбийского университета (On the Performance of Wide-Area Thin-Client Computing, www.columbia.edu/~amlai/publications/tocs2006_i2thin.pdf ). До тех пор, пока тонкие клиенты будут ограничены полосой пропускания, они будут уступать по удобству ПК, а их сфера применения будет ограничена доступом к отдельным корпоративным приложениям.

Так или иначе, помимо «классических» тонких клиентов уже существует целый ряд решений, которые демонстрируют особую экологичность.

Нулевые клиенты

В 2007 году две крошечные компании, Pano Logic и Teradici попытались пренебречь ограничениями на скорость передачи данных и предложили решения, получившие названия PC-over-IP, PCI-over-IP и USB-over-IP.

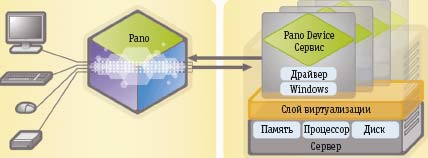

Компания Pano Logic создана Ником Голтом, широко известным в качестве сооснователя компании XenSource, недавно проданной Citrix. На данный момент в Pano всего 20 сотрудников. Устройство, которое Голт выводит на рынок, представляет собой небольшую коробку размером 10 на 10 сантиметров, имеющую три порта USB, стандартные разъемы для подключения мыши, клавиатуры и дисплея VGA. Посредством IP оно подключается к сети и получает доступ к виртуальной машине (рис. 7). Пока поддерживаются только продукты VMware (VMware ESX или VMware Server), но в дальнейшем предполагается возможность использования виртуальных машин от Microsoft, XenSource и Citrix. Устройство Pano Logic можно рассматривать в качестве конкурента классическим тонким клиентам, однако оно отличается тем, что так называемый нулевой клиент не имеет встроенной операционной системы, оно может быть заменено другим без всяких сложностей. Голт не рассматривает свое детище как попытку замены тонких клиентов и терминальных сервисов. Pano отличает предельно низкое потребление энергии— всего 5 ватт, на 97% меньше обычного ПК.

Используя протоколы PCI-over-IP и USB-over-IP, решение Pano полностью заменяет ПК и обеспечивает работу в среде Windows XP или Windows Vista, размещенной на виртуальной машине, находящейся в ЦОД. Программное обеспечение Pano, работающее на управляющем сервере контролирует работу устройств, «оркеструя» виртуализационную инфраструктуру.

Для того чтобы подключить устройство, на серверной стороне создаются предопределенные образы виртуальных машин. К примеру, можно создать типовой шаблон, работающий под управлением Windows XP со стандартной аппаратной конфигурацией (размер оперативной памяти, число процессоров и т.д.). Затем на него «устанавливается» базовый набор приложений. Вместе с устройствами компания Pano Logic поставляет набор таких шаблонов; пользователь может расширять его собственными шаблонами. Пользовательские профили отделены от виртуальных машин, что открывает возможность для модернизации. В Pano разработано специализированное программное обеспечение, оно взаимодействует с программными средствами виртуализации и поддерживает необходимое число виртуальных машин.

С помощью Administrator Pano пользовательские образы машин отображаются на виртуальные машины. Средствами Microsoft Active Directory администратор назначает пользователей, устанавливает соответствие между ними и группами виртуальных машин. Когда пользователь входит в систему, его связывают с соответствующей виртуальной машиной, затем он получает полный доступ к выделенному образцу операционной системы и, как результат, полный доступ к выделенным ему ресурсам. Если сервер выходит из строя, пользовательская сессия автоматически стартует на резервном сервере.

С точки зрения безопасности преимущество решения Pano заключается в том, что полностью исключена возможность заражения вирусами и клавиатурными шпионами.

Оценивая перспективность устройства Pano Logic, все же следует принять во внимание, что при работе с разрешением 1024х768 должна быть обеспечена скорость обмена 10 Мбит/с, а при разрешении 1920х1200— до 58 Мбит/с.

В составе канадской фирмы Teradici собраны сотрудники-ветераны со значительным опытом работы в Intel, Wyse, Transmeta, NEC, Epson и других не менее известных компаниях. В качестве консультанта был привлечен сам Крис Хипп, признанный «отец лезвий» и основатель RLX, первой лезвийной компании. Именно таким командам сегодня удаются прорывные решения: специалисты Teradici оформили уже несколько десятков патентов. По итогам трех лет исследований компании удалось предложить собственную, чрезвычайно эффективную технологию PC-over-IP, которая поддерживает обмен данными между тонкими клиентами, а точнее, между устройствами, составляющими оборудование рабочего места пользователя, и системным блоком, физически вынесенным в корпоративный центр обработки данных. В отличие от Virtual Desktop Infrastructure (VDI)— ставшего классическим решения, основанного на стандартных технологиях виртуализации, здесь нет никакой консолидации серверов. Все построено в соответствии с принципом «один к одному»: каждому системному блоку соответствует одно лезвие в стойке, где собраны все корпоративные ПК.

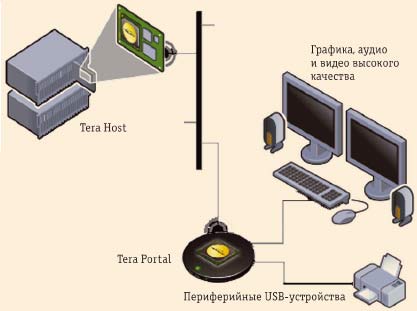

Основу решения PC-over-IP (рис. 8) составляют адаптер Tera Host на процессоре Tera1200 Host Processor, устанавливаемый в центре обработки данных, и устройство для подключения рабочих мест Tera Portal на процессоре Tera1100 Portal Processor; между собой они могут быть связаны проводной или беспроводной сетью. В этой части ничего, казалось бы, оригинального нет, в том или ином виде подобные подключения организуют и другие компании, но решение Teradici отличается собственным механизмом Tera Image Engine, оптимизирующим обмен данными по сети. Именно он снимает ограничения, связанные с использованием терминалов с высоким разрешением и подключаемых по USB устройств с большой емкостью и высокой скоростью обмена данными. Наличие этого механизма освобождает тонкого клиента от присущих ему сложностей работы с графикой, звуком и видео. Компрессию трафика обеспечивают две ASIC-микросхемы (одна в центре, а вторая на периферии); в них зашиты оригинальные алгоритмы, разработанные Teradici.

Рабочее место может комплектоваться любой USB-периферией. Для того, кто привык к работе на ПК, решение PC-over-IP не меняет ничего, за исключением отсутствия шумящего системного блока под столом. Операционные же преимущества очевидны— это экономия энергии, упрощение обслуживания и все остальные аргументы, приводимые обычно в пользу тонких клиентов. В отличие от VDI, здесь нет никаких разделяемых ресурсов, могут быть установлены любые операционные системы и любые подключаемые устройства. Но, естественно, такое решение дороже— лезвий должно быть ровно столько, сколько клиентов. У пользователей появляется возможность выбора; скорее всего, предложение от Teradici окажется предпочтительнее для тех, кому нужен существенный интерфейсный потенциал.

В Teradici готовят к выпуску лезвия с предустановленной микросхемой Tera Host. Они будут стоить примерно 1,5 тыс. долл., что выше стоимости даже высокопроизводительных рабочих станций, однако надо учесть, что стоимость эксплуатации заметно ниже, а потому удастся сэкономить на совокупных затратах.

Решение PC-over-IP рассчитано на сети со скоростью передачи данных 100 Мбит/с и требует серьезного анализа потребностей пользователей, чтобы оптимальным образом распределить между ними сетевые ресурсы.

Ультратонкий клиент

Группа разработчиков протокола Virtual Network Computing (VNC) объединилась в общественную организацию Ndiyo, которая ставит своей целью создание открытого решения, ориентированного на широкие пользовательские круги. Они считают, что не слишком успешная история тонких клиентов объясняется тремя основными причинами. Во-первых, в большинстве своем известные тонкие клиенты— это усеченные ПК, поэтому они не так дешевы, как хотелось бы. Во-вторых, они не так производительны, как обещано. И, в-третьих, они рассчитаны на корпоративные системы с сотнями и тысячами рабочих мест. Требуется действительно дешевая и общедоступная альтернатива парадигме «один компьютер— один пользователь». В таком качестве Ndiyo предлагает свой собственный нулевой клиент Nivo (Network In, Video Out), подключаемый к Linux-серверу. Существует две версии решения— Ethernet Nivo и USB Nivo (рис. 9).

Группа разработчиков протокола Virtual Network Computing (VNC) объединилась в общественную организацию Ndiyo, которая ставит своей целью создание открытого решения, ориентированного на широкие пользовательские круги. Они считают, что не слишком успешная история тонких клиентов объясняется тремя основными причинами. Во-первых, в большинстве своем известные тонкие клиенты— это усеченные ПК, поэтому они не так дешевы, как хотелось бы. Во-вторых, они не так производительны, как обещано. И, в-третьих, они рассчитаны на корпоративные системы с сотнями и тысячами рабочих мест. Требуется действительно дешевая и общедоступная альтернатива парадигме «один компьютер— один пользователь». В таком качестве Ndiyo предлагает свой собственный нулевой клиент Nivo (Network In, Video Out), подключаемый к Linux-серверу. Существует две версии решения— Ethernet Nivo и USB Nivo (рис. 9).

Клиент в розетке

Израильская компания Chip PC Technologies пошла еще дальше, предложив упаковать весь традиционный тонкий клиент в стенную розетку— Jack PC, то есть «ПК в разъеме» (рис. 10). Jack PC комплектуется встроенной ОС Windows CE .NET 4.2, процессором AMD Au 1550 RISC, флэш-памятью 64 Мбайт, оперативной памятью 128 Мбайт и видеопамятью 8 Мбайт. В комплект входит клиент Citrix ICA, клиент Microsoft RDP, а в отсутствие серверной инфраструктуры благодаря наличию браузера Internet Explorer компьютер может быть использован для доступа в Internet и для выполнения сетевых приложений.

Израильская компания Chip PC Technologies пошла еще дальше, предложив упаковать весь традиционный тонкий клиент в стенную розетку— Jack PC, то есть «ПК в разъеме» (рис. 10). Jack PC комплектуется встроенной ОС Windows CE .NET 4.2, процессором AMD Au 1550 RISC, флэш-памятью 64 Мбайт, оперативной памятью 128 Мбайт и видеопамятью 8 Мбайт. В комплект входит клиент Citrix ICA, клиент Microsoft RDP, а в отсутствие серверной инфраструктуры благодаря наличию браузера Internet Explorer компьютер может быть использован для доступа в Internet и для выполнения сетевых приложений.

Зеленый минимализм

Продукты, предлагаемые компаниями Applica, MiniFrame и NComputing, объединяет то, что они предназначены для распределенного использования ПК.

От многопользовательской DOS до Applica Lite

В свое время экономическое преимущество режима разделения времени и возможность рационального использования ресурсов мэйнфреймов стимулировали многочисленные попытки создания многопользовательских операционных систем для IBM PC на основе DOS. Первым на этом пути был Гари Килдалл, в силу совершенно непонятных причин упустивший свой шанс стать поставщиком ОС для IBM. В попытке компенсировать эту неудачу принадлежащая ему компания Digital Research в 1986 году выпустила многопользовательскую версию DR Concurrent DOS, оказавшуюся нишевым продуктом и особого успеха не принесшую; тем не менее, впоследствии эта система продолжила существование под именем Novell Multiuser DR DOS. Немного позже свою версию Concurrent DOS предложила компания Concurrent Controls; в течение определенного времени она широко использовалась в качестве встроенной системы. В конце 90-х компания разработала технологию для распределенного доступа к Windows-компьютерам. Тогда же от нее отпочковалась компания Applica, выбравшая своей специализацией недорогие решения для школ. Эту компанию можно считать ветераном «зеленого движения» в ИТ-отрасли.

Сегодня Appica разрабатывает несколько технологий, связанных с компрессией и передачей мультимедийных данных, но в данном контексте нас интересует ее самая давняя привязанность. Термином «нулевой клиент» в Appica обозначают набор компонентов, включающий в себя монитор, клавиатуру и мышь, но исключающий какие-либо процессорные мощности. Все действия такого клиента выполняются централизованно на «ПК-хозяине» Host PC, к которому нулевые клиенты подключены по схеме «звезда». Такую конструкцию в Applica именуют кластером; кластеры могут существовать независимо или объединяться в сеть. В отличие от обычного ПК, имеющего по одному адаптеру дисплея, порту мыши и контроллеру клавиатуры, у Host PC этих устройств по числу подключенных нулевых клиентов (рис. 11). Работающее на нем программное обеспечение поддерживает несколько сессий, ассоциированных с каждым из клиентов. Очевидно, что поддержку нулевого клиента осуществлять намного проще, чем тонкого, и столь же ясно, что это решение менее универсально, но дешевле и в ряде приложений вполне оправдано.

Applica предлагает адаптер хоста в нескольких вариантах, в том числе с возможностью подключения до четырех мониторов, кроме того, есть версия адаптера клиента SX 200, позволяющая отнести его на расстояние до 300 метров от хоста.

Основной областью применения Appica Lite является образование, с небольшим набором дополнительного оборудования пять учащихся вполне могут работать на одном ПК. Однако с равным успехом такие решения могут быть использованы в небольших офисах, для дома, а также там, где по климатическим условиям предпочтительнее дистанционное подключение к ПК. Кроме того, тот же самый адаптер хоста может быть использован для создания многоэкранных конфигураций.

От мэйнфрейма до MiniFrame

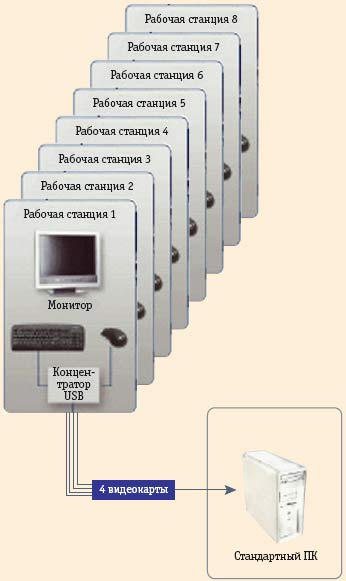

Когда появились мощные Unix-серверы, их стали называть мидфреймами, и вот наступила очередь минифреймов. Этот термин ввела одноименная израильская компания MiniFrame, которая предлагает решение, очень близкое по своей логике к Applica Lite, но за одним существенным исключением: оно полностью строится на стандартной аппаратной основе, то есть решение чисто программное. Компания основана в 2003 году, а потому нет ничего удивительного в том, что она использовала соответствующий уровень наработок. Для подключения нескольких мониторов применяются дополнительные графические платы; на каждый подключаемый монитор необходим собственный разъем. Эти платы используются не только как интерфейсные устройства, встроенные в них графические процессоры играют важную роль для повышения системной производительности. Для подключения остальной периферии можно использовать стандартные концентраторы портов USB. Таким образом, чтобы подготовить подобный кластер, достаточно взять обычный ПК с Windows XP Professional SP2 и доукомплектовать его необходимым количеством видеокарт (рис. 12). Возможно расширение, позволяющее построить класс на 24 рабочих места, для чего можно объединить в локальную сеть четыре кластера (таким образом, на класс потребуется всего четыре компьютера).

Решение MiniFrame SoftXpand обеспечивает создание многопользовательской рабочей станции без деградации производительности, более того, за счет запатентованной технологии взаимодействия между центральным процессором и графическим ускорителем производительность клиентского рабочего места может быть выше, чем самого хоста без графического процессора. Заложенные в SoftXpand алгоритмы обеспечивают оптимальное распределение нагрузки между центральным и графическим процессором, в итоге на нулевых клиентах трехмерные приложения и приложения с большой графической нагрузкой выполняются практически с той же скоростью, что и на специализированной графической станции.

Третье пришествие Стивена Дуккера

Движущей силой еще одной экономичной инициативы стал Стивен Дуккер, персонаж, безусловно, заслуживающий представления. Его очередным детищем стала компания NComputing. С середины 80-х годов Дуккер ведет заочное соревнование с Майклом Деллом. Еще в середине 90-х Дуккер через созданную им компанию наладил поставку ПК из Юго-Восточной Азии и продавал их по цене ниже 500 долл. В конце 90-х Дуккер пошел еще дальше, создал компанию eMachines и снизил цену до 400 долл., но и на этот раз он подвергся сильнейшему давлению со стороны тех, кто не хотел терять маржу; к тому же настал известный кризис, и компания была продана Gateway. В своем третьем пришествии Дуккер предлагает альтернативу проекту «Ноутбук каждому ребенку» OLPC (One Laptop Per Child, OLPC). На поставленном им оборудовании учится более полумиллиона школьников в 70 странах. Наиболее амбициозным обещает стать проект в Македонии, где вся образовательная система будет построена на комбинации ПК, работающего под управлением Ubuntu Linux, и оборудования от NComputing, распределяющего ресурсы этого ПК между 30 школьниками. По утверждению Дуккера, такое рабочее место обходится не дороже 70 долл., что намного дешевле широко распропагандированного «100-долларового ноутбука», который уже сегодня стоит дороже 200 долл.

Продукция NComputing выпускается в двух вариантах. Схема L Series предназначена для подключения по Ethernet, а X Series— для прямого подключения. В первом случае максимальное число дополнительных терминалов достигает 30, во втором— семи. Предлагаемое решение (рис. 13) имеет аппаратные и программные составляющие. Для подключения по схеме L Series необходимо снабдить каждый терминал адаптером (сегодня выпускается две модели— L120 и L230, а на хосте установить программный пакет NCT-2000-XP. Если же используется схема Х Series, то в зависимости от числа терминалов в PCI разъемы хоста монтируется одна или две управляющих платы, и инсталлируется пакет NCX-2000-XP, а терминалы дополняются адаптерами X300.

Объединяет всеописанные минималистские решения то, что расплатой за экономию энергии и инвестиций является невысокая надежность. При выходе из строя одного ПК становится невозможной работа всего кластера, следовательно, требуется резервирование и регулярное резервное копирование.

***

Сложно выделить отдельные составляющие «зеленого движения». Этот процесс быстро распространяется во всей индустрии и в той или иной форме находит отражение во множестве сегодняшних инноваций.

Литература

-

Peter Huber, Dig more coal— the PCs are coming. Forbes, May 1999.

-

«Проектирование систем кондиционирования ЦОД». «Мир климата», № 44, 2007, www.mirklimata.ru/archive/number44/article/44_art12.

Чему учиться?

http://www.osp.ru/os/2003/02/182640

Ренессанс виртуализации— вдогонку за паровозом

http://www.osp.ru/os/2007/02/4107980

Эти разные тонкие клиенты

http://www.osp.ru/os/2004/04/184157