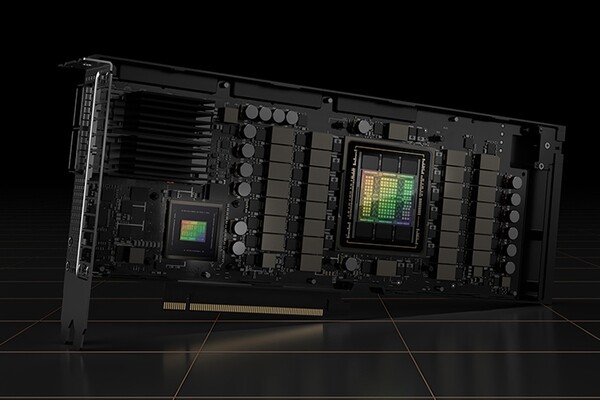

Свою вторую в этом году конференцию GTC компания Nvidia начала с новостей о том, что ее графические процессоры H100 'Hopper' запущены в серийное производство, а глобальные партнеры планируют представить соответствующие продукты и услуги уже в октябре. В первом квартале 2023 года они станут доступны повсеместно.

От архитектуры предыдущего поколения Ampere, представленной в 2020 году, Hopper отличается целым рядом инновационных решений. Наиболее существенным из них стал новый движок Transformer. Трансформеры широко используются в моделях глубинного обучения и представляют собой стандартное решение для обработки естественного языка. В Nvidia утверждают, что движок H100 Transformer Engine способен ускорить работу нейронных сетей в шесть раз по сравнению с Ampere без потери точности.

В Hopper реализована технология Nvidia Secure Multi-Instance GPU (MIG) второго поколения, позволяющая разделить один графический процессор на несколько защищенных разделов, которые работают изолированно и независимо друг от друга.

Новая функция конфиденциальных вычислений защищает модели искусственного интеллекта и данные клиентов в процессе их работы в дополнение к уже имеющейся защите в состоянии покоя и при передаче по сети. И наконец, в Hopper реализована высокоскоростная технология межкомпонентных соединений Nvidia NVLink четвертого поколения, позволяющая подключать до 256 графических процессоров H100. Ее пропускная способностью в девять раз превышает пропускную способность технологии предыдущего поколения.

Обычно графические процессоры не отличаются высокой энергоэффективностью. Однако H100 позволяет обеспечивать ту же производительность искусственного интеллекта при снижении энергопотребления в 3,5 раза, а общей стоимости владения – в 3 раза по сравнению с предыдущим поколением. При этом организациям требуется в 5 раз меньше серверных узлов.

Клиенты компании стремятся развернуть ЦОДы, которые, по сути, являются фабриками, выпускающими искусственный интеллект для производственных сценариев использования, – пояснили в Nvidia. Использование H100 обеспечивает увеличение пропускной способности, расширение функциональных возможностей и дальнейшую повсеместную демократизацию искусственного интеллекта.

Важнейшим сценарием использования H100 при поддержке искусственного интеллекта станут большие языковые модели (large language models, LLM), считают в Nvidia. Языковые модели обучены предсказывать следующее слово во фразе, как это происходит при включении функции автозаполнения на телефоне или в браузере. Модели LLM может предсказывать целые предложения и даже больше – например, писать эссе, создавать диаграммы и генерировать программный код.

В Nvidia подчеркнули, что сфера применения больших языковых моделей выходит за рамки человеческого языка. Они могут использоваться, например, для написания программного кода, помогая разработчикам создавать программное обеспечение быстрее, эффективнее и с меньшим количеством ошибок.

Ожидается, что системы на базе H100 поступят в продажу в ближайшие недели. К концу года на рынке появится более 50 серверных моделей, а в первой половине 2023 года – еще десятки. В роли партнеров Nvidia здесь выступают компании Atos, Cisco, Dell, Fujitsu, Gigabyte, HPE, Lenovo и Supermicro.

Amazon Web Services, Google Cloud, Microsoft Azure и Oracle Cloud Infrastructure в числе первых начнут разворачивать в облаке системы на основе H100, начиная со следующего года.

Желающие опробовать H100 могут проделать это с помощью сервиса Launchpad, позволяющего подключиться и протестировать оборудование Nvidia, в том числе и H100.

.png)