Система Jaguar, установленная в Национальной лаборатории в Окридже (CША), – уникальная вычислительная установкой, которая модернизируется уже не первый год, в результате чего в ней оказались интегрированы суперкомпьютеры Cray XT4 и ХТ5.

Система Jaguar, установленная в Национальной лаборатории в Окридже (CША), – уникальная вычислительная установкой, которая модернизируется уже не первый год, в результате чего в ней оказались интегрированы суперкомпьютеры Cray XT4 и ХТ5.

Семейство Cray XT5

Компания Cray в недавнем прошлом предлагала суперкомпьютеры разной архитектуры – векторные, многопоточные, на базе микросхем FPGA-архитектуры, но, пожалуй, наибольший успех получили МРР-системы семейства ХТ на базе процессоров AMD Opteron.

Cray XT3 с одноядерными Opteron появился вскоре после выхода этих процессоров на рынок в 2005 году, затем появились конфигурации с двухъядерными процессорами. XT4 на базе двухъядерных Opteron был выпущен в 2007 году. ХТ5 с четырехъядерными процессорами Barcelona/2,6 ГГц (а затем и Shanghai/2,7 ГГц) и шестидерными Istanbul/2,6 ГГц, поставлялся уже в прошлом году [1-3]. При этом число процессорных разъемов в узле XT5 возросло до двух. Недавно в Cray объявили о выпуске систем Cray XT6 на базе шести- и восьмиядерных Opteron серии 6100 [3].

Процессоры других типов, с которыми работали в Cray, нашли применение в составе специализированных модулей-лезвий в рамках гибридной системы ХТ5h. Таким образом, семейство ХТ вобрало в себя процессоры разных архитектур, став единой линейкой продукции. По мнению автора, возможность использования в качестве части модулей лезвий векторной обработки экономически целесообразно. Компьютеры векторной архитектуры от Cray в последние годы уступали по характеристикам векторным системам NEC SX. Область же применения других архитектур достаточно ограничена.

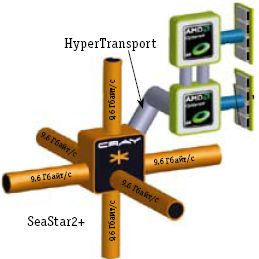

Характеризуя МРР-архитектуру Cray XT в целом, следует подчеркнуть, что она включает узлы, связанные «фирменным» межсоединением SeaStar c топологией трехмерного тора. Остановимся на рассмотрении систем Cray XT5 и ХТ6 (Cray предлагает модернизацию ХТ4 до ХТ5, а ХТ5 – до ХТ6). Узлы ХТ5 содержат ASIC-микросхему, обеспечивающую работу с межсоединением SeaStar2+, два процессорных разъема для Opteron и слоты для модулей DIMM (рис. 1). В Cray XT4 узел был устроен аналогичным образом, но имел один процессорный разъем.

Для связи микросхемы межсоединения с Opteron естественным образом применяются интегрированные в микропроцессор интерфейсы каналов HyperTransport 2.0 (прямое подсоединение оперативной памяти к процессору – одна из основных особенностей всех моделей Opteron). В результате пропускная способность оперативной памяти масштабируется с числом процессоров, и в расчете на узел пропускная способность памяти составляет 25,6 Гбайт/с (применяется защищенная кодами ЕСС регистровая память DDR2-800). Емкость оперативной памяти узла составляет от 8 Гбайт до 32 Гбайт (см. Таблицу).

А вот процессоры в узле могут применяться разные – четырехъядерные Barcelona и Shanghai с разными частотами, а также шестиядерные Istanbul. Соответственно суммарное число ядер в узле составляет восемь или двенадцать, а пиковая производительность узла лежит в диапазоне примерно от 70 GFLOPS до 124 GFLOPS.

Типичный узел современного HPC-кластера также чаще всего является двухпроцессорным, а потому никаких серьезных отличий в архитектуре и производительности вычислительного узла ХТ5 мы не обнаружим, разве что межсоединение в узлах наиболее мощных кластеров из Тop500 – это обычно Infiniband.

Следующий уровень конструктива над узлом XT5 – лезвие, содержащее четыре узла. При использовании Istanbul производительность лезвия достигает 500 GFLOPS; ему отвечает решетка узлов 1х2х2.

В стойке можно реализовать решетку узлов 1х4х24 (24 лезвия по четыре узла) с производительностьюдо 12 TFLOPS при емкости оперативной памяти 1,54 Тбайт (из расчета 16 Гбайт на узел), а в системе XT5 в целом – решетку 25х32х24. Такой системе отвечает производительность порядка 2 PFLOPS и емкость памяти 300 Тбайт [4]. В соответствии с указанными на сайте Cray спецификациями ХТ5, стойка занимает площадь примерно 0,6м х 1,4 м при высоте около 2 м, весит порядка 700 кг и потребляет не более 43 кВт.

Межсоединение SeaStar2+ поддерживается благодаря соответствующей микросхеме (рис. 2), обеспечивающей маршрутизацию и имеющей шесть портов с пропускной способностью 9,6 Гбайт/с на порт. Это отвечает суммарной пропускной способности микросхемы в 57,6 Гбайт/с, в то время как задержка передачи из узла в узел не превышает 2 мкс. Кроме шестипортового маршрутизатора и интерфейса HyperTransport, микросхема SeaStar2+ содержит механизм прямого доступа в память (Direct Memory Access, DMA), поддержку интерфейса управления лезвием и другие средства.

Для повышения надежности в SeaStar2+ применяются коды ЕСС, используется адаптивная маршрутизация, а сбойные каналы можно «обойти» без перезагрузки.

В SeaStar для передачи данных не надо устанавливать соединения, поэтому нет кэширующих очередей между парами узлов. Это облегчает работу Cray XT c большим числом узлов. Удвоение числа виртуальных каналов (до четырех) по сравнению с предыдущим поколением SeaStar позволило поднять поддерживаемую пропускную способность на 30%, составляющую 6 Гбайт/с1.

Заметим, что более высокая пропускная способность межсоединения уже могла бы натолкнуться на узкое место в виде канала HyperTransport (6,4 Гбайт/с для HyperTransport 2.0). Для сравнения, пропускная способность современного варианта Infiniband 4x QDR составляет 4 Гбайт/с для однонаправленной передачи при аппаратных задержках на уровне меньше 2 мкс.

Таким образом, аппаратура и узлов, и межсоединения Cray XT5 по производительности не превосходит соответствующие параметры Infiniband-кластеров. Выгоды Cray XT5 связаны в основном с возможностями построения систем со сверхбольшим числом узлов.

В Cray XT5 межсоединение SeaStar2+ позволяет объединить сотни стоек. Кроме моделей ХТ5, Сray поставляет XT5m (от англ. medium, «средний»), которые имеют не столь большие, как ХТ5, конфигурации. В ХТ5m задействованы не все шесть, а только четыре порта маршрутизатора SeaStar, соответственно применяется иная топология межсоединения – двухмерный тор. При этом пропускная способность межсоединения узла уменьшается до 38,4 Гбайт/с.

Модуль SeaStar2+ реализован как съемный, что позволяет осуществлять модернизацию межсоединения отдельно от процессоров и памяти. Поэтому Cray XT4 можно модернизировать до XT5, Cray XT5 – до XT6 (в последнем случае меняются процессоры и оперативная память), а в ХТ6 межсоединение, вероятно, можно будет заменить на модуль на базе перспективной коммуникационной микросхемы Cray Gemini, что будет отвечать переходу к системам, получившим известность под кодовым названием Baker. Затем, уже в 2011 году, будет возможна модернизизация с переходом на процессоры AMD Bulldozer с 12 или 16 ядрами, которые будут изготавливаться по 32-нанометровой технологии [2].

В трехмерной решетке часть узлов может быть выделена в качестве сервисных узлов (рис. 3), которые имеют один, а не два процессорных разъема, а для связи с «внешним миром» могут применяться шины PCI-Express [1,5]. Дополнительно могут использоваться и сетевые протоколы Gigabit Ethernet, 10 Gigabit Ethernet, Infiniband, а также Fibre Channel. Возможно подключение дисковых массивов Fibre Channel и SATA.

Такое подключение жестких дисков характерно, когда применяются одиночные суперкомпьютеры Cray XT. Узлы, через которые происходит такое подсоединение, Cray называет SIO-узлами (Storage-I/O).

В случае, если компьютерных систем несколько, теперь обычно применяются общие системы хранения. Cray предлагает высокопроизводительные системы хранения на базе Lustre, масштабируемой, надежной параллельной файловой системы с открытым кодом; она обеспечивает работу тысяч узлов, 1 Пбайт дисковой памяти и пропускную способность в сотни гигабайт в секунду. В качестве партнера Сray в области систем хранения выступает Sun Microsystems.

Cказанного во многом уже достаточно для того, чтобы понять целевую нишу Cray XT5 – эти системы в первую очередь представляют альтернативу большим и сверхбольшим кластерам. Cray XT5 – вычислительная система, обладающая высокой плотностью упаковки, эффективным энергопотреблением и системой охлаждения. XT5 обеспечивает высокую надежность крупномасштабных систем и относительную простоту эксплуатации (последнее во многом связано и с представлением XT как единой системы). C точки же зрения производительности при близких конфигурациях с кластером XT5 преимуществ не дает, но имеет, очевидно, более высокую стоимость.

Про надежность многое уже было сказано. Когда в кластере десятки тысяч и более узлов, выход из строя отдельных компонентов (например, вентиляторов) – постоянная головная боль. MTBF (cреднее время между сбоями) для вентиляторов в кластере на 10 стоек (250 вентиляторов) составляет всего около 26 часов. В Сray XT5 применяются мощные турбовентиляторы, подающие холодный воздух снизу и имеющие MTBF на 10 стоек в 15 лет [6].

Кроме того, в лезвиях Cray XT применяются управляющие процессоры, по одному на лезвие (24 на стойку), плюс управляющие процессоры стойки. Имеется специальная выделенная сеть управления на базе Gigabit Ethernet и рабочая станция управления системой.

В XT5 применяются избыточные блоки питания и регуляторы вольтажа (VRM), что позволяет дополнительно повысить надежность. В спецификации к ХТ5 также указано, что для контроля за ядрами в системных лезвиях применяется специальная подсистема Cray Hardware Supervisory System. К RAID-массивам обеспечиваются избыточные пути, а в составе Lustre предусмотрен специальный сервер для преодоления сбоев.

Базовым механизмом охлаждения в ХТ5 является воздушное, однако Cray предлагает также жидкостное охлаждение [6,7]. Сray применяет технологию ECOphlex с двухконтурной системой охлаждения: ближе к аппаратуре охлаждение производится с применением хладагента R134a, а уже его во внешнем контуре охлаждает вода.

Такая схема оказывается весьма эффективной с точки зрения энергопотребления: на охлаждение расходуется примерно 25% суммарной энергии, потребляемой вычислительной системой, в то время как обычно эта величина достигает 45% [8].

ECOphlex – уже седьмая по счету жидкостная система охлаждения разработки Cray, в ней использована технология с фазовым переходом «жидкость-газ», что на сегодняшний день признается наиболее эффективным подходом, на порядок более эффективным, чем обычное водяное охлаждение. В ECOphlex можно применять теплую воду (до 16 градусов Цельсия), что способствует уменьшению затрат на охлаждение [6].

Cамая мощная суперкомпьютерная установка, базирующаяся на Cray XT5 – Jaguar содержит свыше 224 тыс. процессорных ядер, и при пиковой производительности свыше 2,3 PFLOPS на тестах High Performance Linpack достигла около 1,8 PFLOPS. Общая емкость оперативной памяти Jaguar составляет около 300 Тбайт, дискового пространства – 10 Пбайт, производительность ввода-вывода – 240 Гбайт/с. Энергопотребление Jaguar достигает 7 МВт [4].

«Гибридные» системы XT5h

Кроме «обычных» суперкомпьютеров Сray может поставлять гибридные системы, в которых часть лезвий состоит из узлов иной архитектуры. Такие узлы могут использовать векторные процессоры или программируемые логические матрицы FPGA.

Лезвия векторной обработки Cray X2

Можно сказать, что векторные процессоры сегодня в мире почти не используются (естественно, речь не идет о GPGPU или процессорах х86-архитектуры c векторными расширениями системы команд типа SSE, включающими обработку очень коротких векторов). Кроме унаследованных приложений, к применению векторных систем могут подтолкнуть, пожалуй, только очень высокие требования к пропускной способности оперативной памяти, где векторные процессоры – при обращении к последовательным адресам памяти – обладают преимуществами.

Для таких приложений в XT5h могут поставляться лезвия векторной обработки Cray X2. Эти вычислительные лезвия включают по два векторных вычислительных узла. Каждый узел представляет собой четырехпроцессорную SMP-систему с общим полем оперативной памяти емкостью 32-64 Гбайт (рис. 4).

Векторные процессоры (V) работают на частоте 1,6 ГГц, имеют производительность 25,6 GFLOPS и являются одноядерными. Каждый V содержит суперскалярный процессор и восемь векторных конвейеров. В состав V входит три уровня кэша, в том числе 512 Кбайт кэша второго уровня и 8 Мбайт – третьего. Обеспечивается когерентность кэш-памяти разных V.

Производительность узла составляет свыше 100 GFLOPS (это, однако, меньше, чем у «обычных» узлов на базе Istanbul), а пропускная способность оперативной памяти в расчете на один V равна 28,5 Гбайт/с.

Внутри узла оперативная память однородна по времени доступа, но при доступе в память другого узла мы имеем модель NUMA. Для связи векторных узлов применяется другое, разработанное Cray, межсоединение с топологией «толстого дерева», представляющей собой один из вариантов сети Клоза.

Пропускная способность межсоединения для связей «точка-точка» составляет 9,4 Гбайт/с; в Сray говорят и о низких величинах задержки. Архитектурно возможно масштабирование векторной подсистемы ХТ5h до 32K векторных процессоров, работающих с общим глобальным адресным пространством.

Таким образом, речь фактически идет о векторной многопроцессорной системе с собственным межсоединением, «погруженной» в Cray XT5. Для взаимодействия векторной подсистемы с межсоединением SeaStar2+ применяются прямые интерфейсы в узлах, имеющие пропускную способность 4,8 Гбайт/с (рис. 4).

Лезвия этой векторной подсистемы размещаются в стойках высотой 2м и основанием 1м х 1,6м, вес которых составляет 1,1 тонн, а энергопотребление – до 45 кВт.

Лезвия с реконфигурируемой архитектурой

В Cray XT5h могут применяться лезвия XR1 с FPGA-процессорами. Каждое лезвие имеет два узла (рис. 5). Узлы содержат по одному процессору Opteron, который каналами HyperTransport связан с SeaStar2+ и с модулем RPU (Reconfigurable Processor Unit) разработки компании DRC Computer.

RPU (всего их в узле два) размещаются в процессорных разъемах AMD Socket 940 и поддерживают три интерфейса HyperTransport (через эти каналы два RPU связаны между собой) и 128-разрядные каналы в оперативную память DDR-400 c пропускной способностью 6,4 Гбайт/с. Этот же тип памяти используется в узле как локальная память для Opteron, но емкость последней составляет от 2 Гбайт до 8 Гбайт, а емкость локальной памяти для RPU – от 1 Гбайт до 4 Гбайт.

DRC предлагает на рынке несколько моделей RPU; в узлах XR1 применяются RPU LX200/LP, в которых использованы мощные FPGA-процессоры Xilinx Virtex-4. LX-200 содержит 200448 логических ячеек и собственную память на плате с пропускной способностью 14,4 Гбайт/с. В RPU применяется память типа RLDRAM емкостью 256 Мбайт. Пропускная способность «внешних» (для FPGA) HyperTransport-каналов cоставляет 6,4 Гбайт/с – для интерфейса с SeaStar, 3,2 Гбайт/с – для интерфейса с Opteron.

В одной системе ХТ5h может содержаться до 30 тыс. FPGA-процессоров Virtex-4, из расчета до 48 узлов (96 RPU) на стойку, с затратами на электропитание – до 12 кВт на стойку. Применение в RPU разъема, совместимого с Socket 940, и поддержка HyperTransport представляется эффективным техническим решением, обеспечивающим высокую пропускуную способность и низкие задержки.

FPGA-подсистема ХТ5h может применяться для задач криптографии, рендеринга, сортировки, при поисках последовательностей, для некоторых задач моделирования и др.

Развитие линии ХТ5

Cray имеет далеко идущие планы по развитию архитектуры ХТ5 – уже объявлено о Cray XT6/XT6m [2]. Эти суперкомпьютеры используют межсоединение SeaStar2+, но в узлах применяются 8- или 12-ядерные Opteron cерии 6100. На своем сайте Cray привела некоторые подробности (см. Таблицу).

В 6100 наконец-то появились поддержка более быстрых каналов HyperTransport 3.0 и контроллер памяти DDR3, обеспечивающий пропускную способность оперативной памяти 85,3 Гбайт/с на два процессора. Емкость оперативной памяти узла составляет 32-64 Гбайт. Ядра Opteron 6100 имеют собственные кэши команд и кэши данных первого уровня емкостью по 64 Кбайт, кэши второго уровня емкостью 512 Кбайт, а также общий кэш третьего уровня емкостью 12 Мбайт. 24 ядра на узел дают пиковую производительность узла 182 GFLOPS. Cтойка размером 0,6х1,4х2,4м содержит 1536 или 2304 процессорных ядер и потребляет 45-54 кВт.

Модульность конструкции ХТ5/ХТ6 позволяет производить модернизацию ХТ5 до ХТ6; следующим шагом может стать модернизация межсоединения в ХТ6 – переход к новому межсоединению Gemini. Его выпуск намечен на третий квартал 2010 года, а соответствующие вычислительные системы имеют кодовое название Baker [3].

Коммуникационные микросхемы Gemini будут поддерживать от 10 до 12 каналов и обслуживать каждая сразу два узла Baker, используя интерфейс HyperTransport 3.0. В Gemini будет применяться 48-портовый маршрутизатор YARC c cуммарной пропускной способностью 168 Гбайт/с, и адаптивная маршрутизация. Естественно, обещано увеличение пропускной способности и уменьшение задержек. Про задержку между двумя узлами сообщается, что она будет меньше 2 мкс.

Естественно, и технологические характеристики Infiniband за это время улучшатся, а адаптивная маршрутизация уже поддерживается некоторыми коммутаторами Infiniband. В Gemini ожидается аппаратная поддержка односторонних коммуникаций и глобальное адресное пространство. Про следующее за Gemini межсоединение известно только его кодовое название – Aries [1,3].

В Национальной лаборатории в Окридже (США) с применением системы Baker планируют достигнуть производительности на уровне 10-20 PFLOPS.

Задержки и пропускная способность SeaStar2+ c применением тестов IMB исследованы, например, в [9]. Сегодня у SeaStar2+ преимуществ производительности нет. Единственное известное прямое сопоставление производительности Cray XT5 и современных Infiniband-кластеров для реальных приложений проведено для задач вычислительной химии [10]. В XT5 применялись шестиядерные процессоры Istanbul/2,6 ГГц, в кластере – процессоры Nehalem E5550/2,67 ГГц. При сопоставимых конфигурациях кластер оказался быстрее. С точки зрения производительности в расчете на единицу электрической мощности ХТ5 превосходит IBM Blue Gene/L, хотя и уступает Blue Gene/P [4].

***

Применение систем семейства Cray XT целесообразно в первую очередь в виде сверхбольших суперкомпьютерных конфигураций, где ХТ имеет преимущества перед обычными кластерами по надежности, энергоэффективности, плотности упаковки, простоте обслуживания, а также эффективности программного обеспечения.

Литература

- W.Oed, Cray Architecture and Software Support for PGAS Languages. HPDC-2009, Munchen, Jun. 12, 2009.

- Т.Р. Morgan, Cray Previews XT6 Opteron Nodes. Nov. 24, 2009 (www.theregister.co.uk/hardware/hpc).

- ethergrid.com/primeur/09/articles/live/LV-PL-06-09-37.html

- A.S. Bland, Challenges for High Performance Computing Facilities. Computing in Atmospheric Science-2009 Workshop, Sept 3, 2009.

- Cray XT5m Brochure. Сray, 2009.

- S. Yerneny, Massive Parallel Processing Systems. Сray India, Oct. 13, 2009.

- D. Gahm, M. Laatsch, Meeting the Demands of Computer Cooling with Superior Efficiency. Cray, 2009.

- The World's Most Powerful Computers for Science. www.scidacreview.org/0901/html/hardware.html

- G. Hager e.a., Communication Characteristics and Hybrid MPI/OpenMP Parallel Programming on Clusters of Multi-Core SMP Nodes. Сray User Group Meeting, Atlanta, May 4-7, 2009.

- M.F.Guest, C.A. Kithcen, Application Performance on multi-core clusters. Advanced Research Computing, ARCCA 20th Machine Evaluation Workshop, Dec. 2009, Cardiff Univ.

Михаил Кузьминский (kus@free.net) – старший научный сотрудник, Институт органической химии им. Н.Д. Зелинского РАН (Москва).

1 Везде речь идет о «двунаправленной» пропускной способности (дуплексном режиме передачи).

Таблица. Вычислительные узлы Cray XT5/XT6