Центральной темой выступления Стива Кеннистона, евангелиста IBM в вопросах повышения эффективности систем хранения, на ежегодной конференции «Решения IBM для информационной инфраструктуры» в Москве стала поддержка корпорацией концепции Больших Данных.

Как и многие аналитики, Кеннистон считает, что Большие Данные обусловят очередной сдвиг парадигмы в ИТ. Он подчеркнул важность решения задач, связанных с обработкой и хранением Больших Данных. Кеннистон привел наиболее подходящее, с его точки зрения, определение, опубликованное ранее в блоге вице-президента подразделения IDC Enterprise Platforms Мэтта Иствуда: «Big Data — это совокупное название нового поколения технологий и архитектур, обеспечивающих экономически эффективное извлечение ценных знаний из очень больших объемов весьма разнообразных данных посредством осуществляемых с высокой скоростью операций получения, выявления или анализа данных».

.jpg) |

|

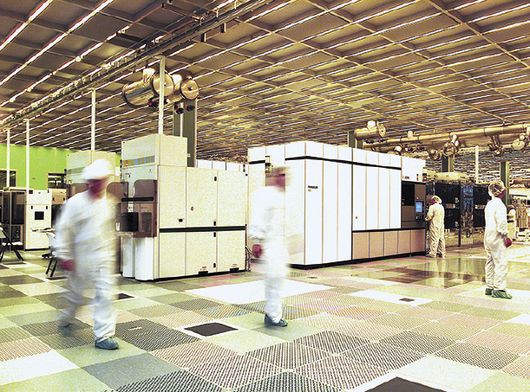

УСОВЕРШЕНСТВОВАНИЯ В СФЕРЕ производственной аналитики помогли IBM повысить эффективность управления своим предприятием по выпуску полупроводниковых компонентов в штате Нью-Йорк |

Сам же евангелист IBM назвал одним из важнейших признаков Big Data вкрапление в «обычные данные» сведений, полученных от большого числа внешних источников, таких, например, как социальные сети или сети датчиков на основе RFID. Кроме того, архитектуры Big Data отличаются особой гибкостью, высокой степенью масштабируемости и применением облачных технологий. В трактовке Кеннистона сценарий использования Больших Данных в организациях выглядит так: «Пользователи Big Data запрашивают сервисы Big Data из источников Big Data». К «пользователям» евангелист относит базовые корпоративные приложения и, например системы информационной безопасности. Сервисы, по его словам, формируются на основе технологии MapReduce, потоковых вычислений, анализа и собственно хранения данных. А к источникам он отнес всевозможные датчики, интеллектуальные сетевые устройства, базы данных, файловые серверы и т. п.

Критичную роль Кеннистон отводит аналитическим средствам и методикам, таким как мониторинг в реальном времени, прогнозирующее моделирование, применение визуальных информационных панелей. По его словам, в арсенале IBM уже имеются продукты, необходимые для выполнения этих задач.

IBM призывает заказчиков использовать свои инновации в области хранения, после того как сама опробовала их на практике. Кеннистон рассказал о нескольких знаковых проектах в области Big Data. Так, усовершенствования в сфере производственной аналитики помогли корпорации повысить эффективность управления своим предприятием по выпуску полупроводниковых компонентов, расположенным в штате Нью-Йорк. Ежедневно на этом предприятии проводится более 100 млрд измерений. Задействованные здесь аналитические инструменты заблаговременно предупреждают об отклонениях, способных отрицательно повлиять на производственные результаты и доходы подразделения. В этом примере эффективная обработка Больших Данных позволила сократить издержки на 32 млн долл. и повысить доходы на 21 млн долл. Другая инициатива, реализованная в масштабе всей корпорации, называется Territory Optimization Program, она предназначена для повышения качества проектирования зон продаж на основе возможностей будущего роста, а не ретроспективных данных. Улучшение территориального распределения продаж в 2010 году обусловило рост годового дохода на 600 млн долл.; в IBM ожидают, что в 2014 году этот показатель составит 1,1 млрд долл. В заключение Стив Кеннистон упомянул об Outage Prevention — концепции из области Big Data, основанной на подобии предшествующих событий. Согласно данной концепции, в компании производится ретроспективный анализ заявок, связанных с инцидентами, проблемами и изменениями, с целью выявления последовательностей предшествующих событий, которые имели отношение к остановкам. После этого на основе подобия с известными последовательностями предшествующих событий в компании производится мониторинг новых заявок с целью выявления потенциальных остановок, имеющих высокую вероятность наступления. Это, в свою очередь, позволило минимизировать количество инцидентов и простоев. Ценный опыт работы с Большими Данными могли бы взять на вооружение и российские компании, полагает Кеннистон.