В Microsoft уже вложили в компанию OpenAI, создавшую языковую модель ChatGPT, больше 11 млрд долл., но в дополнение к этим средствам она обеспечивает работу языковых моделей OpenAI на инфраструктуре облачной системы Microsoft Azure. Обучение моделей требует так много вычислительных ресурсов, что затраты на оборудование, по словам исполнительного вице-президента Microsoft Скотта Гатри, исчисляются сотнями миллионов долларов. При обучении модели все они должны работать параллельно и для большей эффективности располагаться поблизости друг от друга. При работе готовой модели также используются графические процессоры, но уже в распределенном режиме, и располагаются они в различных центрах обработки данных Azure по всему миру.

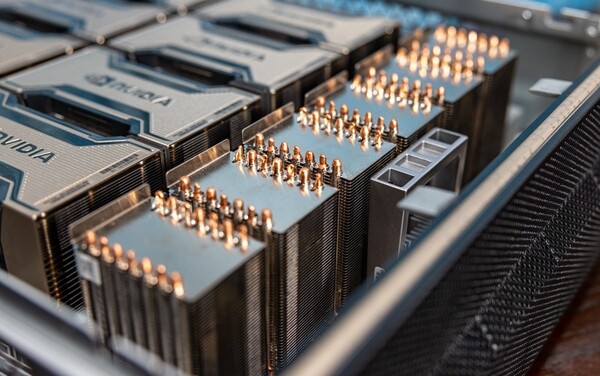

На таком же оборудовании работают новые виртуальные машины системы Azure ND H100 v5, о запуске которых Microsoft объявила 13 марта. В машине может быть от восьми до нескольких тысяч процессоров Nvidia H100 Tensor Core, обменивающихся данными по шинам NVSwitch с интерфейсом NVLink 4.0, а также процессоры Intel Xeon Scalable 4-го поколения и 16 каналов памяти DDR5.

.jpg)