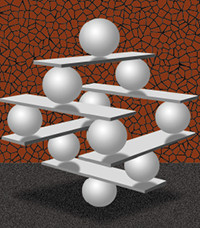

В ЦОД нет более и менее важного оборудования. Гораздо эффективнее рассматривать его как единую экосистему, состоящую из тщательно сбалансированных компонентов.

Принятие решений, от которых зависит функционирование центров обработки данных, становится все более сложным, ответственность за них распределяется между множеством лиц, поэтому стремление заниматься отдельными изолированными элементами вполне понятно. Между тем такой подход подчас приводит к весьма негативным последствиям. Гораздо эффективнее рассматривать ЦОД как единую экосистему, состоящую из тщательно сбалансированных компонентов.

Всего несколько лет назад в ЦОД начали широко применяться стоечные (top-of-rack) коммутаторы. С их помощью планировалось разгрузить кабельные каналы и сэкономить на кабельной инфраструктуре. Но, как оказалось, во многих ЦОД этот подход не работает.

Вместе с тем операторы центров обработки данных, где уже инсталлированы структурированные кабельные системы, способные поддерживать 10GBaseT, были разочарованы отсутствием на рынке экономичных коммутаторов, которые позволили бы использовать преимущества этих систем. Доступное оборудование оказалось дорогим и предъявляло высокие требования к электропитанию.

К тому же многие производители сетевого оборудования вместо перехода на 10GBaseT рекомендовали использовать более короткие нестандартные биаксиальные соединительные кабели в топологии ToR. Предполагалось, что это позволит сократить расходы на построение кабельной системы. Однако, хотя в этом отношении надежды и оправдались, одновременно выросли затраты на оборудование, обслуживание и электропитание, сведя на нет всю экономию.

Это показывает, что необходим более сбалансированный, целостный подход, где при принятии каждого решения, касающегося экосистемы ЦОД, учитывалась бы совокупная стоимость владения.

ОГРАНИЧЕНИЯ ПО ЭЛЕКТРОПИТАНИЮ

При проектировании оборудования ЦОД прежде всего нужно учитывать ограничение энергопотребления в расчете на стойку. За последние несколько лет ИТ-директора осознали это и теперь стремятся снизить энергопотребление. Да и виртуализация стала скорее нормой, чем исключением. Она позволила высвободить некоторые энергоресурсы, но никак не повлияла на тот факт, что мощность подаваемого в каждую стойку электропитания жестко ограничивает количество оборудования, которое в ней можно разместить. Еще одна тенденция — все более широкое использование площадей коммерческих ЦОД, в большинстве случаев тоже имеющих лимиты по электропитанию.

Если потребляемая мощность на стойку известна, можно составить четкое представление о том, какое количестве серверов, коммутаторов и другого оборудования, можно поместить в каждую стойку.

ОХЛАЖДЕНИЕ И ВЕНТИЛЯЦИЯ

С электропитанием — потребляемой мощностью — тесно связано охлаждение. Обязательно нужно знать, как организовано охлаждение всего помещения и конкретной стойки, и понимать, как влияют потоки воздуха на производительность оборудования. Поставщики устройств обычно указывают в спецификациях потребляемую мощность, но во многих ЦОД отсутствует очень важная информация о циркуляции потоков воздуха в целом. Нередко рассредоточение выделяющего много тепла оборудования по помещению оказывается более практичным вариантом, чем его концентрация в одном месте, поскольку последнее приводит к созданию горячей зоны и требует дополнительного охлаждения.

ЗНАЧИМОСТЬ ПРИЛОЖЕНИЙ

Безусловно, каждый департамент старается сделать для своей компании все возможное, но в экосистеме ЦОД нет более и менее важного оборудования. Поэтому при планировании заполнения стоек потребуется комплексная экспертиза размещаемого оборудования. Нужно гарантировать, что оно не только новейшее и лучшее, но также будет поддерживать требуемые сервисы и обеспечит возврат инвестиций.

Например, при выборе серверного оборудования критерий относительно прост: во внимание принимаются вычислительная мощность, общая потребляемая мощность, необходимые сетевые соединения, средства управления, скорость ввода-вывода и т. д. Прежде чем отдать предпочтение той или иной операционной системе и определенному уровню поддержки, надо обратить внимание на приложения, которые будут функционировать на этой ОС.

Когда-то решения о покупке серверов принимались в основном по рекомендации разработчика приложений. Открытые системы изменили эту ситуацию, но некоторые приложения все равно более «дружественны» к определенным типам аппаратного обеспечения, поскольку разработчики тестируют свое программное обеспечение на конкретных аппаратных платформах. Поэтому самый простой выход — ориентироваться именно на это оборудование.

Ввод-вывод и системы хранения тоже претерпели изменения за последние годы: Fibre Channel теперь поддерживает 16 Гбит/с, превышая распространенную скорость Ethernet. (Fibre Channel — давно известная и проверенная технология, отличающаяся низкими непроизводительными потерями и высокой стабильностью.) Бытует мнение, что Fibre Channel over Ethernet (FCoE) позволяет сэкономить на кабельной инфраструктуре, но если проанализировать требования относительно поддержки данной технологии, то зачастую выявляется необходимость проведения реконфигурации серверов и коммутаторов.

По сути, «высокоэффективные» пакеты с низкими непроизводительными издержками помещаются в пакеты с высокими издержками на сетевой протокол, допускающий их повторную передачу. Чтобы преодолеть проблемы, которые могут возникать при работе приложений, рекомендуется, например, выполнить переход к сети с более «плоской» структурой и работать на втором сетевом уровне вместо третьего.

МЕСТО РАЗМЕЩЕНИЯ КОММУТАТОРОВ

Если говорить о коммутации, то за относительно короткое время она подверглась множеству изменений. Широкое распространение получили стоечные (Top of Rack, ToR) коммутаторы. Идея состоит в том, чтобы поместить их в верхнюю часть стойки, соединить с агрегирующим коммутатором и через него — с ядром сети. Однако анализ потоков трафика в ЦОД показывает, что большая часть межсерверного трафика — это трафик «восток – запад», циркулирующий только внутри ЦОД. Следовательно, важно свести к минимуму число транзитных узлов — хопов, через которые проходит трафик.

В случае коммутаторов ToR вполне можно было бы использовать, если бы это допускалось, кабели Категории 5e или 6 — такая инфраструктура обеспечивает передачу данных со скоростью 1 Гбит/с. Однако во всех европейских, американских и международных стандартах для центров обработки данных, а также в рекомендациях DCA и в других документах утверждается, что медножильные кабели в ЦОД должны соответствовать как минимум Категории 6A / Классу EA и поддерживать 10 Гбит/с. Таким образом, при переходе на новые скорости передачи данных не придется модернизировать кабельную проводку в стойке.

Для скоростей, превышающих 10 Гбит/с, например 40 и 100 Гбит/с, обычно предусматривается прокладка оптики. Однажды инсталлированные волоконно-оптические кабели, простые в прокладке и экономичные, всегда готовы для будущих технологий. В то же время следует обратить пристальное внимание и на витую пару нового поколения, которую в настоящее время изучают организации, занимающиеся стандартизацией.

Пользователи хотят быть уверены в том, что покупают коммутаторы исходя из количества портов серверов, которым требуется подключение к сети, а не стоек в ЦОД. Ведь неиспользуемые порты обходятся дорого, причем это не только начальные инвестиции, но и затраты на электроэнергию (потребляемую ими даже в режиме простоя) и обслуживание.

Новым коммутаторам 10GBaseT необходимо меньше электроэнергии, чем их предшественникам с прямым подключением по меди, они обладают более низкой задержкой, поддерживают значительные расстояния и, кроме того, заметно дешевле по сравнению с коммутаторами, оснащенными оптическими портами. Нередко при организации прямого подключения к SFP+ эти кабели относятся к инвестициям в сетевое оборудование. Поставщики коммутаторов ToR обещают сократить затраты на структурированную кабельную инфраструктуру, но в действительности это означает смену продавца, у которого покупается кабель. Соединительные шнуры (для прямого подключения) имеют гарантию 90 дней, в то время как на канал структурированной кабельной системы большинство производителей дают 20-летнюю гарантию.

Важно отметить также, что применяемые в СКС соединители RJ-45 обладают взаимозаменяемостью и обратной совместимостью, в то время как многие кабели для прямого подключения сейчас предназначены только для работы с определенными коммутаторами и сетевыми картами серверов. При переходе на аппаратное обеспечение другого производителя эти нестандартные кабели подлежат замене.

Однако намного более дорогостоящими элементами коммутации ToR являются неиспользуемые порты. Как уже отмечалось выше, потребляемая мощность — серьезное ограничение для оборудования, которое можно поместить в стойку. В мире среднее энергопотребление стойки составляет 6 кВт. Применительно к ЦОД это означает возможность размещения не более 14 серверов. При установке 48-портовых коммутаторов (основного и резервного) на каждом из них окажется 34 неиспользуемых порта. Чтобы их задействовать, потребуются шнуры длиной до 7 м, обеспечивающие соединение с другими стойками. Каждый, кто видел ЦОД, где кабели прокладываются между двумя конечными точками напрямую (по схеме «точка – точка»), знает, что со временем работать в такой среде становится просто невозможно.

Как ни парадоксально, вся эта кабельная паутина, которую данный подход обещает устранить, создается при попытке задействовать неиспользуемые порты. В топологии ToR количество таких портов может быстро увеличиваться. Расходы на приобретение большего, чем необходимо, числа коммутаторов, а также операционные затраты, связанные с энергопотреблением и обслуживанием, намного перевешивают экономию, достигаемую за счет сокращения структурированной кабельной инфраструктуры.

ГИБКОСТЬ, ЗАКЛАДЫВАЕМАЯ ПРИ ПРОЕКТИРОВАНИИ

Сторонники СКС поддерживают различные формы структурированной кабельной проводки по принципу «все со всеми» (Any-to-All, A2A) в соответствии со стандартами ЦОД. Принцип A2A довольно прост: в каждой стойке устанавливаются медные и оптические соединительные панели, которые соответствуют коммутационным панелям в центральной зоне коммутации. Все оптическое волокно подводится к одной секции стойки в той же центральной зоне коммутации. Такой подход обеспечивает большую гибкость, позволяя любое оборудование подключать к другому при помощи медного или оптического соединительного шнура. Фиксированная часть канала остается неизменной. Размещение кабельных каналов и выделение пространства для кабелей планируются заранее. Хотя при начальной инсталляции такой метод предусматривает приобретение большего количества кабелей, на протяжении жизненного цикла ЦОД он дает значительные преимущества. Эти каналы пассивны и не требуют затрат на обслуживание. При правильном планировании, СКС будет работать как минимум 10 лет, поддерживая два-три поколения активной электроники.

ПОКАЗАТЕЛЬНЫЙ ПРИМЕР

Структурированные кабельные системы и централизация коммутаторов помогают добиться значительного сокращения затрат на оборудование, которое не может быть полностью задействовано. В одном из недавних сравнений коммутаторы ToR, установленные в ЦОД на 720 стоек, стоили более 33 млн долларов. Установка кабельной системы с поддержкой 10GBaseT при той же функциональности позволила увеличить протяженность каналов и повысить коэффициент использования оборудования. При этом затраты составили примерно 5,2 млн долларов. В обоих случаях ПО не учитывалось. Кабельная система для 10GBaseT обошлась примерно в 2,5 млн долларов, но с учетом экономии в 25 млн долларов она себя более чем оправдала. Поскольку она проектировалась заранее, кабельные каналы и пространство выглядят аккуратно, упорядоченно и нестандартные соединения «точка – точка» не используются. Количество незадействованных портов удалось значительно уменьшить: вместо 13 000 их осталось всего 616.

СБАЛАНСИРОВАННАЯ КАРТИНА

Чтобы добиться сбалансированной картины и получить целостное представление о ЦОД, лучше всего охватить взглядом всю экосистему. Это поможет правильно оценить доступные проектные варианты, рекомендуемые отраслевыми стандартами. Каждый отдельный элемент влияет на другой, поэтому важно рассчитывать общую эффективность и возврат инвестиций, чтобы исключить ошибки и избежать решений, которые хороши в краткосрочном плане, но стратегически оказываются негибкими и дорогостоящими.

В конечном счете экосистема ЦОД хороша как сумма составляющих, поэтому следует отдавать предпочтение целостному подходу к ее реализации.

Кэрри Хигби — глобальный директор компании Siemon по решениям и сервисам для ЦОД.