Еще пару лет назад только ведущие специалисты отваживались произносить неожиданное словосочетание — cloud computing, но вскоре все изменилось, и уже в октябре 2008 года облачные вычисления стали главной темой номера отнюдь не компьютерного, а старейшего бизнес-издания – британского журнала The Economist. В основной статье номера Let it rise («Дайте ему взойти») можно найти такие слова: «Восход облачного компьютинга не просто какой-то очередной всплеск технической мысли, способный привести в восторг энтузиастов технологий. Можно с полной уверенностью сказать, что через некоторое время компьютерные облака не только трансформируют саму информационную индустрию, но и приведут к сдвигу парадигмы за рамки собственно ИТ, вызвав глубинные изменения в организационных принципах работы компаний и их отдельных сотрудников». В качестве одного из аргументов в пользу облаков приводится мнение Ирвинга Владавски-Бергера, известного тем, что его устами оглашаются самые смелые футурологические прогнозы IBM. Так вот, он утверждает, что переход в облака в истории ИТ сыграет примерно ту же роль, которую в естественной истории сыграл Кембрийский взрыв, случившийся 500 млн лет назад. Разумеется, природа сложнее, чем искусственные системы, и своим сравнением Владавски-Бергер стремился обратить внимание всего на одну общность – после взрыва в обоих случаях начинается активное формирование сложных многоклеточных организмов, если согласиться с тем, что

Еще пару лет назад только ведущие специалисты отваживались произносить неожиданное словосочетание — cloud computing, но вскоре все изменилось, и уже в октябре 2008 года облачные вычисления стали главной темой номера отнюдь не компьютерного, а старейшего бизнес-издания – британского журнала The Economist. В основной статье номера Let it rise («Дайте ему взойти») можно найти такие слова: «Восход облачного компьютинга не просто какой-то очередной всплеск технической мысли, способный привести в восторг энтузиастов технологий. Можно с полной уверенностью сказать, что через некоторое время компьютерные облака не только трансформируют саму информационную индустрию, но и приведут к сдвигу парадигмы за рамки собственно ИТ, вызвав глубинные изменения в организационных принципах работы компаний и их отдельных сотрудников». В качестве одного из аргументов в пользу облаков приводится мнение Ирвинга Владавски-Бергера, известного тем, что его устами оглашаются самые смелые футурологические прогнозы IBM. Так вот, он утверждает, что переход в облака в истории ИТ сыграет примерно ту же роль, которую в естественной истории сыграл Кембрийский взрыв, случившийся 500 млн лет назад. Разумеется, природа сложнее, чем искусственные системы, и своим сравнением Владавски-Бергер стремился обратить внимание всего на одну общность – после взрыва в обоих случаях начинается активное формирование сложных многоклеточных организмов, если согласиться с тем, что

в компьютерный «докембрийский» период компьютеры оставались, по существу, одноклеточными, а облака можно уподобить многоклеточным.

Кембрийский взрыв в компьютерном исполнении

Момент компьютерного Кембрийского взрыва совпал с появлением серверов-лезвий, и сам этот взрыв стал возможен, поскольку лезвие оказалось той достаточно развитой формой клетки, из которой можно создать многоклеточный организм.

Действительно, эволюция компьютеров идет по пути укрупнения и усложнения их конструктивных компонентов – на каждом историческом этапе «кирпичик» компьютерного мироздания определяет все остальное. Сначала кирпичом были лампы, затем транзисторы, потом интегральные микросхемы, а в начале 70-х появились микропроцессоры, содержащие законченные центральные процессоры. Из навесных элементов ничего, кроме мэйнфреймов, собрать было нельзя, но подобных компьютеров не могло быть много, поэтому и стоили они чрезвычайно дорого. С появлением микросхем впервые открылась возможность для демократизации компьютерных систем – мини-ЭВМ оказались на порядок дешевле, что обеспечило их большую массовость, а далее под влиянием удешевления микропроцессоров не оставалось ничего иного, как придумать персональные компьютеры, и вместе ними начался переход на распределенную модель организации компьютерных систем, доминирующую на протяжении последних лет.

Надо заметить, что пока речь шла об эволюции в рамках одноклеточной модели, но жизнь не стоит на месте, и очередной шаг по укрупнению строительных блоков компьютерных систем был сделан в первые годы текущего десятилетия, когда появились лезвия. Странно, но в первый момент почти никто не осознал их особой роли в эволюционном процессе, однако лезвия не просто новый конструктив – они создали условия для перехода компьютинга в новое качество. Для того чтобы собрать многоклеточный организм, отдельная «клетка» должна быть достаточно сложной, способной к автономному существованию, однако микропроцессор не способен на это, а сервер-лезвие способен, что позволяет преодолеть порог сложности на пути создания сложных многоклеточных облаков. Пусть сегодня они изготавливаются по одной технологии, а через некоторое время технология может стать другой, но суть от этого не меняется, важно то, что порог сложности преодолен – появилась возможность создавать новые компьютеры из компьютеров. Показательно, что на представлении семейства продуктов Open Network Systems в компании Sun Microsystems отметили, что термин «компьютер» устарел и его может заменить «система, состоящая из компьютеров».

Для обозначения компьютера, собранного из компьютеров, стали использовать слово «облако». Сначала выдвигалась утопическая идея, будто весь мир будет накрыт несколькими гигантскими облаками, как тут было не вспомнить высказывание Томаса Ватсона, легендарного председателя совета директоров корпорации IBM, сделанное в 40-е годы, относительно того, что на весь мир хватит дюжины компьютеров. Но очень скоро стало ясно, что малым числом облаков не обойтись и облака могут быть разными по своим размерам.

Исторические последствия

За сменой технологической парадигмы следует еще одна. С середины сороковых годов и до середины первого десятилетия XXI века внимание было сосредоточено на программном и аппаратном обеспечении, позволяющем получать желаемые результаты, то есть в большей мере на инструментах, а не на том, для чего они предназначены. Скажем, если сравнивать с музыкой, то больше внимания уделялось тому, на чем ее исполнять, как записывать мелодии, на чем хранить записи, а не музыке как таковой. Изменения, связанные с распространением сервисной модели от первых скромных шагов SOA до EaaS (Everything as a Service), привели к тому, что теперь важны потребительские качества сервисов, а не то, где и как они выполняются.

На первое место сегодня вышли вопросы экономичности, безопасности и надежности сервисов, а их решение ищется в централизации компьютинга, сначала на базе все более виртуализированных ЦОД, а затем в облачном компьютинге в его разных формах. Из централизации непосредственным образом вытекает виртуализация клиентских рабочих мест, то есть абстрагирование собственно рабочего места от прибора, на котором оно реализовано, и трансформация приложений в виртуальные устройства (virtual appliance), способные доставлять приложения и инфраструктурное ПО к местам их использования. Эти явления не существуют сами по себе, а взаимодополняют друг друга (рис. 1). По определению экономиста Пола Рамера, совместно они образуют «одновременное совершенствование дополнительных благ», так он назвал компоненты, суммарный эффект работы которых выше, чем каждого по отдельности.

Таким образом завершился виток эволюционной спирали, начавшийся с централизованной модели вычислений и ею же завершившийся: централизованная модель с мэйнфреймами и тупыми зелеными терминалами, мини-ЭВМ, распределенная модель и снова центры обработки данных. Однако централизованная модель с тонкими клиентами не исчезала вообще, она продолжала существовать, хотя и в ограниченных масштабах, и вот сейчас происходит возврат к ней, но на принципиально ином уровне – вычисления и хранение данных уходят в облака, а в руках пользователя остаются виртуальные устройства доступа. Как именно будет выглядеть новый централизованный компьютерный мир, пока сказать сложно, но уже сейчас ясно, что картина будет совершенно иной – материальные формы компьютинга будут глубоко скрыты и станут невидимы для пользователя, а на поверхности останутся только сервисы. Обидно, но, по всей видимости, в будущем пополнять экспозиции музеев больше станет нечем, маловероятно, что однообразные стойки, набитые однообразным оборудованием, смогут вызвать интерес у посетителей. Но на все нужно время, известно, что период от зарождения новой компьютерной технологии до ее серьезного выхода на рынок занимает лет восемь-десять, сейчас прошел примерно такой срок, и наметившиеся изменения принимают массовый характер.

Приватизация облаков

Как бы ни ругали централизованную модель, особенно лет десять-пятнадцать назад, когда ее противники предрекали смерть мэйнфреймам, она не исчезала и продолжила свое нишевое существование, поскольку обладает рядом превосходных качеств. Обеспечивая более эффективное, чем децентрализованная, использование ресурсов, высокую степень безопасности и надежности, удобство с точки зрения управления, в итоге она является носителем еще одного свойства, которому можно дать название «доверительность» (trust), поэтому не случайно, что самые ответственные приложения по-прежнему реализуют на мэйнфреймах. Осознание преимуществ централизованной модели подтолкнуло к идее создания центров обработки данных, и поначалу все казалось замечательно и весьма просто – есть дешевые серверы, есть сети, достаточно собрать все вместе под одной крышей. Но тривиальная сборка ЦОД из стандартных серверов отличается чрезвычайно низкой экономической и энергетической эффективностью, особенно если принять во внимание паровозный коэффициент полезного действия серверов на платформе х86. Оказалось, что такими ЦОД, иногда их еще называют серверными фермами, «в лоб» заменить мэйнфреймы невозможно.

Выход был найден в создании масштабируемых облачных инфраструктур. Облако, в отличие от ЦОД, мэйнфреймов или мощных Unix-серверов (их еще называли мидфреймами) со встроенными – как аппаратными, так и программными – механизмами виртуализации, является динамической структурой. Все ресурсы облака могут использоваться с большей эффективностью, здесь не требуется заранее для каждого приложения резервировать серверную нагрузку, область хранения и пропускную способность сети – они могут быть выделены «по требованию», а приложение может использовать ровно столько, сколько ему нужно, из общего пула ресурсов. Совершенно естественно желание совместить преимущества централизованной модели с достоинствами облака, собрать вместе доверительность и эффективность использования ресурсов. Возможности для такого объединения есть и обеспечиваются двумя группами технологий: виртуализации и интеграции информации; совмещая их, можно в произвольных масштабах обеспечить динамическое управление ресурсами (Dynamic Resource Scheduling, DRS).

Результатом конвергенции всех облачных новаций может стать корпоративная информационная система, построенная как частное облако (private cloud). В такой системе сочетаются преимущества централизованной модели и облака. Виртуальные устройства, в зависимости от необходимости, могут находиться во внешнем или во внутреннем облаке, а место выполнения приложения диктуется наличием ресурсов и требованиями безопасности. Избранное для работы устройство доступа тоже не имеет значения, это может быть тонкий или толстый клиент, мобильное устройство или настольный компьютера – критична лишь возможность подключения

к частному облаку.1

Внутреннее облако есть не что иное, как корпоративная информационная система, построенная на базе динамического ЦОД, которая, кроме использования собственных ресурсов, может заимствовать их из внешнего облака, создавая частное облако. Внутреннее облако можно рассматривать как апофеоз виртуализации, оно позволяет собрать в единый пул разнородные информационные ресурсы предприятия, чтобы потом распределять их «на ходу», по мере возникновения потребностей, что в конечном итоге приводит к более разумному использованию ресурсов и повышению экономической эффективности. Внутренние облака, скорее всего, будут создаваться крупными предприятиями, они будут ровно того размера, какой на самом деле нужен предприятию, если же этих ресурсов окажется недостаточно, то всегда будет возможность «взять в кредит» у провайдера внешнего облака. Что же касается мелких предприятий, то они, вероятно, откажутся от собственных ИТ-подразделений и целиком «уйдут в облака».

Операционная система для облаков

Осенью прошлого года, после сенсационного увольнения генерального директора VMware Дайаны Грин, многие задавались вопросом, чем удивит компания после ее ухода. Новое руководство не заставило себя ждать и в качестве следующей цели назвало операционную систему, способную виртуализировать серверы и системы хранения всего ЦОД в целом. Тогда впервые появилось название Virtual Datacenter Operating System (VDC-OS), эта система не предполагалась в качестве замены традиционным операционным системам – ее функция должна была быть аналогичной, но в масштабах всего центра обработки данных. VDC-OS призвана оперировать всем ЦОД как единым пулом оборудования, динамически распределяя его ресурсы и обеспечивая бесперебойность работы. В апреле 2009 года вышла vSphere4 с уточнением, что – это операционная система для облаков. О значимости этого шага для отрасли можно судить хотя бы по тому, что на мероприятии VMware, посвященном объявлению vSphere 4, присутствовали Джон Чемберс, генеральный директор и президент Cisco, технический руководитель Intel Патрик Гелсингер, вице-президент по стандартным серверам HP Джеймс Моутон и генеральный директор Dell Майкл Делл. Если принять во внимание, насколько трудно представить такой синклит на одной сцене, значит, событие и в самом деле сверхординарное.

Понять интерес отрасли к vSphere несложно, помимо общих слов имеется грубая реальность – виртуализация серверов может поднять их КПД в несколько раз, но если учесть, что исходная цифра 5%, то это совсем немного. Требуется дальнейший рост, но если оставаться в рамках одного сервера, он невозможен, следовательно, нужно сливать вместе ресурсы всего серверного пула. Только так можно справиться с врожденными дефектами архитектуры х86. Предлагая vSphere 4, в VMware надеются, что с помощью этой системы ИТ-подразделениям удастся создавать самоуправляемые безотказные и самообслуживаемые внутренние облака, как у Amazon или Google, но существующие внутри периметра, охраняемого межсетевыми экранами. В последующем VMware обещает выпустить апгрейды, позволяющие использовать ресурсы и сервисы, предоставляемые из внешних облаков провайдерами этих услуг.

Со структурной точки зрения вместе с vSphere 4 вводится еще один дополнительный уровень между приложениями и железом, своего рода подложка для виртуальных машин. Ядром vSphere остается старый гипервизор VMware ESX, адаптированный для 64-разрядных процессоров. Он приспособлен к работе с процессором Intel Xeon 5500, используя его встроенные возможности для виртуализации и расширенный доступ к памяти. Вполне очевидно, что работа в облаке потребовала расширения функции Virtual SMP, и теперь виртуальная машина может поддерживать до восьми виртуальных процессоров, причем виртуальные процессоры могут работатьна том же самом физическом процессоре, что и виртуальная машина, а в случае нехватки ресурсов – на других процессорах. Наличие этой функции повышает эффективность использования процессорного пула. Увеличены и количественные параметры, память виртуальной машины выросла до 256 Гбайт, число виртуальных сетевых контроллеров возросло с четырех до десяти, соответственно полоса пропускания увеличилась до 30 Гбит/с, а количество операций ввода/вывода в секунду превышает 300 тыс. Благодаря этим возможностям VMware vSphere 4 может агрегировать существенно большее количество виртуальных машин и физических инфраструктурных ресурсов, образуя огромный логический пул ресурсов, необходимый для создания облака. Это пул можно охарактеризовать следующими количественными параметрами: 32 физических сервера с 2048 ядрами, на которых может работать 1280 виртуальных машин, использующих 32 Тбайт оперативной памяти, 16 Пбайт памяти на системах хранения и 8000 сетевых портов. Анонсируя vSphere 4, VMware демонстрирует, что стремится навести мосты между традиционными и виртуальными ЦОД, а также облаками. Компания утверждает, что возможностей vSphere 4 достаточно для того, чтобы трансформировать существующие и будущие инфраструктуры во внутренние облака, объединить их в частные облака и обеспечить федеративный союз с внешними облаками.

С организационной точки зрения VSphere позволит разрешить одну из важнейших проблем ИТ – оценки их экономической эффективности, а это позволит превратить в реальность деятельность по предоставлению «услуг, оплачиваемых по мере потребления» (pay-as-you-go service) через Web-портал. В целом компания видит свою роль в предоставлении пользователю возможностей для создания внутренних облаков.

Пока у vSphere в облачной области конкурентов не много, и ни один из них не обладает сравнимой полнотой. Microsoft намеревается к концу 2009 года предложить облачную инфраструктуру Windows Azure, которая изначально называлась Windows Cloud, но функционально это совсем иное, не уровень или подложка в понимании VMware. Скорее, Azure можно рассматривать как платформу для разработки Web-приложений, исполняемых во внешнем облаке типа Amazon EC2. С ее появлением разработчик остается с привычными ему средствами, например Visual Studio, добавив к традиционному приложению для десктопа качества, необходимые для работы в облаке. Операционную систему Solaris иногда рассматривают как облачную, поскольку в ней есть гипервизор xVM Server, технологии Solaris Containers и Zones, файловая система ZFS, но это утверждение выглядит не слишком убедительно. Что же касается gOS Linux от компании Good OS, которая назвала свой продукт просто – cloud operating system, то в данном случае имеет место терминологическое совпадение. Эта операционная система предназначена для установки на нетбуки, имеет ограниченную функциональность и служит для доступа во внешнее облако, а не для создания внутренних облаков.

Идеальное облако и реальные прототипы

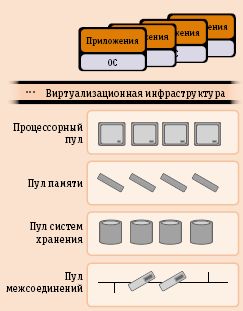

Идеальное внутреннее облако (рис. 2) состоит из четырех пулов виртуализованных ресурсов: процессоров, памяти, систем хранения и интерконнекта. На таком облаке могут выполняться любые приложения, оно поддерживает доступ к ним с использованием произвольных типов терминалов: толстых и тонких, стационарных и мобильных.

Для того чтобы сложилось нечто подобное этому облаку, потребуется немало времени, в первую очередь предстоят большие работы по стандартизации, а пока даже на серверы-лезвия нет каких-либо общих стандартов и невозможно совместить в одном шасси или в одной стойке изделия от разных производителей, что явно противоречит идее создания облаков как универсальных сред.

Самое упорное сопротивление стандартизация в сфере лезвий испытывает со стороны наиболее крупных производителей, HP и IBM. Несколько лет назад IBM все же пыталась предложить собственную спецификацию в качестве стандарта, но серьезной поддержки эта инициатива не получила. В 2009 году свои намерения относительно стандартизации лезвий выражают участники организации Server Systems Infrastructure Forum, но среди них нет основных игроков серверного рныка – HP, IBM, Dell и Sun Microsystems; новое движение возглавляют American Megatrends, Samsung и Supermicro. Они считают возможным создать такие условия, когда каждый сможет собирать необходимые конфигурации из покупных лезвий, корзин, мезонинных карт, коммутаторов и компонентов ввода/вывода. Складывающаяся ситуация очень напоминает события начала восьмидесятых, когда массовое производство персональных компьютеров началось с отрытого стандарта IBM PC. Повторение неизбежно, но пока быстрорастущий рынок серверов-лезвий (33% в год) контролируется пятью компаниями – HP, IBM, Sun, Dell и Fujitsu, ситуация сохранится.

Еще одной особенностью, определяющей движение к облакам, является исключительное положение архитектуры x86. Она далеко не оптимальна, даже если принять во внимание все внесенные в нее усовершенствования, но огромное количество готовых под нее приложений, а также многочисленные рыночные аргументы делают ее единственно возможной при создании массивных вычислительных инфраструктур.

Egenera, Dell и Fujitsu

Компания Egenera формально не входит в число лидирующих производителей лезвий, но по своему технологическому статусу она была и остается признанным авторитетом. Egenera вышла на рынок лезвий второй, непосредственно после RLX Technologies, создавшей в свое время лезвия как класс серверов. Впоследствии HP купила RLX, что оказалось предпосылкой для нынешнего лидирующего положения HP, а Egenera продолжает независимое существование. В отличие от RLX, сосредоточенной непосредственно на вычислительных возможностях серверов-лезвий, во главу угла производственной программы Egenera были положены более крупные структуры, эта программа сохранилась до настоящего времени.

В сентябре 2001 года Egenera представила абсолютно оригинальную, не похожую ни на что компьютерную систему BladeFrame, представляющую собой пул из 96 процессоров со свободным сетевым соединением. В ней можно было обнаружить схожесть с архитектурой NUMA и с менее популярной SAN (System Area Network), но от них система BladeFrame отличалась применением стандартных узлов, в качестве которых использовались двух- или четырехпроцессорные ультратонкие и, что очень существенно, бездисковые серверы. Отсутствие дисков в сочетании с развитой системой управления обеспечивало BladeFrame те качества, которые сегодня дают технологии виртуализации.

В самой первой стойке BladeFrame могло быть смонтировано до 24 двух- или четырехпроцессорных лезвий. Для их объединения в единую систему было разработано оригинальное техническое решение, получившее название PAN (Processing Area Network), в состав которого входят интегрированные коммутаторы, контроллеры и шины для объединения в кластеры. PAN Manager позволяет управлять системой из одной точки, а SAN и PAN, собранные в одной стойке, могут образовать готовую инфраструктуру предприятия или провайдеров различных информационных услуг, в том числе услуг независимого хранения данных.

Сегодня Egenera выпускает два основных продукта – BladeFrame EX и BladeFrame ES, различающиеся между собой размерами. В них устанавливаются двух- или четырехпроцессорные вычислительные лезвия Processing Blade на архитектуре x86 от AMD или Intel. От своих предшественников Processing Blade унаследовали главные черты, прежде всего отсутствие дисков. Для управления в EX и ES устанавливают по два управляющих модуля – соответственно Control Blade EX и Switch Blade EX, которые различаются количеством портов Gigabit Ethernet. Системой управляет PAN Manager, который реализует «виртуализацию без виртуализации», то есть преобразует фиксированную физическую серверную инфраструктуру в пул гибко распределяемых ресурсов. В Egenera эту процедуру называют «оркестровкой инфраструктуры» (Infrastructure Orchestration).

Для региона EMEA, к которому относится Россия, продукция Egenera выпускается под торговой маркой Fujitsu Technology Solutions и известна как Primergy BladeFrame. Изделия Primergy BladeFrame BF200 и BF400 идентичны и взаимозаменяемы с Egenera BladeFrame ES и EX. Вторым лицензиатом является Dell PAN System, представляющий собой предварительно сконфигурированный набор серверов Dell с предустановленной системой управления PAN Manager.

Cisco

Не удивительно, что комплексная вычислительная система от Ciscо, предназначенная для динамического ЦОД, – Unified Computing System – интересна не собственно лезвиями, а тем, как они коммутируются, точнее сочетанием коммутирующей инфраструктуры с виртуальным распределенным коммутатором.

Система Cisco UCS собирается из набора, состоящего из пяти основных компонентов. Ее логическим центром служит устройство Cisco UCS 6100 Series Fabric Interconnects, которое осуществляет физическую коммутацию 10 Gigabit Ethernet и FcoE (Fibre Channel over Ethernet). Функции коммутации могут быть расширены устройством (экстендером) Cisco UCS 2100 Series Fabric Extenders, осуществляющим связь с лезвиями. Сами лезвия Cisco UCS B-Series Blade Servers ничем не отличаются и выпускаются в двух версиях: Cisco UCS B200-M1 Blade Server (до двух процессоров Intel Xeon 5500, до 96 Гбайт памяти DDR3, два диска SAS в разных вариантах с контроллером RAID и одна двухпортовая мезонинная карта) и Cisco UCS B250-M1 Extended Memory Blade Server с увеличенной до 384 Гбайт памятью и двумя мезонинными картами, повышающими скорость обмена с лезвием до 40 Гбит/с. Как и в большинстве подобных конструкций, лезвия устанавливаются в корзину-шасси Cisco UCS 5100 Series Blade Server Chassis, вмещающую до восьми лезвий плюс к ним два экстендера. В мезонины лезвий могут устанавливаться сетевые адаптеры разных типов. Эти небольшие устройства дают возможность приспособить лезвия к разным типам нагрузок, к работе в виртуальной среде, обеспечить их лучшую «подгонку» к сетевой среде, позволяют добиться более высокой производительности. (рис. 3)

Изюминка UCS – не в этом железе, а в виртуализации сетевых функций, обеспечиваемых сочетанием возможностей VMware vNetwork Distributed Switch и Cisco Nexus 1000V Series Switch. Хотя в обоих названиях используется термин «коммутатор», оба решения являются программными продуктами. Как же могут быть коммутаторы программными и к тому же распределенными? Появление гипервизора VMware ESX вызвало к жизни необходимость коммутировать виртуальные машины, и до последнего времени эти действия выполнялись вручную. В 2009 году в VMware vNetwork появились автоматизирующие эти функции виртуальные коммутаторы – стандартный VMware vNetwork Standard Switch и распределенный VMware vNetwork Distributed Switch. Первый действует в пределах одного физического сервера, второй позволяет распространить настройку коммутации виртуальных машин на более чем один физический сервер. Коммутатор Cisco Nexus 1000V позволяет сделать следующий шаг.

Sun Microsystems

Премьера модульного семейства Open Network Systems состоялась в апреле 2009 года, причем его представляли Энди Бехтольсхайм (один из основателей Sun, еще студентом разработавший рабочую станцию Sun 1, а ныне руководящий разработкой серверов стандартной архитектуры), разработчик файловой системы ZFS Джефф Бонвик и главный специалист по флэш-накопителям Майкл Корнуэлл. Из того, что они говорили, совершенно очевидно, что семейство Open Network Systems главным образом нацелено на высокопроизводительные вычисления. Sun не первой начала поставлять лезвия на процессорах Intel Xeon 5500, но ей первой удалось сделать несколько вещей. Прежде всего, упаковать 96 двухсокетных узлов в стандартную стойку высотой 24 дюйма, затем связать эти узлы межсоединением QDR InfiniBand, обеспечивающим скорость передачи 40 Гбит/с, и, наконец, установить в лезвиях ускорители на твердотельных накопителях, где одна плата обеспечивает скорость обмена, равную той, что дают 100 дисков, работающих параллельно. Очевидно, что все перечисленное будет использовано при сборке новой версии суперкомпьютера Sun Constellation System.

Однако потенциал Open Network Systems не сводится лишь к высокопроизводительным вычислениям. Начнем с того, что у Sun существует не один, как у большинства,

а два основных конструктива.

Традиционную корзину Sun Blade 6000 дополняют стойки Sun Blade 6048, в них могут собираться системы для HPC, но они же могут использоваться для консолидации и виртуализации серверов, для работы с СУБД и корпоративными приложениями, а также для поддержки инфраструктур Web. В стойке появилась новая система охлаждения с активной дверью Sun Cooling Door Systems, предназначенная для Sun Blade 6048, она способна отбирать до 35 кВт тепла, причем непосредственно из наиболее горячих зон, что особенно критично для систем HPC.

Второй конструктив – собственные коммутаторы. Еще недавно при анализе продуктовой линейки Sun удивляло то, что в ней давно были вычислительные лезвия, в прошлом году к ним появились лезвия для хранения данных Sun Blade 6000 Disk Module, но до сих пор не было того, что объединяет отдельные лезвия в единую инфраструктуру, в то, что называют динамическим ЦОД. Наконец недостающие части появились – коммутаторы Sun Blade 6000 Virtualized NEM и Sun Blade 6048 QDR InfiniBand NEM. Аббревиатура NEM расшифровывается как Network Express Module, а цифры в названии указывают, какому именно конструктиву они предназначены. Младшая модель, Sun Blade 6000 Virtualized NEM, более традиционна, она служит для объединения лезвий в пределах корзины посредством 10Gt Ethernet,

а старшая – реальный шаг вперед. Три буквы QDR в ее названии означают Quad Data Rate InfiniBand, то есть передача данных по интерфейсу InfiniBand с учетверенной скоростью. Появление этого коммутатора есть плод многолетнего сотрудничества с израильской компанией Mellanox. В устройстве сочетаются 30 портов 4xQDR, обеспечивающих передачу со скоростью 40 Гбит/с, и 24 порта Gigabit Ethernet.

Еще две новинки – серверы-лезвия Sun Blade X6270 и Sun Blade X6275, построенные на процессорах Quad-Core Intel Xeon, но X6270 ориентирован на корпоративные приложения и на задачи виртуализации и консолидации, поэтому у него большой запас по памяти (18 слотов DIMM, до 144 Гбайт) и четыре диска с горячей заменой, а X6275 специально спроектирован для работы в составе высокопроизводительных HPC-кластеров. Он состоит из двух независимых узлов и имеет интегрированный контроллер QDR InfiniBand, который в сочетании с технологией Intel QuickPath обеспечивает высокую скорость передачи данных и низкую задержку. Качественная новизна X6275 состоит в поддержке твердотельных дисков SSD, которые смогут использовать преимущества пропускной способности QDR InfiniBand. Модуль размером со спичечную коробку и толщиной несколько миллиметров, вставляемый в материнскую плату, хранит 24 Гбайт данных, используя кэш 64 Мбайт. Скорость работы таких дисков в 50-70 раз выше, чем механических, и это обстоятельство радикально изменяет подходы к проектированию. На представлении Open Network Systems Бехтольсхайм отметил, что

X6275 – только первый шаг по части освоения возможностей SSD.

Hewlett-Packard

В конце апреля 2009 года было представлено решение HP BladeSystem Matrix, из названия которого следует, что в нем вся ИТ-система собирается в матрицу, состоящую из лезвий. В отличие от Sun здесь делался упор на экономические преимущества модульных систем и на то, что они являются плодом развития фирменной идеологии, называемой адаптивной инфраструктурой (Adaptive Infrastructure). Главный козырь BladeSystem Matrix – качество интеграции. Здесь все собрано в единое целое: программное обеспечение, серверы, системы хранения, сетевое оборудование. В багаже компании не просто набор необходимых строительных блоков, но еще и система управления HP Matrix Orchestration Environment, обеспечивающая универсальный интерфейс ко всем процедурам проектирования, внедрения и последующей оптимизации среды выполнения приложений. Опираясь на HP MOE, пользователь сможет собрать до тысячи физических или виртуальных серверов

в единую адаптивную инфраструктуру.

Базовый конструктивный элемент – «корзина» BladeSystem c7000, обеспечивающая питание, охлаждение, инфраструктуру ввода/вывода и межсоединение для установки 16 обычных серверных лезвий или специализированных лезвий-накопителей. Сейчас «матрица» комплектуется серверами HP ProLiant G6 на четырехъядерных процессорах Intel Xeon 5500 или AMD Opteron (Shanghai). В перспективе можно будет использовать лезвия на Itanium, в том числе на будущих двухъядерных Itanium 9100. По способности к горизонтальному масштабированию Matrix заметно превосходит Cisco UCS, использование в последней коммутационной структуры с 40 портами ограничивает общее число серверов до 320 против 1000 в BladeSystem Matrix. Для коммутации используются модули, поддерживающие соединения 10 Gigabit Ethernet и Fibre Channel с пропускной способностью 8 Гбит/c; допускается использование высоконадежной системы коммутации HP NonStop и нескольких вариантов системы питания – однофазной, трехфазной и постоянного тока.

Вторая составляющая BladeSystem Matrix – интегрированный центр управления HP Insight Dynamics – Virtual Server Environment, предназначение которого в непрерывном анализе и оптимизации состояния всей адаптивной инфраструктуры. Именно благодаря наличию этого интеллектуального центра BladeSystem Matrix приобретает качества, которые позволяют назвать эту структуру «облаком в миниатюре».

emc

Накопитель старшего уровня V-Max (Virtual Matrix Architecture), как следует из названия, построен с использованием виртуальной матричной архитектуры. При его объявлении было указано на то, что этот массив предназначен для частных или корпоративных облачных инфраструктур. Он назван виртуальным, поскольку предполагается возможность построения мощных и даже сверхмощных систем хранения из относительно простых модулей.

Основным компонентом для сборки виртуальной модели Symmetrix V-Max является модуль V-Max Engine, представляющий собой управляющий узел, построенный на четырех процессорах Intel Xeon Quad-core, объем оперативной памяти одного V-Max Engine составляет 128 Гбайт, в нем установлены две группы интерфейсов по 16 каналов для подключения дисков и хостов. Скорость обмена данными с периферией равна 24 Гбайт/с. Кроме всего прочего, «на борту» имеется специализированная микросхема для управления доступом к памяти и интерконнектом RapidIO.

Механизм виртуализации позволяет объединить до восьми модулей V-Max Engine в единый системный образ, в котором все характеристики суммируются, а это значит, что размер общей памяти становится равным 1 Тбайт, а виртуальная скорость обмена достигнет 192 Гбайт/с. Количественный рост обеспечивает качественное повышение показателей. Общее число портов для подключения дисков в таком случае составит 128, к ним можно подключаться практически по любым протоколам – Fibre Channel, FICON и iSCSI. Емкость дисков может варьироваться от 146 Гбайт до 1 Тбайт, а флэш-накопителей – от 200 до 400 Гбайт. В максимальной конфигурации система будет состоять из одной управляющей стойки и восьми стоек

с накопителями.

Если говорить об объемах хранения, то в системе может быть установлено от 96 до 2400 дисков. В зависимости от типов дисков и RAID полезный объем хранения колеблется от 6 до 2026 Тбайт. Существенно то, что можно сочетать диски разных типов, а значит, оптимизировать состав в зависимости от решаемой задачи, подбирая соответственно флэш-диски – быстрые, но малые по объему или же большие, но более медленные. Для распределения данных по уровням в Symmetrix V-Max имеется средство FAST (Fully Automated Storage Tiering), оно поддерживает эту функцию автоматически

в непрерывном режиме.

Главное преимущество виртуализованной системы хранения – в неограниченном масштабировании, оно может быть вертикальным (scale in) и горизонтальным (scale out). Массив Symmetrix V-Max может расти в процессе своего жизненного цикла, может увеличиваться за счет наращивания числа стоек, а по мере появления более производительных V-Max Engine – к тому же за счет замены старых на новые. Вовсе не обязательно, чтобы все строительные блоки были одинаковыми, на то она и виртуализация. Таким образом создается эволюционирующая среда, не вызывающая перерывов в обслуживании.

С технической точки зрения виртуализация V-Max Engine стала возможной во многом благодаря тому, что для обеспечения соединений между модулями и для прямого доступа в память использована коммутационная инфраструктура со стеком протоколов RapidIO. Этот относительно малоизвестный альтернативный протокол изначально был предложен для встроенных систем, но неожиданно, как иногда бывает, стал осваивать ту площадку, где сейчас господствует InfiniBand. Обеспечивающий обмен данными на скоростях до 60 Гбайт/с, протокол RapidIO, разработанный специалистами компаний Mercury Computer Systems и Motorola, построен на принципах коммутации пакетов и существует в последовательной и параллельной версиях. RapidIO позволяет разносить узлы на расстояние в несколько десятков метров. Помимо скорости, от встроенных систем RapidIO унаследовал естественный для них прямой доступ к памяти, без которого невозможно создать систему, работающую в режиме реального времени. В приложении к управлению системами хранения принципиально важно то, что использование RapidIO открывает возможность для создания архитектуры с когерентным доступом к памяти (coherent-memory architecture). Это, собственно, и дает все те преимущества виртуализации, о которых уже шла речь. Когерентный доступ уравнивает в правах доступа к памяти вызовы от локальных и удаленных процессоров, что в конечном итоге обеспечивает виртуализацию, а по существу, объединение отдельных модулей в единый системный образ. Теоретически количество V-Max Engine может быть существенно больше нынешних восьми (в некоторых источниках называлась цифра 256), что позволит создавать неограниченные по размеру системы хранения, предназначенные не только для крупных облачных ЦОД, но, возможно, и глобального характера.

Почти по Гоголю

Каждая из перечисленных систем имеет свои фамильные черты. Сравнивая продукты от разных производителей с идеальной моделью, нетрудно попасть в положение разборчивой невесты из гоголевской «Женитьбы» – вот если бы взять все лучшее от каждого из них, то получилось бы то, что нужно. Возможно, здесь и скрыт ответ на вопрос о том, почему до сих пор нет стандартов на лезвия, но теперь понятно, что требуются уже не просто стандарты на параметры лезвий, а некоторые иные стандарты, которые позволили бы собирать из лезвий облака. Не здесь ли кроется ответ еще на один напрашивающийся вопрос – почему молчит IBM, не готовит ли она нечто, что окажется ближе других к идеальной модели облаков.

От мануфактур к динамическим ЦОД

Как серверы-лезвия повлияли на глобальные изменения в компьютинге?

http://www.osp.ru/os/2009/02/7314245

Ренессанс виртуализации — вдогонку за паровозом

Эффективность использования серверов на платформе x86 находится в пределах от 5 до 15%, хотя даже паровозы, ставшие символами низкого КПД, в среднем имели коэффициент, равный 8%. Виртуализация позволяет повысить этот показатель в несколько раз и при этом заметно поднять надежность, готовность и масштабируемость.

http://www.osp.ru/os/2007/02/4107980

PAN или пропал

Сложность компьютерных систем, комплексно решающих конкретные задачи, наличие многочисленных взаимосвязей, большое количество лицензий и серверов порождают проблему эффективного управления. Одним из решений стали серверы-лезвия, однако управление большими конфигурациями этих систем, в свою очередь, вызвало немалые трудности и потребовало новых подходов, в частности от компании Egenera.

http://www.osp.ru/os/2006/09/3776443

Рис. 1. Корпоративная информационная система на базе облачной модели