Создание электронного мозга — задача колоссальной сложности, в частности ввиду того, что современная наука имеет слабое представление о том, как это сделать. В самом деле, в свете биологических ограничений по уровню рассеиваемой мощности и объему (примерно 20 Вт, втиснутые в объем коробки для обуви), данная задача выглядит абсолютно недосягаемой для современного уровня развития технологий. Рассмотрим для примера один из ее аспектов — создание электронного эквивалента синапса. Плотность синапсов в коре головного мозга достаточно высока, примерно 1010 синапсов на квадратный сантиметр, они потребляют ничтожную мощность, обладают сложной, нелинейной динамикой и в некоторых случаях способны сохранять записанные в них воспоминания на протяжении многих десятилетий. До недавнего времени эти характеристики делали невыполнимой задачу построения электронной модели мозга, в особенности в полном объеме. Однако сегодня активизировалась работа над мемристорными устройствами, которые могут приблизить инженеров к созданию архитектуры электронного мозга, способного в реальном времени адаптироваться к окружающему миру. Хотя мемристорные устройства в одиночку не решают проблемы мощности и объема, у них есть ряд привлекательных свойств, которые делают их пригодными для реализации синаптической памяти в машинах, обладающих искусственным интеллектом:

- их сопротивление в целом нелинейно и может меняться под воздействием электрического тока;

- мемристоры, размещенные на перекрещивающихся проводниках (crossbar), могут использоваться для формирования плотноупакованной памяти;

- многие мемристорные материалы совместимы с КМОП-технологией.

Последняя характеристика имеет особое значение, поскольку благодаря ей проектировщики могут интегрировать мемристорную плотноупакованную память с обычными электронными схемами, размещая вычислительные и запоминающие устройства в непосредственной близости друг к другу. С уменьшением расстояния значительно снижается рассеиваемая мощность при обмене данными между двумя этими типами компонентов, а пропускная способность канала передачи данных увеличивается.

Чтобы ускорить процесс создания электронного интеллекта, специалисты компании HP и Бостонского университета совместно разрабатывают архитектуру Cog Ex Machina и программную среду Cog — платформу для разработки нейронных моделей. Эта связка представляет собой недорогую, гибкую, цифровую платформу для построения крупномасштабных моделей мозга, способных в режиме реального времени взаимодействовать с искусственной или реальной средой. Данная платформа пока не реализует возможности разумного поведения и не отвечает ограничениям по мощности и объему, свойственным биологическому мозгу, однако она позволяет исследователям быстро и относительно экономично строить модели, а также адаптировать платформу для новых алгоритмов. Кроме того, Cog обеспечивает для исследователей независимость от конкретной аппаратной платформы.

.png) |

| Рис. 1. Общая схема платформы Cog Ex Machina. Аппаратная часть состоит из ускорительных узлов (в качестве которых сейчас применяются графические процессоры, а со временем будут использоваться чипы Dendra), общающихся по фотонной сети. Исследователи строят абстрактные модели мозга на платформе Cog. Модели мозга используют Cog для взаимодействия с реальным миром посредством сенсоров и эффекторных устройств либо с виртуальным миром через анимат — виртуальную реализацию робота |

Аппаратная архитектура

Как показано на рис. 1, аппаратная архитектура Cog Ex Machina основана на многоядерных ускорителях, используемых для обучения и формирования заключений. Поскольку платформа цифровая, риски, связанные с ее производством, малы, и у пользователей есть свобода реализации широкого спектра нейроморфных алгоритмов. Сейчас в качестве ускорителей используются коммерчески доступные графические процессоры, но в дальнейшем планируется заменить их на чипы Dendra, массово-параллельные процессоры с сотнями вычислительных ядер, интегрированных с банками мемристорной памяти. Благодаря использованию Dendra потребляемую мощность и занимаемую схемой площадь можно будет уменьшить на несколько порядков. Каждый ускоритель, будь то графический процессор или чип Dendra, обменивается информацией с другими ускорителями по фотонной сети.

Ускорители оперируют в распределенной программной среде Cog, предоставляющей исследователям набор примитивов для построения массово-параллельных нейроморфных моделей. Для изучения процесса взаимодействия модели с окружающей средой проектировщики могут подключать аниматы, помещенные в виртуальные среды, либо реальных роботов, созданных на основе эффекторных механизмов, камер, тактильных сенсоров, акселерометров и т. д., что позволяет модели взаимодействовать с реальным миром в реальном времени. У роботов может быть множество применений (например, оперативный поиск попавших в ловушку людей, распознавание угрожающих жизни веществ или обнаружение горячих зон еще до входа пожарников в горящее здание), хотя любое устройство с нетривиальным интерфейсом (сотовый телефон, пульт дистанционного управления, автомобиль и т. п.) выиграет от наличия встроенных интеллектуальных способностей.

Мощность

С уменьшением размера элементов КМОП-схем емкостная потеря сигнала в проводниках отбирает все большую часть энергетического «бюджета» микросхем. Эти потери особенно критичны для проектирования когнитивной архитектуры, поскольку «проводка» мозга является пространственной и отличается очень высокой плотностью. Более того, вычисления в мозге происходят в массово-параллельном режиме — непрерывно выполняется считывание и модификация колоссальных объемов памяти, или синапсов. Ввиду этих сложностей и для минимизации потерь сигнала, у проектировщиков не остается другого выбора, кроме как размещать плотноупакованную малоэнергоемкую память в непосредственной близости от вычислительных узлов. Мемристорная память позволяет реализовать эту идею.

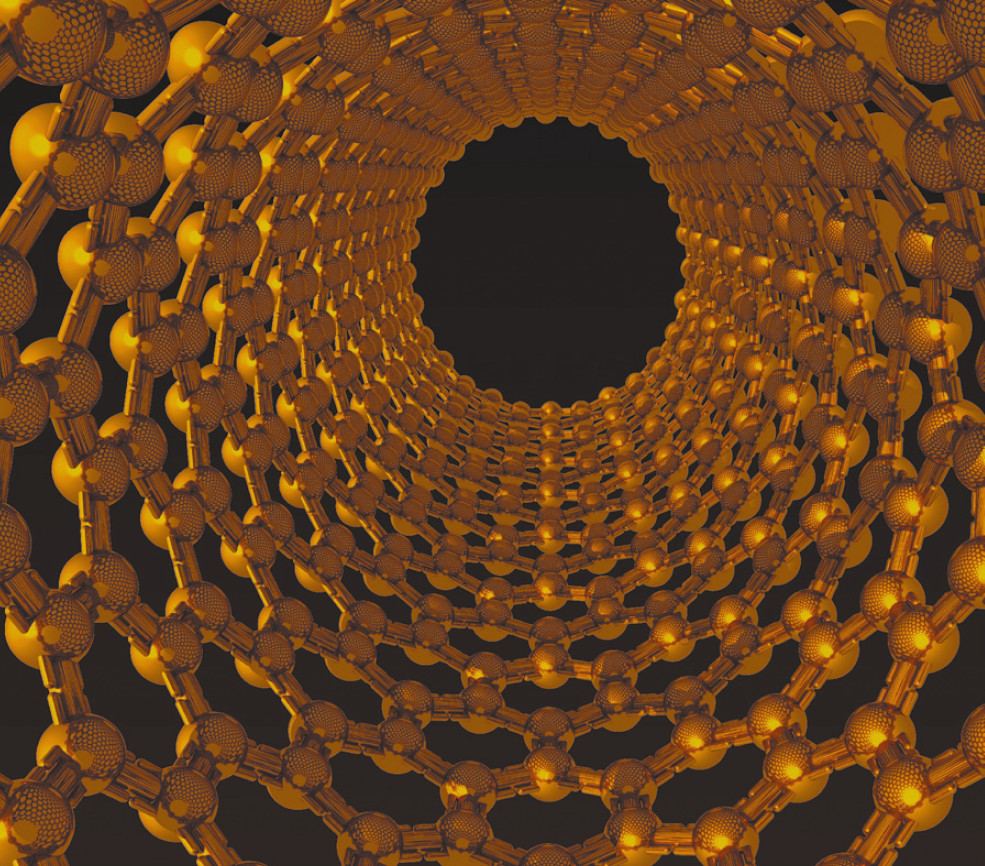

Чип Dendra

Чип Dendra представляет собой решетку трансформирующих узлов, каждый из которых включает в себя простой процессор и обширный банк памяти, построенный из десятков мемристоров на перекрестных проводниках. Трансформирующие узлы обмениваются данными через оболочку самого чипа, а также по сети, их соединяющей. Каждый трансформирующий узел, как правило, считывает и изменяет весь свой банк памяти каждые 10 мс, поэтому соединительные провода должны быть как можно более короткими в целях минимизации потребления мощности.

Программная архитектура

.png) |

| Рис. 2. Построение модели мозга с помощью Cog. Модели представляют собой ориентированные графы адаптивных трансформаций, исполняемых в параллельном режиме и обменивающихся информацией в виде тензорных полей. Вычисления являются детерминированными и свободными от состязаний |

Пользователи Cog описывают модель мозга в виде произвольного ориентированного графа (рис. 2). Узлы графа содержат информацию о собственном состоянии и обмениваются данными по связующим ребрам. Все узлы в параллельном режиме исполняют один вычислительный шаг, затем обмениваются данными по связующим ребрам, после чего выполняют следующий вычислительный шаг. В режиме реального времени граф работает с тактовой частотой 100 Гц, что дает элементам в каждом такте 10 мс на выполнение вычислений и обмен данными.

Информация передается по направленному ребру от узла к узлу в виде тензорного поля — дискретного многомерного массива тензоров. Каждый тензор, в свою очередь, представляет собой многомерный числовой массив (скаляр, вектор, матрицу и т. д.). Вычислительные узлы выполняют адаптивные трансформации, которые путем преобразования входных тензорных полей формируют выходные тензорные поля и посылают их по направленным ребрам. Преобразование данных, происходящее в вычислительных узлах, со временем может меняться, поскольку адаптивный характер трансформации делает ее зависимой от входных данных, получаемых как при прямой, так и обратной связи с другими трансформационными узлами, и от истории их обработки.

Аналоговые и цифровые платформы нейроморфных вычислений

Аналоговые нейроморфные вычисления, выполняемые с помощью подпороговых КМОП-схем, обеспечивают потенциально энергоэффективный метод решения нелинейных дифференциальных уравнений, превалирующих во многих нейромоделях. Данный принцип используется в нескольких активных проектах по созданию нейроморфных электронных устройств, в частности в проекте Стэнфордского университета Brains in Silicon, в Fast Analog Computing with Emergent Transient States (FACETS) и в проекте IBM SyNAPSE.

Несмотря на потенциальные преимущества в потреблении мощности, аналоговые вычисления сопряжены с определенным риском. Поскольку нейродинамика в аналоговых схемах, как правило, жестко запрограммирована, аналоговые платформы не отличаются большой гибкостью. Кроме того, работа такой платформы происходит в фиксированном масштабе времени, а вычисления являются недетерминированными из-за вариаций между устройствами, а также паразитных явлений. Наконец, технология изготовления аналоговых схем далека от массового применения, учитывая, что в ИТ-отрасли преобладают цифровые системы.

Надо также отметить, что обучение в аналоговых нейроморфных платформах зачастую ограничивается одним или максимум несколькими методами, среди которых чаще всего используется синаптическая пластичность, зависящая от момента появления спайка. Однако совершенно неясно, является ли данный механизм необходимым или достаточным для реализации широкого спектра функций обработки, свойственных мозгу. Системам, в которых используются динамические наноустройства, например мемристоры, разработанные в качестве основы для аналоговой синаптической памяти, тоже свойственны определенные недостатки. В частности, имеются трудности стабилизации такой памяти для компенсации шума и динамики системы.

Цифровые компьютеры, в свою очередь, широко распространены, отличаются алгоритмической гибкостью и стабильностью работы, но неэффективны при решении задач численного интегрирования. Другими словами, цифровые компьютеры очень хороши для алгебры, но менее пригодны для матанализа. Эту дилемму можно разрешить путем использования цифровой платформы и алгоритмических трансформаций, переносящих нейроалгоритмы, основанные на дифференциальном исчислении, в алгебраическую плоскость. Это проиллюстрировано на приведенных в данной статье примерах задач нормализации контраста и завершения контуров. В каждом из этих случаев первоначальные нейроалгоритмы описывались дифференциальными уравнениями, но для Cog они были преобразованы в неитеративную алгебраическую форму. Поскольку неизвестно, насколько этот подход применим в общем случае, здесь есть определенный риск. Однако свойственные цифровой программной платформе гибкость и снижение риска, связанного с производством, вполне компенсируют любые ее недостатки.

Адаптивные преобразования (трансформации) бывают линейными и нелинейными. Линейные, на которые приходится более 99% вычислений, реализуют разновидность свертки тензора, в процессе которой экстрагируются субполя из входных полей тензора, а затем путем умножения или свертывания этих субполей с помощью внутренних ядер тензоров генерируются выходные тензорные поля. Ядра в пределах поля могут варьироваться и самостоятельно модифицировать свое внутреннее состояние в соответствии с правилами обучения, например модификациями правила Хебба. Поскольку линейные преобразования являются стандартными вычислительными задачами, их можно эффективно выполнять на параллельной платформе.

Но, хотя в большинстве моделей на долю нелинейных преобразований приходится менее 1% всей вычислительной работы, они реализуют важные нерегулярные функции и нелинейную динамику, преобразуя одно или более входных тензорных полей в выходные тензорные поля. Через выходные тензорные поля может осуществляться обратная связь, контролирующая адаптацию линейных трансформаций, выполняющихся непосредственно перед нелинейными. И, поскольку нелинейные трансформации сохраняют информацию о своем состоянии, они также могут адаптироваться и иметь изменяющиеся со временем свойства.

.png) |

| Рис. 3. Процесс обучения. Линейные и нелинейные трансформации совместно реализуют процесс обучения, соответствующий долговременной памяти. Cog использует текущее состояние линейной трансформации W и входное поле x для выдачи частичного заключения y. Затем система объединяет g, x и W, тем самым обеспечивая обучение. Обучающая функция f определяет тип выполняемого обучения |

Каждая адаптивная трансформация, линейная или нелинейная, сама по себе требует массово-параллельных вычислений. Cog автоматически распределяет эти вычисления в соответствии с имеющимися ресурсами. Если доступно только одно процессорное ядро, Cog выполняет все вычисления на нем, уплотняя их по времени. Если доступен один многоядерный процессор, Cog распределяет задачу между всеми ядрами. Если нейросети доступны центральные и графические процессоры, а также чипы Dendra, то Cog переносит линейные преобразования на обычные вычислительные механизмы (графические процессоры, чипы Dendra), передает нелинейные трансформации на ядра центральных процессоров и обеспечивает обмен тензорными полями через локальную память или путем передачи данных по сети.

Все эти атрибуты данной платформы прозрачны для пользователей, что позволяет им сосредоточиться на разработке когнитивных моделей. С добавлением вычислительных ресурсов либо ускоряется работа модели, либо, при работе с реальной окружающей средой, увеличивается максимальный размер модели, которая может исполняться на Cog.

На первый взгляд все эти абстракции могут показаться удаленными от биологических аналогов, однако некоторое соответствие все же имеется. Тензорные поля, продвигающиеся по ребрам графа, подобны информации, которую пучки аксонов передают по нервной системе человека. Линейные трансформации — аналог вычислений, выполняемых в дендритах нейронных скоплений, а обучение или адаптация соответствует модификации синаптических весов. Процесс в целом соответствует сохранению долговременной памяти. Нелинейные трансформации близки к нелинейной динамике популяций нейронных тел (сом) при осуществлении функций кратковременной и среднесрочной памяти.

Обучение

Адаптация линейной трансформации обычно выполняется гораздо дольше, чем нелинейной — эта более медленная адаптация и представляет собой процесс обучения. Как видно из рис. 3, обучение контролируется при помощи обратной связи от нелинейной трансформации. Cog хранит текущее состояние обучения W внутри линейной трансформации, затем система осуществляет свертку или коррелирует W со входным значением x (частью тензорного поля) и тем самым формирует выходное тензорное поле y, которое мы называем частичным заключением. Частичное заключение вызывает выполнение нелинейной трансформации, которая порождает сигнал обратной связи, передаваемый полем g, в линейную трансформацию. Последняя с использованием g, x и W (собственного предыдущего состояния) обновляет свое состояние обучения.

С помощью конфигурирования и путем использования подходящей обратной связи можно реализовать широкий спектр классических законов обучения, подразделяемых на четыре категории:

- разновидности правила Хебба, включая классическое правило Хебба, правило Хебба в комбинации с пассивным затуханием, пресинаптически контролируемое затухание (аутстар), постсинаптически контролируемое затухание (инстар), правило Ойи, двойное ИЛИ и двойное И;

- пороговые правила: ковариация 1, ковариация 2, теория Биненстока-Купера-Мунро (Bienenstock, Cooper, Munro; BCM) в модификации Дайяна и Эббота, первоначальный вариант BCM, BCM в модификации Интрейтора и Купера, BCM в модификации Лоу и Купера;

- правила, базирующиеся на обратной связи, в том числе метод обратного распространения ошибки, правило Харпура и контрастивная дивергенция;

- правила на основе временных последовательностей, в том числе модель Рескорла-Вагнера, обучение с помощью временной разницы и правило Фолдиака.

Среда разработки

Мозг взаимодействует с окружающей средой, получая информацию от органов чувств и отдавая моторные команды, чтобы тело, которым он управляет, могло передвигаться и взаимодействовать с окружающим миром. Платформа Cog предоставляет набор виртуальных сред, с которыми могут взаимодействовать нейромодели. Эти среды, различающиеся по уровню сложности, исполняются одновременно с нейромоделью.

Поскольку Cog имеет синхронную, цифровую архитектуру, пользователи могут останавливать и вновь запускать исполнение модели без нарушения вычислений, чтобы «заглядывать» внутрь нее и по мере необходимости отлаживать. При наличии достаточных вычислительных ресурсов Cog может исполнять модель, взаимодействующую с виртуальной средой, быстрее, чем это имело бы место в реальном времени. На рис. 4 показан снимок экрана пользовательского интерфейса отладчика Cog. В левой части отображается граф отлаживаемой нейросети — в данном случае нейросеть прямого распространения реализует несложную форму задачи завершения контуров объекта. Пользователь может щелкать мышью по различным узлам модели, чтобы просматривать ее внутреннее состояние, которое интерфейс отображает в правой части экрана.

Создание приложений

Cog позволяет реализовать широкий спектр нейроморфных алгоритмов. Чтобы дать представление о возможностях Cog, опишем четыре небольших приложения: нормализация контраста, анализ независимых компонентов, построение карт ориентационной избирательности и доминирования одного из глаз, завершение контуров.

.png) |

| Рис. 4. Отладка с помощью Cog. (слева) Графический пользовательский интерфейс отображает структуру нейросети, по которой пользователь может щелкать мышью, чтобы просматривать внутреннее состояние индивидуальных адаптивных трансформаций, выполняемых моделью. (справа) В каждом из окон отображается одна из адаптивных трансформаций и ее название. Два нижних окна отображают моментальные снимки тензорных полей, сгенерированных и переданных двумя трансформациями нейросети, а верхнее окно показывает график изменения одной из переменных состояния третьей трансформации. |

Нормализация контраста

.png) |

| Рис. 5. Нормализация слишком контрастного снимка крытой автостоянки. (а) В результате стандартной компрессии фотоснимка (по алгоритму. jpeg) теряются детали изображения в очень затененных и ярких областях. (б) Алгоритм Retinex, реализованный средствами Cog, восстанавливает утраченные детали, сохраняя общую контрастность изображения (Фото: R. Brinkworth and D. O’Carroll). |

На рис. 5 приведен пример решения задачи нормализации контраста с использованием алгоритма Retinex, реализованного с помощью Cog. На иллюстрации изображена крытая автостоянка, динамический диапазон снимка которой камера полностью не передает, хотя человеческий глаз способен его воспринять. На рис. 5 (а) в результате стандартной компрессии цифрового снимка теряются детали в самых ярких и самых темных его частях, однако на Cog с использованием одной линейной и одной нелинейной трансформации можно легко реализовать алгоритм Retinex, который после обработки, подобной той, что выполняет сетчатка глаза, может передать подробности как в затененных, так и в ярких участках изображения. На рис. 5 (б) показан эффектный результат работы такого алгоритма. Фильтрация явно нелокальна, поскольку наиболее яркие области изначального изображения не всегда соответствуют самым ярким участкам обработанного. Такая предварительная обработка очень важна для правильного обращения с данными, поступающими из реального мира, которые модель мозга получает на входе.

Анализ независимых компонентов

.png) |

| Рис. 6. Распознавание независимых компонентов естественных изображений. Нейросеть для распознавания независимых компонентов, построенная средствами Cog, вначале обработала случайные фрагменты естественных изображений с помощью фильтра, основанного на вычислении разницы гауссианов, а затем выполнила обработку результата посредством модели BCM-нейрона, одновременно обучаясь по правилу Хебба. Результатом стало формирование 16 изображенных здесь ориентационных фильтров, подобных габоровским |

По мнению ученых, большая часть информации зрительных образов содержится в контурах объектов. Использование ориентационных фильтров позволяет эту информацию регистрировать и уплотнять, что упрощает ее дальнейшую обработку. На рис. 6 показан пример построенной с помощью Cog модели, которая применяет теорию BCM для распознавания независимых компонентов в естественных изображениях.

В данном приложении простая нейросеть, реализованная на Cog, последовательно выполняет три трансформации, имитируя предварительную обработку в зрительной системе человека. Первая трансформация выделяет контуры с помощью фильтра, основанного на вычислении разности гауссианов. Вторая трансформация, линейная, выполняет свертку с адаптивным ядром, реализуя обычный вариант закона обучения Хебба. Наконец, третья трансформация реализует конкурентное нейронное поле в соответствии с теорией BCM. Случайно выбранные фрагменты естественных изображений (фотографий деревьев, травы, полей) возбуждают первый слой, а последние два слоя адаптируются в соответствии со входными данными. Результирующая нейросеть, как показано на рис. 6, самоорганизуется в набор фильтров, которые активно реагируют на контуры («независимые компоненты» естественных изображений) в потоке входных зрительных сигналов, имитируя тем самым работу простых клеток (нейронов) в первичной зрительной коре головного мозга.

Карты ориентации и доминирование одного из глаз

Эксперименты показывают, что простые клетки первичной зрительной коры (области V1) головного мозга действуют подобно фильтрам распознавания контуров и что ориентация этих фильтров на протяжении поверхности V1 плавно изменяется. Эксперименты показывают также, что клетки V1 получают входную зрительную информацию от обоих глаз, но при этом в каждой конкретной клетке доминируют сигналы лишь от одного из них. Области с доминированием сигналов одного из глаз могут располагаться скоплениями или полосами, в зависимости от биологического вида.

Рис. 7 и 8 иллюстрируют реализованную на Cog модель самоорганизации региона V1, имитирующую ориентационное доминирование и доминирование одного из глаз. В данном примере на вход подается серия случайных изображений, преобразованных в пятна в результате сильной фильтрации. Затем топографически подключаются два «взгляда» на изображение, имитирующие просмотр двумя глазами, к смоделированному региону V1. На рис. 7 показана результирующая самоорганизация ориентационных фильтров, а на рис. 8 демонстрируются полученные скопления нейронов с доминированием одного из глаз.

.png) |

| Рис. 7. Топографическая карта ориентационной избирательности. (а) Перед обучением нет идентифицируемых кластеров ориентационной избирательности. (б) Кластеры появляются после обучения; различные цвета соответствуют различным ориентациям |

.png) |

| Рис. 8. Топографическая карта доминирования одного из глаз. (а) До обучения нет идентифицируемых колонок, соответствующих доминированию одного из глаз. (б) Колонки появляются после обучения; белый цвет соответствует преобладанию левого глаза, черный — правого, серый — неопределенности |

Завершение контуров

.png) |

| Рис. 9. Простое завершение контуров. (а) Зашумленная фигура, состоящая из разорванного отрезка и окружности, восстанавливается при помощи алгоритма завершения контуров, реализованного средствами Cog, и (б) становится четкой |

Человек может легко распознавать зрительные объекты, даже когда они искажены или частично скрыты из-за визуального шума или объектов на ближнем плане. Люди каким-то образом восстанавливают недостающую информацию и восполняют картину, формируя завершенные перцептивные образы, предположительно для распознавания на последующих этапах обработки в коре. При решении задачи завершения контуров, являющейся простой формой такого процесса восстановления, достраиваются разорванные и искривленные края и линии с использованием гештальт-психологического принципа близости и фактора «хорошего продолжения» (тенденции восприятия простых, упорядоченных форм).

Самоорганизующиеся нейромодели завершения контуров существуют помимо Cog, но они требуют для обучения слишком много вычислительных ресурсов — гораздо «дешевле» будет просто заранее задать соответствующий механизм в модели, построенной средствами Cog. В такой модели можно использовать огромное количество математических приемов, например регулируемые фильтры, быструю трансформацию Фурье, тензорную свертку и компрессию данных. В отличие от традиционных моделей, основанная на Cog модель со встроенным механизмом завершения контуров требует при реализации по крайней мере в четыре раза меньше энергозатрат.

На рис. 9 показан вход и выход модели на основе Cog, выполняющей простую форму завершения контуров. В данном примере реализована сеть прямого распространения, изображенная на рис. 4, которая восстанавливает зашумленное входное изображение разорванных окружности и отрезка.

***

Несмотря на то что общей теории познания пока не существует, исследователи понимают, насколько важна гибкость платформы для построения нейромоделей, помогающих сквозь туман и неопределенность продвигаться к созданию разумных машин. Cog имеет множество особенностей, обеспечивающих необходимую гибкость. Благодаря тому что основа системы является полностью цифровой, снижаются технологический и производственный риски. Вследствие размещения мемристорных банков синаптической памяти в тесном соседстве с обрабатывающими элементами, на несколько порядков снижается определяемая формулой CV2f потеря рассеиваемой мощности, что особенно важно при исполнении нейромофных алгоритмов, в которых вычисления требуют тесного переплетения собственно вычислительных операций и операций доступа к памяти.

Тензорные механизмы Cog, возможно, пока далеки от биологических, но они удачно сочетаются с разработанной аппаратной технологией на КМОП-схемах и мемристорах. Cog также представляет собой унифицированную систему, на которой можно реализовывать методы алгебры, геометрии и матанализа и которая позволяет применять массу математических и инженерных знаний, например теорию информации и кодирования, цифровую обработку сигналов, неевклидовы системы координат, свертку тензоров, нормализованную свертку, быстрые преобразования Фурье и т. д. Рассматриваемая в данной статье система также поддерживает широкий диапазон законов обучения и моделей нейросетей.

Возможно, самый важный архитектурный атрибут предложенной системы — почти полное отделение программных абстракций для построения мозга (тензорных полей и адаптивных трансформаций) от низкоуровневой аппаратной платформы. За счет этого обеспечивается не только совместимость моделей между существующей и будущими платформами, но и возможность быстрой модификации программной архитектуры для адаптации к новым или непредвиденным алгоритмическим задачам по мере их возникновения.

Грег Снайдер, Рик Эмерсон, Дик Картер, Хишам Абдалла, Мухаммад Шакил Куреши ({snider.greg, frederic.amerson, richard.carter, hisham.abdalla, shakeel.qureshi}@hp.com) — сотрудники HP Labs; Джасмин Левейль (jasminl@cns.bu.edu), Массимилиано Версаче, Хезер Эймс, Шон Патрик, Бенджамин Чандлер ({maxversace, heather.m.ames, sean.patrick.619, bchandle}@gmail.com) — научные сотрудники и аспиранты факультета когнитивных и нейронных систем Бостонского университета; Анатолий Горшечников (tangorn@gmail.com) — профессор факультета когнитивных и нейронных систем Бостонского университета; Эннио Минголла (ennio@cns.bu.edu) — профессор факультета когнитивных и нейронных систем Бостонского университета. Редакция благодарит Геннадия Лившица (glivitz@gmail.com), научного сотрудника Бостонского университета, и Анатолия Горшечникова за помощь в подготовке перевода статьи.