В конце октябре в Москве на международной научной конференции «Управление и виртуализация в современных сетях» («Сети-2014: SDN&NFV») ведущие представители международного научного сообщества обсудили перспективные технологии в сфере компьютерных сетей, виртуализации сетевых ресурсов и облачных вычислений. Организатором конференции выступил Центр прикладных исследований компьютерных сетей (ЦПИКС) при поддержке Министерства образования и науки РФ и факультета ВМК МГУ им. Ломоносова.

|

Марк Берман, руководитель дирекции проекта GENI |

Мировое научное сообщество активно изучает и тестирует технические решения, которые должны стать основой будущего Интернета и распределенных облачных систем. В частности, такие работы ведутся в рамках американского проекта Global Environment for Network Innovations (GENI) и европейского Future Internet Research & Experimentation (FIRE). Во многих университетах и лабораториях по всему миру уже созданы тестовые стенды FIDC — Future Internet and Distributed Cloud. Такие стенды представляют собой стойки с вычислительными системами (серверами), средствами хранения информации (СХД) и сетевыми устройствами. Они могут состоять из различного оборудования и ПО, но в них реализованы две ключевые характеристики: глубокая программируемость и возможность разделения на «слои» (slice), которые, по мнению Марка Бермана, руководителя дирекции проекта GENI, станут ключевыми для сетей будущего.

ПРОГРАММИРУЕМОСТЬ И «СЛОИ»

Под глубокой программируемостью понимается возможность программными средствами определять (конфигурировать и программировать) все имеющиеся в составе тестового стенда ресурсы: серверы, СХД, сетевые средства. Такая программируемость достигается, в частности, благодаря уже хорошо известному подходу программно-конфигурируемых сетей — Software Defined Network (SDN). Этот подход позволяет исследователям (а в будущем — заказчикам) формировать виртуальные сети для обеспечения взаимодействия ресурсов для конкретного приложения или эксперимента.

«Слои» представляют собой группу физических и/или виртуальных ресурсов (вычислительных, СХД, сетевых), которые выделяются и конфигурируются как единая система для решения задач конкретного пользователя или пользователей. Таких «слоев» может быть множество, они будут изолированы друг от друга. По сути, речь идет о формировании программно-конфигурируемых, виртуальных инфраструктур под конкретные задачи.

_300.png) |

| Рисунок 1. Состав стойки GENI. |

В проекте GENI основные элементы — это стойки GENI (см. Рисунок 1), содержащие вычислительные ресурсы, СХД и сетевое оборудование. В рамках одной стойки для формирования «слоев» сети (ее виртуализации) используется технология VLAN. Для организации «слоев» между стойками возможно применение различных технологий, например VLAN или SDN/OpenFlow. К числу недостатков VLAN Марк Берман относит, в частности, то, что она не обеспечивает должного уровня изоляции в части производительности и программного контроля. Поэтому для виртуализации связей между стойками GENI предпочтительнее OpenFlow/SDN.

На данный момент в структуру GENI уже входят более 200 университетов США. В качестве территориально распределенной сети для их взаимодействия активно используется экспериментальная сеть Internet2, которая также основана на OpenFlow.

GENI позволяет проводить «масштабные» эксперименты на вычислительном и коммуникационном оборудовании — например, прогнозировать поведение сложных крупномасштабных сетей, тестировать новые сетевые архитектуры и сервисы. Кроме того, благодаря сети GENI исследователи независимо от своего месторасположения могут получить доступ к вычислительным ресурсам в рамках всей сети.

По мнению Марка Бермана, важными новыми тенденциями в области будущих сетей и распределенных облаков являются международная федерация стендов FIDC, а также разработка программно-конфигурируемых пунктов обмена (Software Defined eXchanges, SDX) и программно-конфигурируемых инфраструктур (Software Defined Infrastructure, SDI).

Вопрос создания федерации — скорее организационный, а не технологический. Для его решения важно выработать, согласовать и принять правила использования разделяемых ресурсов, а также создать брокер, которому будут доверять все участники федерации. Ключевыми должны стать три «A»: Authentication (аутентификация участников), Authorization (авторизация), Accounting (учет потребляемых ресурсов).

«Технические компоненты — самое простое, — считает Куанг-Чинг Ванг, доцент Университета Клемсона (США). — Что действительно является вызовом [при реализации международной федерации] — продумать политики «сцепления» ресурсов и договориться различным институтам и организациям».

Узлы SDX должны стать одним из ключевых элементов для формирования федераций. Их можно определить как физическое или виртуальное «место встречи», где будет происходить обмен трафиком между различными сетями SDN с соблюдением политик, принятых в каждой такой сети. В свою очередь, SDI — это собрание разделяемых ресурсов, сетей и пунктов обмена SDX, которые пользователи могут задействовать для построения мультидоменных программно-конфигурируемых «слоев».

КАК ОБЪЕДИНИТЬ «ОСТРОВКИ» SDN

«То, что мы имеем сегодня, — это отдельные островки SDN. Задача SDX — объединить их», — отмечает Джойл Мамбретти, директор Международного центра перспективных интернет-исследований (International Center for Advanced Internet Research, iCAIR) Северо-Западного университета (США). Развертывание SDN и SDX способно кардинально изменить архитектуру построения Интернета. На Рисунке 2 показана перспективная модель Интернета с использованием пунктов обмена SDX, которую на конференции представил Майкл Зинк, доцент факультета электротехники и компьютерных вычислений в Университете штата Массачусетс в Амхерсте (США).

_500.png) |

| Рисунок 2. Интернет сегодня (слева) и завтра (справа). |

Пока что SDX — это скорее концепция, коммерческих решений не существует, однако уже создан ряд прототипов. Один из таких прототипов разработан Международным центром iCAIR совместно с партнерами и развернут на площадке StarLight в Чикаго. Эта площадка служит для обмена трафиком на физическом уровне (оптические потоки) и уровне L2 между большим числом национальных и международных научных сетей. Чтобы представить масштаб этой площадки, скажем, что на нее приходит почти 30 оптических потоков по 100 Гбит/c, большое число потоков 40G, а также несколько сотен 10-гигабитных потоков.

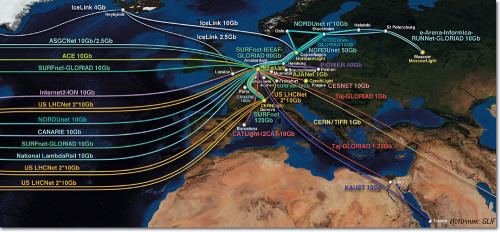

Создание StarLight SDX стало важным шагом на пути реализации инициативы iGENI, нацеленной на построение глобальной экспериментальной сети с использованием технологий OpenFlow/SDN. Эту сеть планируется построить на основе глобальной оптической инфраструктуры (Global Lambda Integrated Facility, GLIF), охватывающей в том числе и Россию (см. Рисунок 3). StarLight — один из ключевых узлов GLIF.

_500.png) |

| Рисунок 3. Европейская часть инфраструктуры GLIF. |

Джойл Мамбретти описывает StarLight SDX как большой виртуальный коммутатор, физической основой которого служат несколько коммутаторов SDN/OpenFlow. Его главная задача, как уже говорилось, — обеспечить взаимодействие множества островков SDN, но при этом планируется, что он будет также поддерживать сетевые сервисы L2 и непосредственно оптические сервисы.

|

|

В 2014 году уже проведены несколько демонстраций работы StarLight SDX, в том числе и по взаимодействию с другими прототипами SDX. Так, в марте была успешно проверена его работа совместно с прототипом SDX, разработанным институтом Georgia Tech и установленным в Атланте на площадке Southern Crossroads Exchange (SOX). Сетевое взаимодействие между узлами SDX осуществлялось с использованием трех отдельных сетей. В качестве тестового в системы было запущено приложение по предсказанию погоды, разработанное Университетом штата Массачусетс в Амхерсте. Позже, в мае, была также успешно продемонстрирована работа StarLight SDX совместно с прототипом SDX, развернутым на площадке NetherLight в Амстердаме.

«ГРАНИТ» SDN

Отрадно отметить, что Россия также находится на технологической передовой в области программно-конфигурируемых сетей. На конференции «Сети-2014: SDN&NFV» Руслан Смелянский, член-корреспондент РАН и директор по науке и образованию Центра прикладных исследований компьютерных сетей (ЦПИКС), заявил о старте проекта GRANIT — Global Russian Advanced Network Initiative, который по сути является российским аналогом GENI. Речь идет о создании современной среды для проведения научно-исследовательских междисциплинарных проектов в сфере науки и образования. При формировании этой среды будут применяться технологии SDN и NFV, позволяющие создать виртуализированную инфраструктуру для каждого отдельного научно-исследовательского проекта.

«Правительства многих стран, включая Россию, потратили немало средств для создания ресурсных центров в разных регионах. Но нет механизмов их использования исследователями и разработчиками из других регионов», — пояснил Руслан Смелянский суть проблемы, которую должен решить проект GRANIT. Его реализация позволит повысить эффективность использования и отдачу от вложений в научное оборудование (включая системы хранения больших массивов данных и высокопроизводительные вычислительные системы), а также в коллекции научных данных. Кроме того, будет облегчено создание кооперации между научно-исследовательскими организациями, повышена мобильность российских ученых.

«Современный процесс научных исследований невозможен без должной информационной инфраструктуры обработки больших массивов данных, — продолжает Руслан Смелянский. — Разные научные дисциплины представляют разнородные требования к инфраструктуре, на которой проводятся эти вычисления, — персональные компьютеры, небольшие кластеры, облачные ресурсы и суперкомпьютеры. Все эти проблемы усугубляются сокращением бюджетов на научные исследования и необходимостью более полной утилизации имеющихся ресурсов». По его мнению, решить проблемы позволит информационная инфраструктура нового типа, которая гибко подстраивается под нужды пользователей, экономична в использовании и открывает контролируемый доступ к ресурсам пользователям из различных организаций.

В GRANIT уже вошли 13 университетов и исследовательских организаций из Москвы, Санкт-Петербурга, Нижнего Новгорода, Ростова-на-Дону, Оренбурга, Томска, Ярославля. Проект свяжет институты и лаборатории в единую систему, которая соединит между собой несколько ЦОД и создаст условия для виртуализации и масштабирования ресурсов. Основой проекта GRANIT может стать федеральная университетская исследовательская компьютерная сеть RUNNet — Russian University Network, узлы которой на данный момент имеются в 63 регионах России. Кроме того, с «Ростелекомом» ведутся переговоры об использовании федеральной телекоммуникационной сети этой компании.

В проекте планируется использовать отечественный SDN-контроллер RUssian Networks Operation System (RUN OS), о разработке которого ЦПИКС объявил в ноябре. Исходный код контроллера выложен в открытом доступе (github.com/ARCCN/runos), и российские разработчики могут уже сейчас приступить к созданию приложений для сетей SDN.

Контроллер разработан с учетом опыта, полученного специалистами ЦПИКС при анализе и изучении около 30 существующих контроллеров OpenFlow, как коммерческих, так и находящихся в открытом доступе. Было проведено их тестирование, определены слабые места. Как утверждают в ЦПИКС, на данный момент это самый быстрый SDN-контроллер в мире. RUN OS обрабатывает до 30 млн потоков в секунду и поддерживает до 1000 коммутаторов. Более высокая производительность, по сравнению с существующими аналогами, достигается за счет использования всех возможностей современных многоядерных и многопроцессорных систем. Контроллер поддерживает большой набор сетевых сервисов и приложений: маршрутизацию L2/L3 с учетом параметров качества обслуживания (QoS), многопотоковую маршрутизацию, фильтрацию трафика, трансляцию адресов (NAT), балансировку нагрузки, виртуализацию сетей, анти-DDоS, верификацию сети, интеграцию с системами управления ЦОД и др.

Новые подходы к построению сетей, которые во главу угла ставят их программируемость, открывают перед российскими компаниями возможность стать заметными игроками на рынке сетевых технологий, на котором до последнего времени Россия выступала лишь как потребитель чужих разработок и продуктов.

Александр Барсков — ведущий редактор «Журнала сетевых решений/LAN». С ним можно связаться по адресу: ab@lanmag.ru.

.png) «Глубокая программируемость и возможность разделения на “слои” (slice) — ключевые характеристики для сетей будущего»

«Глубокая программируемость и возможность разделения на “слои” (slice) — ключевые характеристики для сетей будущего».png) «Еще со времен появления телеграфа кто-то за нас всегда решает, какая услуга связи нам нужна и как она будет предоставляться. В будущем все изменится: каждый сможет получить доступ к необходимым ему ресурсам, чтобы самостоятельно формировать виртуальные сети и сетевые сервисы»

«Еще со времен появления телеграфа кто-то за нас всегда решает, какая услуга связи нам нужна и как она будет предоставляться. В будущем все изменится: каждый сможет получить доступ к необходимым ему ресурсам, чтобы самостоятельно формировать виртуальные сети и сетевые сервисы»