На форумах «МИР ЦОД» вопросам инженерной инфраструктуры центров обработки данных традиционно уделяется самое пристальное внимание. Не стал исключением и прошедший 28–29 мая «МИР ЦОД – 2013», причем от констатации достоинств и недостатков отдельных продуктов и технологий сообщество профессионалов ЦОДостроения все чаще переходит к обсуждению комплексных подходов к реализации такой инфраструктуры и обмену опытом построения и эксплуатации конкретных объектов.

Показателем повышения зрелости отечественной отрасли ЦОД служит рост интереса к вопросам энергоэффективности. Как уже не раз отмечал «Журнал сетевых решений/LAN», главный резерв повышения этого параметра кроется в совершенствовании систем охлаждения, а основным инструментом такого совершенствования служит внедрение технологий естественного охлаждения — free-cooling (см., например, статью автора «Фрикулинг 2.0» в майском номере журнала за 2013 год).

ПРОГНОЗ ПОГОДЫ

Чтобы из всего многообразия технологий фрикулинга выбрать наиболее подходящую для конкретного проекта и рассчитать экономическую целесообразность ее применения, необходимо провести серьезную подготовительную работу. Первое, что следует сделать — выяснить макроклиматические характеристики местности.

Как отмечает Денис Беляев, руководитель направления инженерной инфраструктуры ЦОД компании HP в России, «даже на одной широте климат может сильно различаться, в результате где-то адиабатное охлаждение (для которого желателен сухой воздух) хорошо работает, а где-то не годится вовсе». Наличие подробной базы данных по основным климатическим показателям, таким как температура и влажность, позволит рассчитать, какое количество часов в году можно задействовать фрикулинг, и таким образом определить экономию электроэнергии и в конечном счете окупаемость инвестиций.

Для выполнения подобных расчетов можно воспользоваться специальными программами, которые предлагают ряд производителей систем охлаждения. Но, как указывает Юрий Хомутский, главный инженер проектов компании «Ай-Теко», они, во-первых, предполагают применение конкретного оборудования (то есть не являются универсальными) и, во-вторых, обычно не раскрывают источников информации о погоде. Другой вариант — использовать рекомендации такой уважаемой организации, как Американская ассоциация инженеров в области отопления, холодоснабжения и кондиционирования воздуха (ASHRAE). Но, к сожалению, в них отсутствуют данные по России. В свою очередь, российская документация, а именно СНиП 23-01-99 «Климатология», по мнению специалиста «Ай-Теко», содержит недостаточно детализованные сведения, да и попросту устарела (документ вышел в 1999 году, после чего было несколько аномальных сезонов, в частности жаркое лето 2010 года).

Для расчетов применимости систем фрикулинга сведений о среднемесячных температурах (указанных в СНиП 23-01-99) недостаточно. Например, если ориентироваться на указанную в них для Москвы среднюю температуру в июле, самом жарком месяце, — 18°С, то можно решить, что допустимо круглогодичное использование фрикулинга. Однако в отдельные дни июля температура переваливает 30-градусную отметку, что следует обязательно учитывать. Необходимы данные по каждому дню, причем желательно с подробной детализацией. Такая информация по крупным российским городам представлена, например, на специализированном ресурсе www.aboutDC.ru, где собран архив данных за 14 лет о погоде в Москве, Санкт-Петербурге и ряде других городов с указанием средней температуры за трехчасовой интервал.

Помимо снижения энергопотребления, по данным Юрия Хомутского, фрикулинг обеспечивает и поддержание температуры в серверном зале с большей точностью. В подтверждение он продемонстрировал выкопировки с систем мониторинга реальных объектов, откуда видно, что при использовании фрикулинга колебания температуры составляют всего ±0,3°С, тогда как при эксплуатации обычной системы без фрикулинга в холодном коридоре они значительно выше — ±1°С. Специалист «Ай-Теко» объясняет это тем, что такая система обычно «захолаживает» ЦОД, а потом некоторое время простаивает, что и вызывает такие колебания температуры. При использовании фрикулинга за счет смешения воздушных потоков можно добиться поддержания температуры на требуемом уровне с большей точностью.

Александр Ласый, технический директор департамента интеллектуальных зданий компании «Крок», обращает внимание на то, что энергоэффективность различных вариантов систем охлаждения заметно варьируется в течение года. Скажем, системы фрикулинга с теплообменниками «воздух – воздух» — одни из самых эффективных в прохладные месяцы, однако в жаркое лето требуется включение компрессорных схем, как правило обычных фреоновых кондиционеров, что резко увеличивает PUE. Одним из самых удачных решений специалист «Крок» считает традиционную схему жидкостного охлаждения, но на основе турбочиллеров с фрикулингом. Такое решение обеспечивает достаточно высокую эффективность с плавно изменяющимся PUE без резких сезонных скачков (см. Рисунок 1).

_500.png) |

| Рисунок 1. Распределение энергоэффективности (PUE) по месяцам в случае различных систем охлаждения. |

Кроме того, опираясь на свой опыт внедрения и эксплуатации динамических ИБП (они установлены в одном из трех ЦОД «Крок»), Александр Ласый отмечает, что использование таких систем бесперебойного питания позволяет значительно упростить систему холодоснабжения. В традиционных решениях на случай аварии по электропитанию предусматриваются специальные емкости с захоложенной водой, которая «дает холод» на время включения ДГУ (несколько минут). Помимо этого, отдельные системы бесперебойного питания предусматриваются для насосов, прокачивающих хладоноситель. В случае использования ДДИБП всего этого не требуется, поскольку дизель-генератор запускается практически сразу же после отключения внешнего электроснабжения.

PUE или Tier? А может, модульный ЦОД?

При проектировании и построении инженерной инфраструктуры ЦОД специалистам почти всегда приходится находить компромисс между обеспечением высокого уровня надежности (отказоустойчивости) и энергоэффективностью. В общем случае чем выше уровень резервирования, тем ниже энергоэффективность: мощность ИТ-оборудования остается той же, а потери в инженерной инфраструктуре растут пропорционально коэффициенту резервирования. Другими словами, чем выше (лучше) уровень Tier, тем выше (хуже) коэффициент PUE.

Как считает Александр Ласый, технический директор департамента интеллектуальных зданий компании «Крок», в поиске такого компромисса следует отталкиваться от бизнес-задач. Скажем, для крупного контент-провайдера, располагающего большим числом ЦОД и распределяющего нагрузку между ними, даже «падение» одного ЦОД на час не приведет к прекращению предоставления сервиса — возможно лишь небольшое снижение его качества. Для такой компании на первое место выходит энергоэффективность, поскольку позволяет существенно снизить операционные затраты. Что касается, например, финансовой структуры, то для нее главный приоритет — надежность, поскольку даже непродолжительный сбой способен прервать критически важные транзакции с непредсказуемыми последствиями. В этом случае энергоэффективность отходит на второй план.

Сама компания «Крок» как поставщик услуг коммерческих ЦОД, включая облачные сервисы, тоже ставит на первое место надежность. «Энергоэффективность мы стараемся оптимизировать при условии обеспечения требуемого уровня готовности», — замечает Александр Ласый.

Главный враг PUE, по его мнению, недозагруженность центра обработки данных. «Эффективность коммерческого ЦОД зависит от искусства продажи его мощностей, — продолжает он. — Даже если вы построили ЦОД с супернизким расчетным PUE, но загрузили его всего на 10%, то эффективность заведомо не может быть высокой. Отсюда интерес к модульным ЦОД: построили один модуль — загрузили его, потребности выросли — установили второй модуль и т. д.».

По мнению Алексея Соловьева, системного архитектора компании Schneider Electric, на рынке пока не сложилось единого понимания того, что же такое «модульный ЦОД», а многие подразумевают под этим понятием контейнерный ЦОД, что далеко не всегда верно. Он считает, что в настоящем «модульном ЦОД» все подсистемы должны быть модульными, причем их компоновка должна быть такой, чтобы сложность развертывания оказалась минимальной. Совместимость модулей и производительность всей системы, составленной из предписанных комбинаций модулей, должны быть известны заранее, а методы добавления модулей при росте ЦОД — четко проработаны.

Одной из наиболее сложных и важных проблем, как полагает специалист Schneider Electric, является определение «кванта» модуля в соответствии с масштабами задачи, чтобы решение было оптимально по стоимости и простоте. При этом важно также обеспечить: возможность оптимизации производительности системы (компактность, энергоэффективность, отказоустойчивость); добавление в будущем опций, повышающих доступность и плотность мощности; универсальность и открытость решения для размещения новых модулей от разных производителей.

Конечно, модульный подход не свободен от недостатков. Так, заказчики не могут выбрать произвольный размер кванта, возможно, им придется отказаться от определенных преференций и внутренних стандартов. Сложности могут возникнуть и с адаптацией модулей к архитектурным особенностям существующей площадки. Но в целом, по данным Schneider Electric, использование модульного подхода обеспечивает снижение капитальных и операционных затрат на 2–7 долларов в пересчете на 1 Вт мощности ЦОД. Это очень существенная экономия, возможность достижения которой подогревает интерес к модульным решениям.

УЧЕТ ЗАГРЯЗНЕНИЙ

Но даже самых точных сведений о температурно-влажностных характеристиках в месте предполагаемого размещения ЦОД недостаточно, чтобы грамотно выбрать технологию фрикулинга. Помимо них, важно знать то, что Денис Беляев из HP называет «микроклиматикой» — в частности, данные по загрязнению воздуха. Они особенно важны для расчета систем прямого фрикулинга, когда в серверные залы ЦОД воздух подается непосредственно с улицы. Ясно, что предварительно он должен подвергаться очистке. В случае высокого уровня загрязнений фильтры придется менять настолько часто, что дополнительные расходы быстро «съедят» все экономию от фрикулинга.

В качестве примера Денис Беляев приводит один из проектов ЦОД в Казахстане. Проектировщики не учли, что объект находится рядом с частным жилым сектором, отапливаемым углем. Фильтры системы фрикулинга стали столь интенсивно забиваться сажей, что их пришлось менять чуть ли не каждую неделю. Специалист HP рекомендует учитывать также такие факторы, как эрозийность почвы (вероятность песчаных и пылевых бурь), пожароопасность (торфяники, лесные пожары), роза ветров.

Данные по направлению ветра помогут правильно разместить напорные вентиляторы, подающие воздух в ЦОД, и места выброса теплого воздуха. При этом важно избежать так называемого короткого замыкания, которое может возникнуть, если теплый воздух из ЦОД будет попадать в заборники холодного воздуха. Кроме того, вентиляторы для забора воздуха не должны располагаться рядом с ДГУ. Денис Беляев приводит еще один пример неудачного решения, когда при включении ДГУ выхлопные газы попадали в ЦОД, что вызывало срабатывание системы газового пожаротушения.

ОСОБЕННОСТИ ПЛОЩАДКИ

Большое значение при выборе технологий инженерной инфраструктуры имеют особенности самой площадки. Например, как рассказал Алексей Сарыгин, вице-президент по технической политике Radius Group, из-за серьезных ограничений на размеры площадки нового ЦОД мощностью 21 МВт в особой экономической зоне Алабушево (к северу от Москвы) был выбран вариант строительства многоэтажного модульного здания. Архитектурно ЦОД, запуск которого в коммерческую эксплуатацию намечен на конец 2013 года, представляет собой конструкцию из трех модулей по три этажа. На одном этаже располагаются три машинных зала, которые соединяются с технологическими помещениями, расположенными в шесть этажей.

Новый ЦОД, по словам специалиста Radius Group, — это сочетание консерватизма и инноваций. Так, традиционная чиллерная схема охлаждения дополнена комплектом низкотемпературных аккумуляторов холода, в которых хладагент замораживается до -10°С. Такое решение позволяет значительно сократить объем резервного хладагента и обеспечить резервирование климатической установки на время запуска ДГУ. Кроме того, для ЦОД в Алабушево были выбраны новейшие ИБП Protect Blue компании AEG. На первом этапе там будет установлено 36 таких агрегатов по 250 кВт каждый, где применяются IGBT-технологии третьего поколения, благодаря чему удается достигнуть КПД 96% практически во всем диапазоне нагрузок (начиная с 24–25% загрузки), что подтверждается практикой — см. Рисунок 2. Теоретический КПД составляет 96,5–97%.

_500.png) |

| Рисунок 2. Зависимость КПД источника бесперебойного питания Protect Blue компании AEG от загрузки. |

Другой пример учета специфики площадки при выборе инженерных систем — ЦОД группы компаний Hostex BDC (Baltic Data Center), построенный в 2010 году в Вильнюсе. Как рассказывает Вакарис Стакаускас, директор центра инфраструктурных услуг Hostex BDC, ЦОД создавался в существующем здании — хотя само по себе оно было небольшим, но зато к нему была подведена достаточно высокая электрическая мощность. Именно это обстоятельство во многом предоп-

ределило выбор для системы охлаждения решения Kyoto Cooling (подробнее о нем можно прочитать в статье автора «Модули холода» в майском номере «Журнала сетевых решений/LAN» за 2011 год). Будучи дороже традиционных фреоновых и жидкостных систем, Kyoto Cooling вместе с тем обеспечивает отвод большей мощности тепла со стойки (до 20 кВт) и имеет более низкий коэффициент PUE. Кроме того, большая часть системы Kyoto Cooling может быть размещена снаружи здания (массивные тепловые колеса), благодаря чему удалось сэкономить полезную площадь для размещения ИТ-оборудования.

Компания Hostex BDC приводит данные измерения PUE для системы охлаждения за период с мая 2012 года по январь 2013 года (см. Рисунок 3). Его минимальное значение составило 1,04, максимальное — 1,38 (при температуре окружающего воздуха +32°С), среднее — 1,09. Это даже лучше, чем расчетный PUE 1,15. «Когда мы выбирали решение в 2009 году, технология только появилась, и вкладывать в нее средства было рискованно. Поэтому мы договорились с поставщиком системы охлаждения, чтобы в контракте было оговорено, что PUE не должен превысить 1,15, — в противном случае поставщик обязуется оплатить все дополнительные расходы на электричество. Пока прецедентов не было», — рассказывает Вакарис Стакаускас.

_500.png) |

| Рисунок 3. Данные измерения PUE для системы охлаждения Kyoto Cooling в ЦОД компании Hostex BDC. |

_250.png) |

| Рисунок 4. Использование различных режимов охлаждения в ЦОД компании Hostex BDC. 85% времени в году используется только естественное охлаждение. |

Анализ данных эксплуатации показал (см. Рисунок 4), что 85% времени в году используется только естественное охлаждение, 14,7% — смешанное охлаждение и только оставшиеся 0,3% — традиционное охлаждение, которое обеспечивается встроенными в систему фреоновыми кондиционерами. По словам Вакариса Стакаускаса, при текущих ценах на электричество клиент энергоэффективного ЦОД с системой Kyoto Cooling (PUE 1,09) будет платить на 12% меньше клиента, использующего услуги традиционного ЦОД с PUE 1,8. Этот расчет специалисты Hostex BDC выполнили для компании, арендующей технологическое пространство 300U и потребляющей 60 кВт электричества (см. Рисунок 5).

Многим компаниям, как и Hostex BDC, приходится создавать ЦОД в уже имеющихся, часто не приспособленных под данную задачу зданиях. Алексей Волков, менеджер по работе с системными интеграторами компании Tripp Lite, рекомендует обращать самое пристальное внимание на несущую способность помещений.

«Все чаще от мощных систем бесперебойного питания требуется длительное время автономной работы: два, четыре и даже шесть часов. Для этого приходится устанавливать огромный массив аккумуляторных батарей, что создает повышенную нагрузку на пол, — рассказывает он. — Предположим, заказчик решил на пятом этаже обычного офисного здания — с типовой максимальной нагрузкой 500 кг на 1 м2 — разместить ИБП мощностью 120 кВА с аккумуляторами на 4 ч автономной работы. Установленные в стеллаж, такие аккумуляторы создают нагрузку примерно 2,6 т на 1м2. Для их размещения необходимо найти другое помещение, например на первом/цокольном этаже, сделать разгрузочные рамы или возвести дополнительные (усиливающие) колонны».

О том, что большинство зданий, которые не были специально построены для организации ЦОД, могут представлять опасность для ИТ-оборудования, преду-преждает Александр Нилов, менеджер по продукции для ИТ-инфраструктуры компании Rittal. В частности, обычный бетон содержит большое количество влаги, которая выделяется при нагреве. Поэтому если в соседнем с серверным залом помещении вспыхнет пожар — а по статистике, абсолютное большинство всех пожаров (80%) возникает за пределами помещений ИТ, — то через 20 мин в этом зале будет полно воды (скажем, в комнате размерами 5 × 6 × 3 м может образоваться 870 литров воды) и коррозийных газов, что в итоге приведет к выходу из строя дорогостоящего ИТ-оборудования.

«При строительстве ЦОД необходимо предусмотреть, чтобы оборудование было защищено от огня, воды, водяного пара, выделяемого тепла, несанкционированного доступа и т. д., — объясняет специалист Rittal. — При выборе подходящего места для систем ИТ следует обращать внимание на то, чтобы соседние с защищаемыми помещениями комнаты были пожаробезопасными или степень угрозы возникновения пожара в них была низкой. Потенциальную опасность представляют также предприятия, где производственные процессы сопровождаются высокими пусковыми токами, поскольку последние могут служить источником сильных электромагнитных импульсов. Помещения, где размещается оборудование ИТ, должны быть защищены от затопления и наводнений, по возможности непосредственно над ними, этажом выше, не должны находиться кухни и санузлы».

Компания Rittal предлагает создавать ЦОД на основе модульных комнат безопасности различных типов. Комната собирается, как конструктор, и может расширяться (насколько позволяет внешнее помещение). Это катастрофоустойчивое решение защищает оборудование от пожаров, наводнений и взломов, причем комнаты могут иметь разную степень катастрофоустойчивости. Требование к перекрытию для помещений Rittal — 450 кг на 1 м2, высота — не менее 2,8 м. Элементы полностью разборной модульной конструкции могут быть доставлены к месту монтажа даже при отсутствии грузового лифта, а для масштабирования на этапе проектирования достаточно предусмотреть, в каком направлении и каким образом будет расширяться помещение. Срок строительства ЦОД значительно сокращается и благодаря тому, что не требуется дорогостоящая и длительная строительная подготовка помещений.

ЧЕМ ЛЕЧИТЬ «АКВАФОБИЮ»

Блоки охлаждения с теплообменниками вода – воздух все чаще устанавливаются непосредственно в серверных залах — это позволяет подвести эффективный холодоноситель (воду) очень близко к источникам тепла (серверам). Однако далеко не все менеджеры по ИТ преодолели «аквафобию», многие до сих пор опасаются присутствия воды рядом с серверами. Им можно порекомендовать обратить внимание на разработку инженеров английской компании Aqua Cooling, которая была представлена на форуме «МИР ЦОД» ее российским партнером компанией «Спецсервис». Если в традиционных системах вода подается под давлением, то в решении Aqua Cooling создается отрицательное давление, поэтому даже в случае повреждения трассы с водой наружу ничего не просочится (см. Рисунок 6). Более того, систему можно продолжать эксплуатировать, оставив ликвидацию повреждения до запланированного выключения.

Для охлаждения серверов Aqua Cooling разработала холодные двери, которые представляют собой теплообменник вода – воздух. Всего выпускается пять моделей дверей с возможностью отвода от стойки от 0,5 до 58 кВт тепла. Посредством специальной стыковочной рамы (interface frame) они могут монтироваться на шкафы многих известных производителей, таких как IBM, EMC, HP, Rittal и др. Интеллектуальная система управления CMC ColdLogik обеспечивает регулирование температуры за счет изменения скорости вращения вентиляторов в дверях и регулирования потока воды с помощью клапана с сервоприводом.

По данным Aqua Cooling, ее решение успешно внедрено уже более чем в 60 проектах по всему миру, включая объекты правительства США, различные университеты, такие компании, как Arm Holdings, Dong Energy, Jaguar Land Rover, Stihl. Ее представители утверждают, что применение стоек с водяным охлаждением позволяет снизить инвестиции в ЦОД на 40% и сократить потребление электроэнергии на 15%.

Если же вода в серверном зале — даже с самой инновационной системой защиты от протечек — все же неприемлема, то тогда есть смысл обратить внимание на систему Liebert XD компании Emerson Network Power. Архитектурно она построена как традиционная жидкостная система (в ней нет холодильного цикла), вот только вместо воды в качестве холодоносителя используется безопасный для оборудования фреон. Вода присутствует только во внешнем контуре (он не «заходит» в серверный зал) и через теплообменники в гидравлическом модуле охлаждает циркулирующий во внутреннем контуре фреон (см. Рисунок 7).

_500.png) |

| Рисунок 7. Схема организации системы охлаждения Liebert XD компании Emerson Network Power. |

Опытом внедрения этой системы поделился на форуме Виктор Гаврилов, технический директор компании «АМДтехнологии». Она была применена при модернизации небольшого ЦОД, в ходе которой потребовалось увеличить его мощность в 2,5 раза и, соответственно, во столько же раз больше отводить тепла. Изначально помещение было разделено на две зоны с суммарной мощностью тепловыделения от серверного оборудования 218 кВт. Для его съема имелось четыре шкафных кондиционера (3 рабочих + 1 резервный), холодный воздух от которых подавался под фальшполом высотой 300 мм. Заказчику требовалось повысить мощность в одной зоне (высокой плотности) до 350 кВт, а в другой (стандартное оборудование) — до 216 кВт.

Вариант повышения мощности кондиционеров оказался непригоден уже потому, что, даже увеличив число перфорированных решеток, нельзя было обеспечить требуемый поток холодного воздуха. Довольно распространенный вариант с установкой внутрирядных кондиционеров тоже не подошел — для них не было места, поскольку заказчик разрешил удалить максимум одну серверную стойку из ряда. В результате была выбрана система Liebert XD с установкой кондиционеров-доводчиков над серверными стойками. «При ее использовании полезная площадь не занимается, а монтировать кондиционеры-доводчики можно без остановки серверного оборудования, подключая их к системе трубопроводов с помощью быстро устанавливаемых гибких шлангов», — рассказывает Виктор Гаврилов. (Кроме того, в рамках проекта были установлены несколько внутрирядных кондиционеров, где это было возможно.)

В системе Liebert XD нет компрессоров: охлаждение воздуха происходит путем теплообмена с фреоном. При этом последний частично выкипает, и паро-жидкостная смесь возвращается в гидравлический модуль, где конденсируется за счет теплообмена с водой из внешнего контура, после чего цикл повторяется (см. Рисунок 7). «Это очень изящная система, — продолжает технический директор «АМДтехнологии». — В доводчиках нет никакой автоматики, а объем выкипающего фреона определяется температурой охлаждаемого воздуха — соответственно, чем выше температура, тем больше фреона выкипает, нагрузка меньше — и фреона меньше выкипает. Таким образом, система подстраивается под тепловую нагрузку, а использование минимума электроники повышает надежность».

Температура теплоносителя в системе поддерживается на пару градусов выше точки росы, чтобы не образовывался конденсат. Для обеспечения необходимого уровня влажности в помещении используются старые кондиционеры, а вода во внешнем контуре охлаждается внешним чиллером с функцией фрикулинга. Расчетный PUE этого проекта (точнее, его системы охлаждения) составляет 1,21 — отличный показатель при среднемировом уровне 1,8–1,9. В ходе реализации проекта, что особо подчеркивает Виктор Гаврилов, ЦОД продолжал функционировать и «ни один сервер не пострадал».

КАК ОБНОВИТЬ СТАРЫЙ ЦОД

Несмотря на то что отрасль ЦОД относительно молода, все чаще на повестке дня встает вопрос о модернизации старых объектов. Большинство построенных в начале 2000-х годов серверных комнат и вычислительных центров (тогда термин «ЦОД» еще не получил столь широкого распространения) уже морально устарели и не справляются с резко возросшей плотностью мощности и новыми требованиями со стороны виртуализированных ИТ-систем. Часто, как в рассмотренном выше проекте, модернизацию необходимо провести без остановки работы серверов.

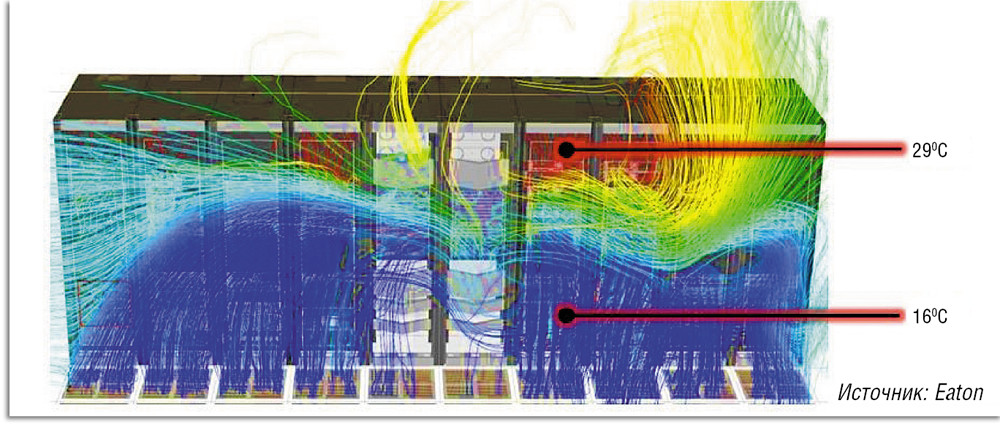

Вопросам продления «жизни» ЦОД посвятил свое выступление на форуме «МИР ЦОД» Массимо Маннелли, менеджер по развитию бизнеса в странах Северной Европы и России электротехнического сектора компании Eaton. По его мнению, главная проблема старых ЦОД в том, что их системы охлаждения не позволяют снимать увеличивающуюся тепловую нагрузку. В таких ЦОД отсутствуют средства разделения воздушных потоков, а их скорость порой столь высока, что они просто проносятся мимо источника тепла. Модернизацию подобных ЦОД серьезно осложняет запутанная кабельная проводка. «Заходишь в серверный зал, поднимаешь плитку фальшпола, а там — спагетти из проводов. Ничего добавить нельзя, да к тому же току охлаждающего воздуха создаются серьезные препятствия», — делится своими наблюдениями специалист Eaton.

Сложности с охлаждением усугубляет набирающая обороты виртуализация серверных ресурсов. Нагрузка на серверы неравномерная, в результате возникают точки перегрева (см. Рисунок 8), причем из-за перемещения виртуальных машин точки перегрева тоже перемещаются, картина теплового поля меняется динамически. По мнению Массимо Маннелли, наиболее простой и эффективный способ решения названных проблем — это изоляция воздушных потоков путем установки дверей, потолка и закрытия коридоров. Помимо вариантов изоляции холодного или горячего коридора, он также рекомендует рассмотреть возможность установки «вытяжек» для вывода теплого воздуха в пространство над фальшпотолком (см. Рисунок 9). Этот способ изоляции воздушных потоков особенно востребован в ЦОД, где установлены стойки разной высоты, а потому общую крышу организовать затруднительно.

_500.png) |

| Рисунок 8. Возникновение зон перегрева в ЦОД. |

| Рисунок 9. Различные варианты изоляции воздушных потоков в ЦОД. |

Какой коридор изолировать — горячий или холодный, зависит от большого числа факторов, начиная с нагрузки на стойки и заканчивая необходимостью создания комфортных условия для обслуживающего персонала. Артем Антипов, менеджер по развитию бизнеса компании Delta Electronics, привел пример проекта, в котором реализованы оба варианта. В комнате с сетевым оборудованием (тепловая нагрузка меньше) закрыли холодный коридор, а в комнате с серверным оборудованием — горячий. При этом крыши сделали цветными — синей и красной соответственно, чтобы сразу было понятно, где какой коридор закрыт (см. Рисунок 10).

По словам Артема Антипова, изоляция горячих и холодных коридоров в данном проекте позволила снизить расчетный PUE на 0,2, еще минус 0,15 дали высокоэффективные модульные ИБП — в результате PUE объекта оказался равным 1,43. На объекте установлено ПО ShutdownAgent, обеспечивающее мониторинг ИБП и автоматическое управление завершением работы не только физических серверов, но и виртуальных машин.

НЕ ЗАБЫВАЯ ПРО ИБП

При модернизации ЦОД обычно приходится обновлять и системы гарантированного бесперебойного питания. По словам специалиста Eaton, поскольку у ИБП нового поколения КПД значительно выше, то зачастую затраты на такую модернизацию удается компенсировать благодаря повышению эффективности. Кроме того, современные ИБП имеют улучшенные возможности мониторинга, а также средства для корректной поддержки виртуализированных сред, что чрезвычайно важно для повышения управляемости и надежности ЦОД.

Высокий КПД современных ИБП позволяет не только непосредственно экономить электроэнергию, но и снизить затраты на систему кондиционирования: тепла высокоэффективный ИБП выделяет меньше, следовательно, и средства кондиционирования можно поставить менее производительные, а значит — менее дорогие. Кроме того, такие кондиционеры потребляют меньше электричества — а это еще один пункт в графе «снижение операционных затрат».

Многие ведущие мировые производители ИБП и/или их российские партнеры представили на «МИР ЦОД – 2013» системы с улучшенными КПД. Это, например, уже упомянутый ИБП Protect Blue компании AEG или TLE Series от GE Digital Energy (см. Рисунок 11). Но в любом случае при двойном преобразовании КПД не превышает 96,5%. Еще на несколько процентов КПД можно поднять, включив экономичный режим (подробнее об особенностях такого режима в продукции разных производителей — в статье автора «Все цвета «зеленого» ЦОД» в июльском-августовском номере «Журнала сетевых решений/LAN» за 2012 год). Однако отношение отечественных специалистов к использованию этого режима остается неоднозначным.

_500.png) |

| Рисунок 11. КПД источника бесперебойного питания TLE Series компании GE. |

Василий Лапшин, руководитель направления продаж оборудования GE Digital Energy в компании «Абитех», представил реальную статистику использования ИБП с экономичным режимом eBoost за три года (с марта 2010 по март 2013 года) на более 50 объектах одного из заказчиков в США. Среднее время использования режима eBoost составило более 90% (соответственно, режим двойного преобразования, VFI, был задействован менее 10% времени). При этом не было зафиксировано ни одного случая отключения нагрузки. Подобные примеры доказывают надежность использования экономичных режимов, но серьезным препятствием на пути его применения в России по прежнему остается недоверие со стороны специалистов. «Инженерный персонал не ориентирован на снижение расходов электроэнергии, его задача — обеспечить высокое качество обслуживания», — констатирует представитель «Абитех».

Алексей Волков из Tripp Lite рекомендует задействовать экономичный режим, если «у объекта надежное и качественное электропитание и на нем не случается частых отключений, провалов, выбросов или скачков напряжения». «При переходе в экономичный режим КПД ИБП обычно повышается на 5%, вдобавок снижается нагрузка на систему кондиционирования, так что она потребляет меньше электроэнергии — в результате достигается существенная экономия», — констатирует он.

Одним из возможных путей «совместить несовместимое» — повысить надежность и эффективность систем бесперебойного питания — Андрей Вотановский, ведущий специалист компании Emerson Network Power, считает переход на системы постоянного тока (DC) напряжением 400 В.

В таких системах осуществляется меньше преобразований электричества, чем в традиционных, основанных на ИБП переменного тока (AC), что одновременно снижает потери и увеличивает надежность. По расчетам Emerson, применение таких систем позволит дополнительно добиться экономии в 11% — с учетом снижения потерь в самом ИТ-оборудовании за счет использования блоков питания без преобразования AC/DC (см. Рисунок 12).

_500.png) |

| Рисунок 12. Принципиальные схемы построения систем бесперебойного питания на основе традиционных ИБП переменного тока (AC) и систем постоянного тока (DC) 400 В. |

«Этот подход выглядит почти идеальным, но, к сожалению, производители ИТ-оборудования пока не готовы переходить на блоки питания постоянного тока. Других препятствий нет, — считает Андрей Вотановский. — Но, возможно, в конце концов рынок оценит такие системы».

Сегодня на рынке доступно большое число технологий и продуктов для построения инженерных инфраструктур ЦОД. Главное — грамотно проанализировать имеющиеся варианты и подобрать оптимальный — с учетом особенностей бизнеса владельца ЦОД, места размещения объекта, специфики его окружения и других факторов. Обмен опытом и мнениями, происходящий на таких форумах, как «МИР ЦОД», чрезвычайно полезен для решения этих задач.

Александр Барсков — ведущий редактор «Журнала сетевых решений/LAN». С ним можно связаться по адресу: ab@lanmag.ru.

_250.png)

_500.png)

_500.png)

_500.png)