Выражение «эффективность использования энергии» стало популярным, и именно этот показатель является главным условием создания «экологичного» вычислительного центра. Его величина зависит от многих аспектов: от коэффициентов полезного действия блока питания и процессора, конструктивных особенностей серверов и стоек, схемы помещений, этажей и всего здания, и даже от географического расположения последнего и стабильности подачи питания в регионе.

Каждый аспект сам по себе предлагает определенные возможности для повышения эффективности (см. Рисунок 1). Чтобы использовать этот потенциал полностью, необходима единая всеобъемлющая концепция повышения эффективности. Бюджетные ограничения, темпы роста объема данных и производительности, а также инновации одинаково значимы для вычислительного центра. Ключевым считается оптимальное использование выделенного места и имеющихся ресурсов. Иначе говоря, необходимо решить, как наиболее эффективно организовать эксплуатацию имеющейся инфраструктуры (самого помещения, а также систем охлаждения и питания) с применением новых технологий, чтобы при затрате минимальных ресурсов обеспечить максимальную производительность. В данном контексте эффективность можно обозначить как коэффициент использования энергии (Power Usage Effectiveness, PUE). Это значение равно единице, если вся получаемая вычислительным центром энергия преобразуется в реальную вычислительную мощность.

ЭФФЕКТИВНОСТЬ ИСПОЛЬЗОВАНИЯ ЭНЕРГИИ НА УРОВНЕ КОМПОНЕНТОВ

Кто покупал холодильник в магазине электроники, знает, что на битовых устройствах указываются классы энергоэффективности, данные о потреблении электроэнергии и мощность охлаждения. Подобная система теперь введена и для персональных компьютеров, рабочих станций и ноутбуков. В соответствии с обозначением Energy Star американской организации EPA с 20 июля 2007 г. к этим устройствам предъявляются более жесткие требования в отношении потребляемой ими энергии. Новая редакция (4.0) предписывает обязательное применение так называемых блоков питания 80 Plus, которые должны работать с 80-процентной эффективностью при разных уровнях нагрузки — будь то 20, 50 или все 100%. Но до сих пор эти правила не применялись к серверам — хотя необходимые технологии уже давно существуют.

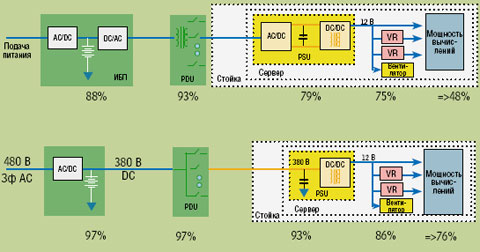

Неэффективность сервера проявляется во многом: лишь 50% потребляемой энергии преобразуется в вычислительную мощность, а на неэффективное питание уходит около 30% всей потребляемой устройствами энергии (см. Рисунок 2). Под обозначением «переключение по требованию» в процессоры внедряется технология, которая получила известность как Speedstep благодаря архитектуре Intel Centrino, а сегодня называется расширенной технологией SpeedStep (Enhanced SpeedStep Technology). Производительность серверных процессоров «по требованию» регулируется в соответствии с шестью уровнями, причем без привлечения операционной системы и без прекращения работы — на базе таблицы ACPI, составляемой производителем системной платы. Благодаря этой архитектуре процессора Xeon 5100 (под кодовым названием Woodcrest), а также многоядерных структур, по данным Intel, потребление питания сокращается на 40% (65 Вт вместо 110 Вт). При использовании модульных серверов возможно и дальнейшее уменьшение потребляемой энергии — еще на 25%.

Кроме того, значительно сэкономить можно и на подаче питания, а благодаря применению ИБП с дельта-преобразованием (Delta Conversion On-Line UPS) вместо ИБП с двойным преобразованием можно достичь более высокого КПД. Упразднение некоторых компонентов системы распределения электроэнергии и вторичного распределительного пункта в стойке за счет передачи постоянного тока сокращает общие потери на 50% (см. Рисунок 3) и одновременно повышает уровень готовности системы, поскольку уменьшается общее число компонентов, которые могут выйти из строя.

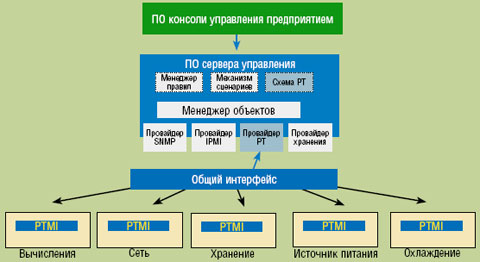

В рамках поддерживаемой компанией Intel отраслевой инициативы по автоматическому управлению потреблением энергии (Automatic Control of Power Consumption, ACPC) (см. Рисунок 4) многие предприятия взялись за решение задачи по оптимизации максимального потребления энергии в стойках или помещениях. С одной стороны, это делается для определения абсолютных допустимых пределов потребления, к примеру, в случае ограниченной подачи энергии; с другой — новая методология позволит моделировать максимально необходимую мощность. Так, сервер будет получать больше энергии, если другие серверы в ней не нуждаются. Эта технология тесно связана с упоминавшимся переключением по требованию и представляет собой базу для так называемого управления энергопотреблением и выделением тепла на предприятии (Enterprise Power and Thermal Management).

Переключение по требованию и контроль за энергопотреблением и выделением тепла делают возможным управление энергией на уровне серверных стоек. Следующим шагом является управление всеми стойками в вычислительном центре — включая охлаждающие установки. Эта задача довольно сложна, прежде всего в отношении организации взаимодействия между ИТ-системами и другой имеющейся техникой. Запатентованная компанией Intel технология под названием «управление энергопотреблением и выделением тепла на предприятии» (Enterprise Power and Thermal Management, ETPM) направлена на решение именно этой проблемы (см. Рисунок 5). Благодаря стандартизированному интерфейсу управления энергопотреблением и выделением тепла на всех задействованных компонентах и системах все сообщения передаются центральной инстанции. Идея в целом не нова и уже реализована во многих инструментах системного управления инфраструктурой ИТ. Однако аспекты охлаждения и функционирование бытовой техники оставались без внимания. При последовательном применении моделирования можно, к примеру, ограничить климатическую систему, поток воздуха от вентиляторов и потребление энергии резервной системой охлаждения до необходимого минимума и, таким образом, добиться экономии энергии от 20 до 30%.

Существенному сокращению потребления электроэнергии способствует применение технологий виртуализации. Большая часть инсталлированных серверов работает со средней нагрузкой от 10 до 30%. При более высокой нагрузке понадобится меньшее количество физических серверов. Дополнительная емкость позволяет повысить уровень безопасности (сценарий отказа), динамики (пики мощности) или гибкости (тестовые и демонстрационные среды). После консолидации и рационального распределения виртуальных машин на оптимальном аппаратном обеспечении можно сэкономить от 60 до 80% энергии при нормальной работе оборудования. Примерно такие же значения достигаются и в случае систем хранения данных.

МЕСТОПОЛОЖЕНИЕ И ЗДАНИЕ

После того как в 2006 г. несколько штатов США были вынуждены на несколько часов отключать целые кварталы от сети электроснабжения, чтобы обеспечить работу экстренных служб, к выбору местоположения вычислительного центра стали относиться с большей ответственностью. Два прямо противоположных гипотетических примера, безусловно, весьма показательны для понимания ситуации:

-

в африканской пустыне производство электроэнергии при помощи солнечных батарей было бы недорогим и эффективным,

к тому же свободного места более чем достаточно, но организовать подключение к глобальной сети и обеспечить охлаждение зданий в условиях почти постоянной жары крайне сложно; -

постройка вычислительного центра на Северном или на Южном полюсе удобна с точки зрения охлаждения и достаточной территории. Однако и в этом случае подключение к сети становится нетривиальной задачей, как и подача необходимой энергии.

В том, что касается энергоснабжения, необходимо учитывать различные аспекты. Так, к примеру, географическая близость к поставщику энергии обычно является преимуществом, поскольку гарантируется полноценное и надежное питание.

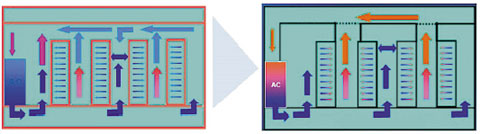

В случае традиционного вычислительного центра стандартно спроектированная система охлаждения помещений плохо отводит теплый воздух и не защищает серверы от перегрева, что приводит к повреждению оборудования и возможным отказам. Путем последовательного разделения холодного и теплого воздуха при соразмерном соотношении давлений (см. Рисунок 6) такой вычислительный центр вместо современных 4 кВт сможет потреблять от 12 до 14 кВт на стойку без изменения инфраструктуры подачи питания.

Нижеследующий пример иллюстрирует, как превратить традиционный вычислительный центр с постоянным объемом воздуха в динамический, оптимизированный центр обработки данных с полноценной системой управления воздушными потоками. Исходные условия: 720 Вт/м2, от 2 до 4 кВт на шкаф, затраты на охлаждение — 35%.

Циркуляцию воздуха можно улучшить за счет установки в шкафах перегородок, грамотно спроектированной прокладки кабеля и размещения выпускных отверстий для воздуха исключительно в двойном полу в тех проходах, где температура достаточно низка.

Следующая мера — разделение подачи и отвода воздуха за счет использования шкафов с отдельным подводом воздуха и организации раздельных коридоров для горячего и холодного воздуха. Тогда из холодных проходов воздух подается внутрь устройства через перфорированные пластины на передней стенке сервера, а в верхней части теплых проходов подогретый воздух высасывается через подобие кухонной вытяжки.

Применение двухуровневого подхода: на одном уровне стоят серверные шкафы с высокой плотностью размещения, на втором (с полной проницаемостью) происходит распределение и подача воздуха.

Благодаря прокладке кабеля по шинной системе, над стойкой в двойном полу остается больше места для холодного воздуха и ничто не препятствует воздушному потоку. Стойки упорядочиваются в соответствии с принципом холодных и теплых проходов.

Результат: 5650 Вт/м2, 15 кВт на шкаф, потери на охлаждение менее 10%!

Вот еще несколько способов оптимизации вычислительного центра:

-

за счет особенностей окружающей среды — к примеру, охлаждение вычислительного центра посредством близлежащих водоемов;

-

использование имеющейся энергии — теплый воздух, поступающий от вычислительных машин, будет обогревать офисные помещения;

-

применение таких видов энергии, при выработке которой не происходит выделение углекислого газа — к примеру, вырабатываемой фотогальваническими или ветровыми устройствами;

-

использование преимуществ имеющихся материалов, к примеру, охлаждение за счет бетонного керна.

Оливер Марк — менеджер по решениям в области вычислительных центров будущего в регионе ЕМЕА в компании Intel.

© AWi Verlag