Неприятности могут произойти и с хорошими узлами Web. К счастью, имеющиеся инструментальные средства позволяют обнаружить и исправить ошибки в интерактивном информационном наполнении.

Если узел Web играет важную роль в деятельности вашей компании, то об его надежности, эффективности и привлекательности вам придется заботиться по крайней мере не меньше, чем об остальных подразделениях. В Виртуальном Мире длительные очереди, медленное обслуживание, невозможность получения помощи, недостаток информации и отсутствие требуемых продуктов раздражают не меньше, чем их аналоги в мире физическом. В некоторых подходах к управлению узлом Web основное внимание уделяется сетевым ресурсам и повышению производительности сети. Продукты такого рода предусматривают распределение нагрузки между серверами, управление пропускной способностью и кэширование. В тех случаях, когда главная причина несвоевременной доставки информационного наполнения связана с пропускной способностью сетевого канала или общей производительностью серверов Web, эти технические решения, безусловно, играют важную роль. В данной статье мы не будем их рассматривать, так как эти вопросы уже обсуждались ранее («Как сделать надежный сервер Web», LAN №5, 1998 г.; «Оптимизация распределения пропускной способности», LAN №2, 1999 г.; «Proxy-серверы», LAN №6, 1999 г.).

При других подходах основное внимание уделяется управлению информационным наполнением узла Web. Один из методов предусматривает использование комплексных средств разработки, таких, как LivePage Enterprise, Vignette StoryServer или ColdFusion компании Allaire. Хотя продукты подобного типа обеспечивают различные формы интегрированного управления информационным наполнением, они требуют строгого соблюдения предлагаемого ими подхода, а он может противоречить архитектуре существующих узлов. Однако рассмотрение всех достоинств и недостатков этих крупномасштабных интегрированных сред также выходит за рамки данной статьи. Чему же тогда посвящена данная статья? Она посвящена продуктам для выявления и, по возможности, устранения проблем с информационным наполнением, наличие которых ведет к снижению качества узла Web.

КОНТРОЛЬ КАЧЕСТВА

Мы часто оцениваем качество узла Web по тому, насколько ценная информация на нем представлена, насколько хорошо написан опубликованный текст, каков общий уровень компетентности узла, о чем мы судим на основании своих впечатлений от текста, изображений, графики и звука. Ни одно из существующих инструментальных средств не способно определить качество информационного наполнения с этой точки зрения, а некоторые специалисты считают, что создать такой инструментарий невозможно в принципе.

Программное обеспечение может определять показатели качества, только если они выражаются через такие характеристики, как скорость, корректность и доступность. В данном случае под скоростью понимается быстрота получения результатов в зависимости от выбора информационного наполнения, а не от пропускной способности сети или программного обеспечения сервера Web. К примеру, дизайн страницы с использованием фреймов, когда на экране ничего не отображается до тех пор, пока последний файл не будет загружен в браузер, естественным образом будет восприниматься как более медленный, нежели дизайн, при котором браузер пользователя может немедленно вывести какую-нибудь информацию на экран.

Задержки при загрузке — традиционно основная причина недовольства пользователей узлами Web. Создатели информационного наполнения Web должны принять своего рода клятву Гиппократа: «Не делай ничего, что может нанести вред скорости загрузки». Размер файла — главная причина медленной загрузки, и важность этого параметра будет сохраняться до тех пор, пока доступ в Internet осуществляется на скорости меньшей, чем скорость ISDN (т. е. ниже 64 Кбит/с). Похоже, что многие уже согласились с тем, что загружать в браузер исполняемые модули Java для анимации текста (или в каких-либо иных целях, за исключением тех случаев, когда они выполняют какую-либо значимую часть работы, которую невозможно сделать иным способом) — это напрасная трата ограниченных ресурсов. Многие из инструментальных средств, с которыми мы познакомимся, могут предоставлять списки файлов, упорядоченные по размеру и типу, и это дает возможность сразу определить, какие из них служат основным препятствием для ускорения работы с информационным наполнением узла.

Потеря корректности имеет две основные причины — это некорректные ссылки и некорректные страницы. Некорректные ссылки могут указывать на URL как на том же самом узле, так и на других узлах, но в любом случае пользователь получает сообщение об ошибке: «404 File not found» («404 Файл не найден»), или его видоизмененный эквивалент, а также крайне негативное впечатление от «сырого», непрофессионально сделанного узла Web. Появление некорректных страниц связано главным образом с ошибками в коде HTML, результатом которых могут быть как незначительные изъяны при отображении страницы (например, появление тега HTML там, где его быть не должно), так и серьезные проблемы, вплоть до того, что страницу нельзя будет загрузить вообще. Большинство пользователей некорректные страницы раздражают не меньше, чем некорректные ссылки.

Причины возникновения некорректных ссылок могут быть самыми разными. Чаще всего подобные ошибки возникают из-за изменения имени файла. Кроме того, десятки, если не сотни некорректных ссылок может породить некорректное изменение имени каталога. Серьезный вред узлу может нанести и перемещение файлов или каталогов, а также добавление новых уровней подкаталогов. Появлением некорректной ссылки чревата любая операция удаления файла. Ссылки на другие узлы особенно уязвимы — администраторы этих узлов могут не знать о том, что вы поместили ссылку на их узел, но, даже если им это известно, они могут счесть необязательным уведомить вас о внесении усовершенствований или модификации своего узла.

К счастью, некорректные ссылки относятся к категории проблем, достаточно легко решаемых программистами. Каждый из многочисленных программных пакетов для проверки корректности ссылок позволяет проанализировать исходный код домашней страницы Web, найти все ссылки и последовательно открыть соответствующие страницы. На каждой следующей странице программное обеспечение снова проверяет все ссылки и т. д. Параллельно все найденные ошибки регистрируются и записываются в файл или базу данных для последующего составления отчета. Такое ПО может иметь целый ряд простых усовершенствований, в частности сужение рамок поиска пределами локального узла, ограничение числа переходов в рамках локального и на удаленные узлы, возможность фильтрации определенного типа URL, например исключение вызовов CGI или включение URL только для потокового видео или относящихся к конкретным каталогам.

Если программа систематически просматривает все страницы узла, следуя по ссылкам, то отказываться от генерации карты или диаграммы узла просто не имеет смысла. Одни детекторы некорректных ссылок генерируют традиционные, тогда как другие — весьма нетривиальные изображения всех структур узла Web, где некорректные ссылки обычно отмечаются особо.

Анализ HTML сводится главным образом к проверке синтаксиса. Хотя такая проверка позволяет идентифицировать многие из некорректных страниц на узле Web, некоторые возможные ошибки, в частности неверные теги или плохо подобранные шрифты, можно заметить только при визуальном контроле. Есть надежда, что развитие XML и четкое отделение инструкций форматирования от информационного наполнения позволят сократить число ошибок форматирования и компоновки.

ФАКТОРЫ ДОСТУПНОСТИ

Доступность — широко пропагандируемое свойство узлов Web, но определить его, особенно на программном уровне, довольно сложно. Специалисты компании WebCriteria (http://www.webcriteria.com), чья деятельность связана с анализом узлов Web (см. врезку «Независимая проверка качества узла Web»), определяют доступность как время, необходимое пользователю для того, чтобы попасть на различные страницы узла. Экспертиза включает в себя проверку всех возможных путей доступа ко всем страницам узла, причем каждый из этих путей получает весовой коэффициент, присваиваемый с учетом объема размещенной на страницах информации и повторяемости (и, как следствие, возможного кэширования) данных по мере перехода пользователя со страницы на страницу. Эта методика позволяет дать количественную оценку и, как следствие, автоматизировать процесс ее получения.

Однако доступность во многом зависит от осмысленности информационного наполнения узла. К примеру, корпоративная домашняя страница наверняка вызовет у пользователей недоумение, если она не будет содержать разделов наподобие «О компании», «Продукты и услуги» и «Как с нами связаться» в качестве стартовых точек навигации по узлу. К сожалению, ни одна программа не способна осуществить логическое разбиение информационного содержимого на разделы таким образом, чтобы их структура максимально облегчала навигацию по узлу.

Некоторые из рассматриваемых в данной статье продуктов способны составить карты узла, параллельно выявляя возможные маршруты. Подготовленные на основе данной информации отчеты могли бы оказаться полезны для улучшения доступности, помогая проектировщикам упростить путь к наиболее популярным частям узла. Конечно, некорректные ссылки и некорректные страницы ухудшают, помимо других неприятных последствий, и доступность узла.

ПРОДУКТЫ ДЛЯ УПРАВЛЕНИЯ ИНФОРМАЦИОННЫМ НАПОЛНЕНИЕМ

Рынок средств управления информационным наполнением пока еще не развит и нестабилен. Некоторые из продуктов являются условно-бесплатными или свободно распространяемыми и загрузить их можно только из Internet. Другие поначалу имели скудную функциональность, но постепенно достигли уровня корпоративного инструментария старшего класса. Еще год назад компания Site Technologies вместе со своим продуктом SiteSweeper была одним из главных претендентов на лидерство в этой категории, но, по всей видимости, она прекратила свое существование. Одним из первых продуктов, генерирующих карту узла и выполняющих проверку корректности ссылок, был WebMapper компании NetCarta. Но в конце 1996 года компанию NetCarta приобрела Microsoft, и если какие-либо из возможностей WebMapper и были сохранены, то они затерялись во Front Page или IIS.

Одной из наиболее известных компаний, работающих в области управления узлами Web, является компания WebTrends (http://www.webtrends.com), чей инструментарий WebTrends Log Analyzer широко используется для анализа трафика и генерации отчетов. Входящие в состав WebTrends Enterprise Suite модули, или «картриджи», позволяют проверять уровень загруженности proxy-сервера, контролировать доступность, измерять производительность потокового аудио и видео и сообщать о производительности серверных кластеров, а также анализировать журнальные файлы с подготовкой отчета о трафике. Основным инструментарием управления информационным наполнением узла является картридж под названием Site Manager.

Site Manager находит некорректные ссылки и некорректные страницы. Он выявляет самые большие по размеру и самые медленные по скорости загрузки страницы. Он способен определять самые новые и самые старые страницы, а также создавать каталог файлов с изображениями в справочных целях. Site Manager интегрируется с инструментальными средствами редактирования, в результате восстановление ссылок и решение других проблем может быть произведено тут же. Наиболее полезной для многих крупных предприятий является возможность Site Manager обращаться к узлам через proxy-сервер или блокировать доступ за proxy-сервер.

|

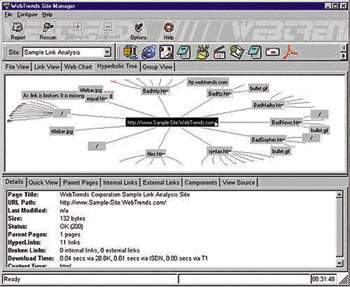

| Рисунок 1. Генерируемое Site Manager компании WebTrends представление в виде гиперболического дерева отображает все страницы узла в уменьшенном виде на одном экране, но позволяет вам перемещаться по структуре и четко проследить каждую ссылку. Некорректные ссылки выделяются красным цветом. |

Site Manager имеет пять режимов представления узла, каждый из которых выделяет определенные характеристики его структуры. Вид по типам файлов организует компоненты узла в Explorer-подобную иерархию в соответствии с типом содержащейся в них информации. Вид на основе ссылок представляет собой список всех ссылок на узле с перечислением файлов, на которые указывает каждая из ссылок. Интерактивная графическая схема Web отражает графическую структуру узла посредством соединения линиями пиктограмм, представляющих компоненты узла. Что такое интерактивное гиперболическое дерево, объяснить довольно сложно, и даже его изображение (см. Рисунок 1) не позволяет сделать этого в полной мере. Достаточно сказать, что это весьма изобретательный способ представления очень сложных графических объектов в понятном и интуитивном двумерном виде. Наконец, групповой вид объединяет некорректные ссылки, внутренние ссылки, внешние ссылки, системные ошибки и ссылки других типов. Site Manager стоит 499 долларов.

Еще один продукт для корпоративного рынка — это Astra Site Manager компании Mercury Interactive (http://www.merc-int.com). Этот продукт генерирует структурные диаграммы узлов Web во время их сканирования, указывая некорректные ссылки и возникающие проблемы доступа. Он также может отображать выявленные различия по сравнению с предыдущим сеансом сканирования. Это весьма полезный способ убедиться, что вы внесли именно те изменения, которые намеревались сделать. Astra может сканировать как динамические, так и статические страницы, заранее вставляя запросы в формы CGI.

Astra Site Manager позволяет получить представление узла с помощью Visual Web Display, Action Tracker, Link Doctor, Change Viewer и Dynamic Scanner. Visual Web Display дает общий вид архитектуры узла, куда включены все его объекты. Action Tracker предоставляет типичную картину обращений к узлу. Link Doctor указывает все некорректные ссылки и обеспечивает интегрированный доступ к выбранному вами редактору для их восстановления. Change Viewer сравнивает карты узла с полученными ранее, а Dynamic Scanner позволяет проверить отображение операций с базой данных и других транзакций посредством генерации на лету страниц с запросами CGI. Mercury Interactive стоит 495 долларов.

|

| Рисунок 2. WebAnalyzer генерирует уникальное представление Wavefront View, где каждая страница располагается на концентрической окружности вокруг домашней страницы. Увеличив масштаб, вы можете увидеть информацию по каждой странице. Выбор страниц приводит к отображению всех ссылок как со страницы, так и на нее. |

Хотя WebAnalyzer 2.01 компании InContext Systems (http://www.incontext.com) предлагает и обычные иерархические списки ссылок и URL, создаваемое им представление Wavefront View совершенно уникально (см. Рисунок 2). Оно начинается с домашней страницы; каждая страница на расстоянии одной ссылки от нее располагается на окружности, в центре которой находится домашняя страница; каждая страница на расстоянии двух ссылок располагается на концентрической окружности, охватывающей первую, и т. д., до произвольного числа уровней. Увеличив изображение Wavefront, вы можете просмотреть конкретные ссылки и, указав на страницу, отобразить данные по этой странице в виде списка. Что выбрать — Wavefront, гиперболические деревья или какие-либо другие графические представления ссылок и ошибок узла Web, в конечном счете, — дело вкуса. WebAnalyzer стоит 299 долларов.

Linkbot Pro 4.0 компании Tetranet Software (http://www.tetranetsoftware.com) предназначен для быстрой всесторонней проверки корректности ссылок. Компания утверждает, что система может проверять сотни тысяч страниц, работая при этом без сбоев. Кроме того, продукт выполняет синтаксический разбор кодов HTML и JavaScript, выявляя десятки различных ошибок. Учитывая направленность продукта, основное представление — это вложенный Explorer-подобный список URL с указателями выявленных ошибок. Linkbot Pro работает как сервис Windows NT, поэтому запланировать регулярные сеансы сканирования и генерации отчетов крайне просто. Если ваш узел насчитывает сотни тысяч объектов, то развитые возможности фильтрации Linkbot Pro могут помочь сделать задачу менее объемной за счет ограничения сферы действия пакета. Лицензия Linkbot Pro на одного пользователя стоит 295 долларов.

Параллельно с тестированием ссылок и выявлением утерянных файлов LinkScan компании Electronic Software Publishing (http://www.elsop.com) проверяет именные теги и указатели (ссылки в пределах одного объекта для перемещения внутри файла). Как и многие другие продукты уровня предприятия, LinkScan можно сконфигурировать так, чтобы он осуществлял доступ к узлам Web через proxy-сервер и анализировал динамические страницы, в том числе и те, где используются CGI, Active Server Pages или ссылки на базы данных. LinkScan позволяет одному пользователю управлять несколькими узлами, а также разделить обязанности по управлению одним узлом между несколькими администраторами. Отчеты об ошибках могут пересылаться по электронной почте человеку, ответственному за работу конкретного узла или его подмножества. LinkScan может сообщать о перенаправлении ссылок, что позволяет менеджеру узла предусмотреть появление некорректных ссылок и предпринять необходимые действия до возникновения ошибки. LinkScan стоит 750 долларов за копию.

Пакет InfoLink Link Checker компании BiggByte Software представляет собой инструментарий для проверки корректности ссылок и распространяется как условно-бесплатный по цене 49,95 долларов (http://www.biggbyte.com). Он поддерживает работу через proxy-сервер и позволяет запланировать регулярную проверку нескольких узлов, а также имеет внутренний браузер.

Link Sleuth компании Xenu поддерживает узлы Web, где используется Secure Sockets Layer (SSL), выявляет и сообщает о перенаправленных URL и имеет исполняемый модуль размером менее 400 Кбайт. Его можно загрузить бесплатно (http://www.snafu.de/~tilman/xenulink.html).

Smart Site 2.0, выпускаемый компанией Big Picture Technologies (http://www.bigpic.com), имеет разнообразные опции конфигурации, с помощью которых пользователи могут более точно настроить процедуру сканирования узла. Он позволяет задавать URL для сканирования с помощью символов подстановки * и ? и устанавливать время прерывания соединений. Параллельно с поиском некорректных ссылок, пропущенных страниц и ошибок в коде HTML он выявляет страницы, загрузка которых может занимать много времени по причине их слишком большого размера. Продукт включает в себя модуль проверки орфографии для нескольких языков. (С правильностью написания в Web всегда были проблемы, по крайней мере это справедливо в отношении английского языка, так что эта возможность может оказаться очень полезной.) Smart Site также анализирует журнальные файлы и генерирует отчеты о шаблонах трафика. Он стоит 189,95 долларов.

Хотя большинство описанных в этой статье продуктов выпускается производителями, весь спектр предложений которых составляет, как максимум, десяток инструментальных средств, ориентированных на Web, тем не менее и одна крупная программная компания все же проявила интерес к управлению информационным наполнением узлов Web — это Computer Associates (CA). Система MasterIT принадлежит к серии выпускаемых CA продуктов под маркой IT на базе общего ядра Unicenter TNG, каждый из которых реализует ряд специальных возможностей управления. К таким специализированным функциям системы MasterIT относится: непрерывный анализ ссылок, анализ трафика и генерация отчетов в реальном времени, мониторинг откликов в реальном времени и мониторинг сервера Web. В отличие от других продуктов, в которых анализ ссылок и файлов регистрации осуществляется постфактум, MasterIT сообщает о событиях в тот момент, когда они происходят. С помощью платформы Unicenter TNG пакет MasterIT может генерировать и посылать эти отчеты по факсу, на пейджер или по электронной почте. Связь с Unicenter способствует также интеграции работы с Web в корпоративную политику и автоматизации исправления ошибок. Версия Workgroup Edition системы MasterIT, вообще говоря, стоит 695 долларов, но пока ее можно бесплатно загрузить с узла Web компании CA.

ПРЕДСКАЗАНИЕ

По мере того как узлы Web будут все шире использоваться в деятельности компаний, значение специализированных инструментальных средств для выявления проблем на статических страницах Web скорее всего постепенно сойдет на нет. Однако интегрированные инструментальные средства, применение которых позволит проверить качество обслуживания потребителей, партнеров, поставщиков и коллег, получающих информацию и осуществляющих транзакции через Web, будут не менее важны, чем любые другие средства увеличения степени удовлетворенности потребителей. Web скоро утратит свою новизну (если это уже не произошло), и потребители уже не будут столь снисходительно относиться к изматывающим техническим операциям.

Стив Штайнке — ответственный редактор Network Magazine. С ним можно связаться по адресу: ssteinke@mfi.com.Рассматриваемые продукты

| BiggByte Software InfoLink Link Checker http://www.biggbyte.com/index.html | Big Picture Technologies Smart Site 2.0 http://www.bigpic.com | Computer Associates MasterIT http://www.cai.com | |

Electronic Software Publishing LinkScan http://www.elsop.com | InContext Systems WebAnalyzer 2.01 http://www.incontext.com | Mercury Interactive Astra Site Manager http://www.merc-int.com | |

| Tetranet Software Linkbot Pro 4.0 http://www.tetranetsoftware.com | WebTrends WebTrends Enterprise Suite http://www.webtrends.com | Xenu Link Sleuth http://www.snafu.de/~tilman/xenulink.html |

Ресурсы Internet

The Web Developer?s Journal — это интерактивный журнал, где публикуются обзоры по различным инструментальным средствам управления для узлов Web, в том числе по условно-бесплатным и свободно распространяемым программам (http://Webdevelopersjournal.com/software/site_management_tools.html).

Одно из полезных инструментальных средств, предлагаемых консорциумом World Wide Web Consortium (W3C), представляет собой модуль оперативной генерации отчетов о корректности кода HTML. Вы просто указываете URL страницы Web и получаете информацию об ее соответствии стандарту. Модуль можно найти по адресу: http://validator.w3.org.

Независимая проверка качества узла Web

Менеджеры Web могут выявить некорректные ссылки, исправить ошибки в коде HTML, сократить размер файлов и установить картину обращений с большой степенью подробности, но так и не получить при этом объективного представления о том, как пользователи воспринимают их сервер и как он выглядит на фоне других. Компания WebCriteria (http://www.webcriteria.com) предлагает владельцам и менеджерам узлов Web возможность составить объективную картину.

Для определения качества компания выбрала четыре критерия: время загрузки, доступность, новизна информации и структура. Компания сосредотачивает внимание на самом узле и не учитывает влияния сетей связи и поведения пользователей.

Для измерения времени загрузки WebCriteria анализирует число элементов на странице, количество повторяющихся элементов при переходе от одной страницы к следующей, суммарный объем всех элементов, доступную для пользователя пропускную способность и число путей, по которым можно попасть на страницу. В WebCriteria доступность связана исключительно с навигацией по узлу и не имеет никакого отношения к тому, насколько понятен материал или насколько прозрачна логика организации узла. Уровень доступности определяется на основании кратчайшего пути к каждой странице узла с учетом времени загрузки и количества необходимых для этого переходов.

Оперативность информационного наполнения WebCriteria определяет путем проверки даты «последнего изменения» элементов узла. Для динамически генерируемых страниц HTML дата последнего изменения никакой смысловой нагрузки не несет, хотя для большинства других объектов она имеет значение.

Композиция для WebCriteria — это мера разнообразия ситуаций, с которыми пользователю приходится сталкиваться при просмотре узла. Разнообразие зависит от таких элементов, как текст, графика, аудио, видео, апплеты и файлы, которые требуется загружать. Однако сам по себе размер файлов — неадекватная мера восприятия пользователя, поэтому WebCriteria разработала «агент поведения при просмотре» для имитации обращения посетителей узла к этим различным элементам.

Чтобы создать SiteProfile Report, WebCriteria сначала посылает программного «паука» для сбора данных об узле. Программное обеспечение с помощью агента поведения при просмотре сканирует все содержимое узла и собирает всю необходимую информацию, объем которой часто достигает 100 Мбайт. Разработчики WebCriteria позаботились о максимальном уменьшении воздействия операции сбора данных на производительности узла. На «фабрике» компании WebCriteria в Портленде информация об узле Web используется для создания модели исходного узла. Затем агент просмотра свободно «гуляет» по модели для определения времени загрузки, готовности, новизны информации и структуры. Обработанные результаты такого просмотра модели, в свою очередь, используются для составления 16-страничного отчета, куда включается анализ трех узлов Web по выбору потребителя и результаты тестирования компании, чья деятельность аналогична вашей.

Безусловно, моделирование и оценка качества узлов Web пока находятся на ранней стадии своего развития, но попытки WebCriteria предоставить объективный, воспроизводимый отчет — первый шаг в правильном направлении.