Модель, разработанная специалистами МТИ и Microsoft, определяет случаи, когда происходящее в реальном мире похоже на ситуацию из обучающей выборки, но действие, которое для этой ситуации запомнила автономная система, может привести к опасной ошибке.

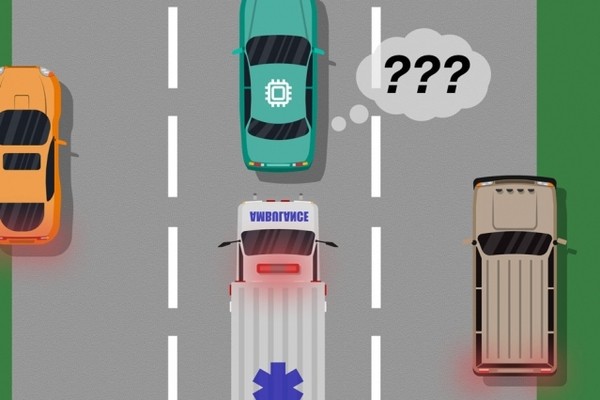

Исследователи приводят пример: если робомобиль не научили отличать скорую помощь от других машин того же цвета и формы, то самоуправляемая система не пропустит догоняющую ее «скорую» со включенной мигалкой. Ученые описывают метод, позволяющий обнаруживать подобные «слепые пятна» обучения.

Вначале систему автопилота обучают на симуляторе, в котором смоделированы все возможные ситуации на дороге. На втором этапе человек наблюдает за работой системы в реальных условиях и сигнализирует о всех допущенных ошибках. Результатом становится перечень ситуаций, каждая с некоторым числом отметок о приемлемости или неприемлемости действий автопилота.

После этого выполняется статистическая обработка результатов с обнаружением закономерностей соотношения разных меток у неоднозначных и безопасных ситуаций. Опираясь на эти сведения, модель генерирует единственную метку «слепое пятно» или «безопасная ситуация» для каждого случая, сопровождая ее показателем вероятности. Исследователи отмечают, что даже если в некоторой ситуации в 90% случаев автопилот принял верное решение, модель после обучения все равно может классифицировать ее как слепое пятно.

.jpg)